中文谣言数据|社交媒体数据集|谣言分析数据集

收藏数据集概述

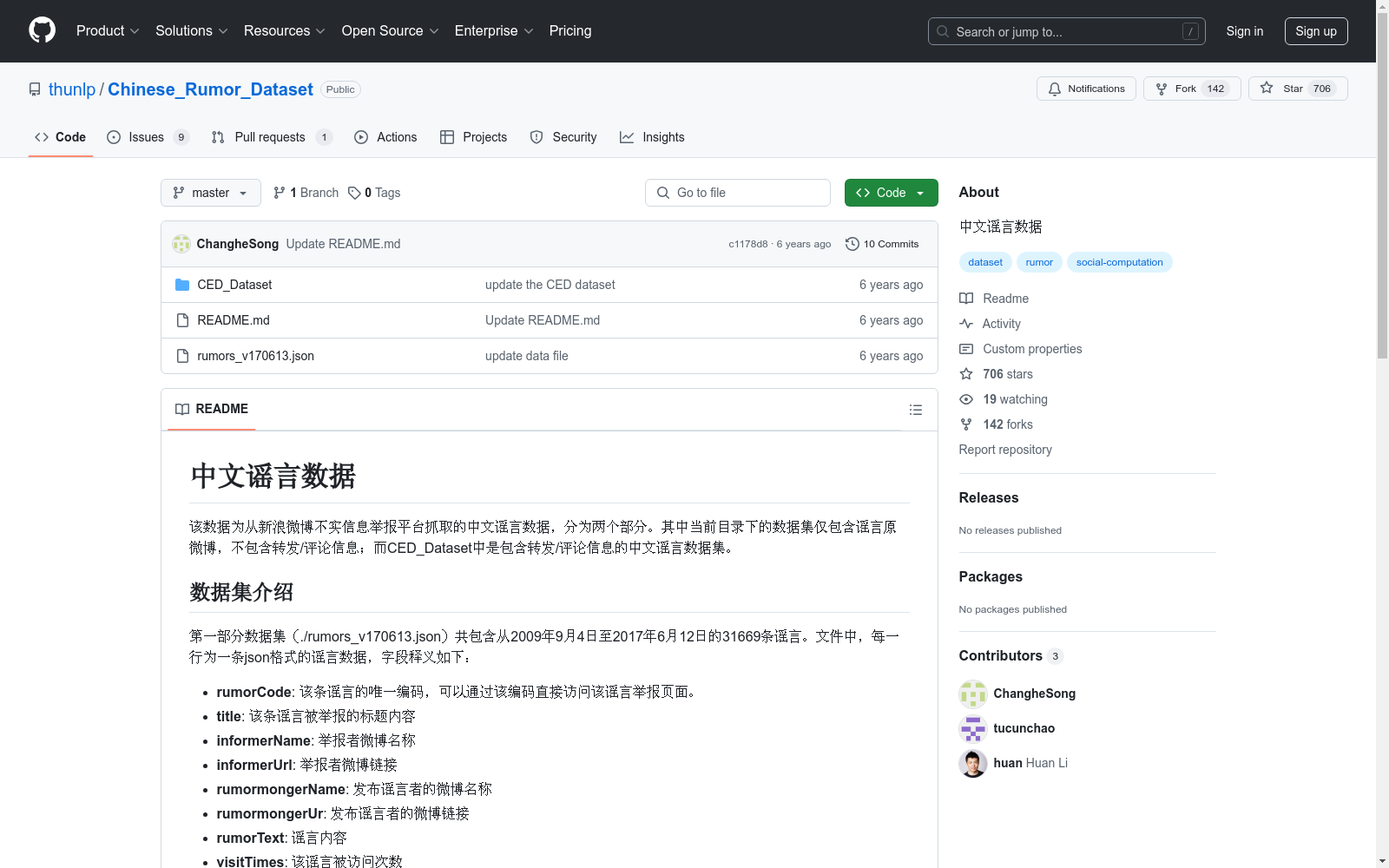

第一部分数据集

- 名称: 中文谣言数据(./rumors_v170613.json)

- 时间范围: 2009年9月4日至2017年6月12日

- 记录数量: 31669条谣言

- 数据格式: JSON

- 字段释义:

- rumorCode: 谣言唯一编码

- title: 谣言标题

- informerName: 举报者微博名称

- informerUrl: 举报者微博链接

- rumormongerName: 发布谣言者的微博名称

- rumormongerUr: 发布谣言者的微博链接

- rumorText: 谣言内容

- visitTimes: 谣言被访问次数

- result: 谣言审查结果

- publishTime: 谣言被举报时间

第二部分数据集

- 名称: CED_Dataset

- 记录数量: 谣言1538条,非谣言1849条

- 数据结构: 分为微博原文与其转发/评论内容

- 数据格式: JSON

- 字段释义:

- 微博原文信息:

- text: 微博原文内容

- user: 发布用户信息

- time: 发布时间(时间戳格式)

- 转发/评论信息:

- uid: 用户ID

- text: 转发/评论内容

- data: 发布时间(格式如:2014-07-24 14:37:38)

- 微博原文信息:

中国1km分辨率逐月降水量数据集(1901-2023)

该数据集为中国逐月降水量数据,空间分辨率为0.0083333°(约1km),时间为1901.1-2023.12。数据格式为NETCDF,即.nc格式。该数据集是根据CRU发布的全球0.5°气候数据集以及WorldClim发布的全球高分辨率气候数据集,通过Delta空间降尺度方案在中国降尺度生成的。并且,使用496个独立气象观测点数据进行验证,验证结果可信。本数据集包含的地理空间范围是全国主要陆地(包含港澳台地区),不含南海岛礁等区域。为了便于存储,数据均为int16型存于nc文件中,降水单位为0.1mm。 nc数据可使用ArcMAP软件打开制图; 并可用Matlab软件进行提取处理,Matlab发布了读入与存储nc文件的函数,读取函数为ncread,切换到nc文件存储文件夹,语句表达为:ncread (‘XXX.nc’,‘var’, [i j t],[leni lenj lent]),其中XXX.nc为文件名,为字符串需要’’;var是从XXX.nc中读取的变量名,为字符串需要’’;i、j、t分别为读取数据的起始行、列、时间,leni、lenj、lent i分别为在行、列、时间维度上读取的长度。这样,研究区内任何地区、任何时间段均可用此函数读取。Matlab的help里面有很多关于nc数据的命令,可查看。数据坐标系统建议使用WGS84。

国家青藏高原科学数据中心 收录

PQAref

PQAref数据集是一个用于生物医学领域参考问答任务的数据集,旨在微调大型语言模型。该数据集包含三个部分:指令(问题)、摘要(从PubMed检索的相关摘要,包含PubMed ID、摘要标题和内容)和答案(预期答案,包含PubMed ID形式的参考)。数据集通过半自动方式创建,利用了PubMedQA数据集中的问题。

huggingface 收录

红外谱图数据库

收集整理红外谱图实验手册等数据,建成了红外谱图数据库。本数据库收录了常见化合物的红外谱图。主要包括化合物数据和对应的红外谱图数据。其中,原始红外谱图都进行了数字化处理,从而使谱峰检索成为可能。用户可以在数据库中检索指定化合物的谱图,也可以提交谱图/谱峰数据,以检索与之相似的谱图数据,以协助进行谱图鉴定。

国家基础学科公共科学数据中心 收录

LIDC-IDRI

LIDC-IDRI 数据集包含来自四位经验丰富的胸部放射科医师的病变注释。 LIDC-IDRI 包含来自 1010 名肺部患者的 1018 份低剂量肺部 CT。

OpenDataLab 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录