lmms-lab/POPE|多模态模型数据集|视觉语言模型数据集

收藏数据集概述

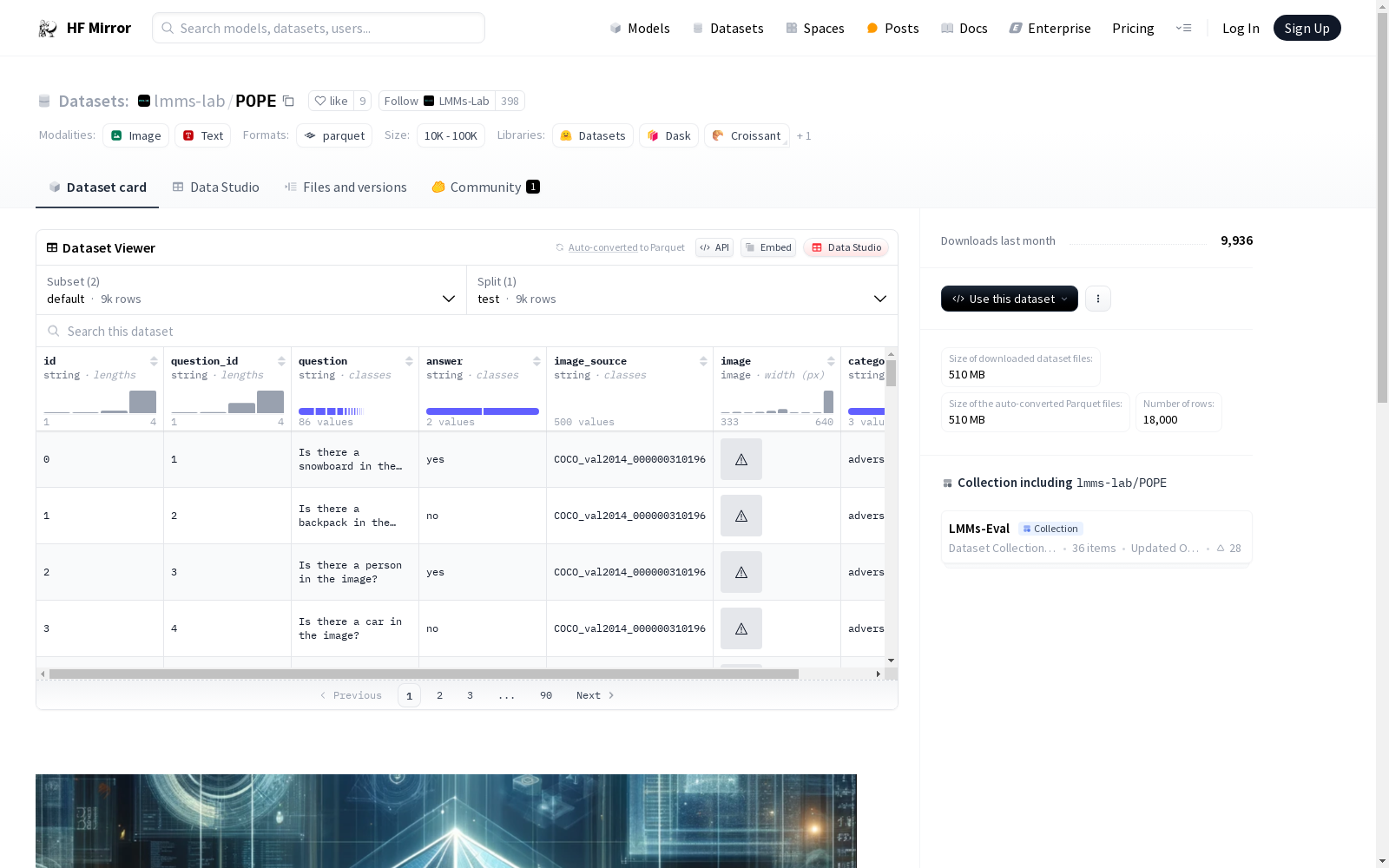

数据集配置

Full 配置

- 特征:

- id: 字符串

- question_id: 字符串

- question: 字符串

- answer: 字符串

- image_source: 字符串

- image: 图像

- category: 字符串

- 分割:

- adversarial: 490408158.0 字节, 3000 个样本

- popular: 490397000.0 字节, 3000 个样本

- random: 490394976.0 字节, 3000 个样本

- 下载大小: 255022914 字节

- 数据集大小: 1471200134.0 字节

default 配置

- 特征:

- id: 字符串

- question_id: 字符串

- question: 字符串

- answer: 字符串

- image_source: 字符串

- image: 图像

- category: 字符串

- 分割:

- test: 1471200135.0 字节, 9000 个样本

- 下载大小: 255022914 字节

- 数据集大小: 1471200135.0 字节

数据文件

Full 配置

- 数据文件:

- adversarial: Full/adversarial-*

- popular: Full/popular-*

- random: Full/random-*

default 配置

- 数据文件:

- test: data/test-*

中国劳动力动态调查

“中国劳动力动态调查” (China Labor-force Dynamics Survey,简称 CLDS)是“985”三期“中山大学社会科学特色数据库建设”专项内容,CLDS的目的是通过对中国城乡以村/居为追踪范围的家庭、劳动力个体开展每两年一次的动态追踪调查,系统地监测村/居社区的社会结构和家庭、劳动力个体的变化与相互影响,建立劳动力、家庭和社区三个层次上的追踪数据库,从而为进行实证导向的高质量的理论研究和政策研究提供基础数据。

中国学术调查数据资料库 收录

rpi_test

该数据集为HuggingFace LeRobot格式机器人数据集。

huggingface 收录

MeSH

MeSH(医学主题词表)是一个用于索引和检索生物医学文献的标准化词汇表。它包含了大量的医学术语和概念,用于描述医学文献中的主题和内容。MeSH数据集包括主题词、副主题词、树状结构、历史记录等信息,广泛应用于医学文献的分类和检索。

www.nlm.nih.gov 收录

糖尿病预测数据集

糖尿病相关的医学研究或者健康数据

AI_Studio 收录

M4-SAR

M4-SAR是一个多分辨率、多极化、多场景、多源数据集,用于光学与合成孔径雷达(SAR)融合的目标检测。该数据集由南京理工大学PCA实验室、安徽大学ICSP教育部重点实验室和南开大学计算机科学学院共同构建,包含112,184对精确对齐的图像和近一百万个标注实例。数据集覆盖六个关键类别,并使用公开的光学和SAR数据,包括Sentinel-1和Sentinel-2卫星提供的数据。为了克服SAR标注的挑战,该研究提出了一种半监督的光学辅助标注策略,利用光学图像的语义丰富性来显著提高标注质量。M4-SAR数据集旨在解决现有光学和SAR数据集的局限性,为多源融合目标检测任务提供大规模、高质量、标准化的数据集,并推动相关研究的发展。

arXiv 收录