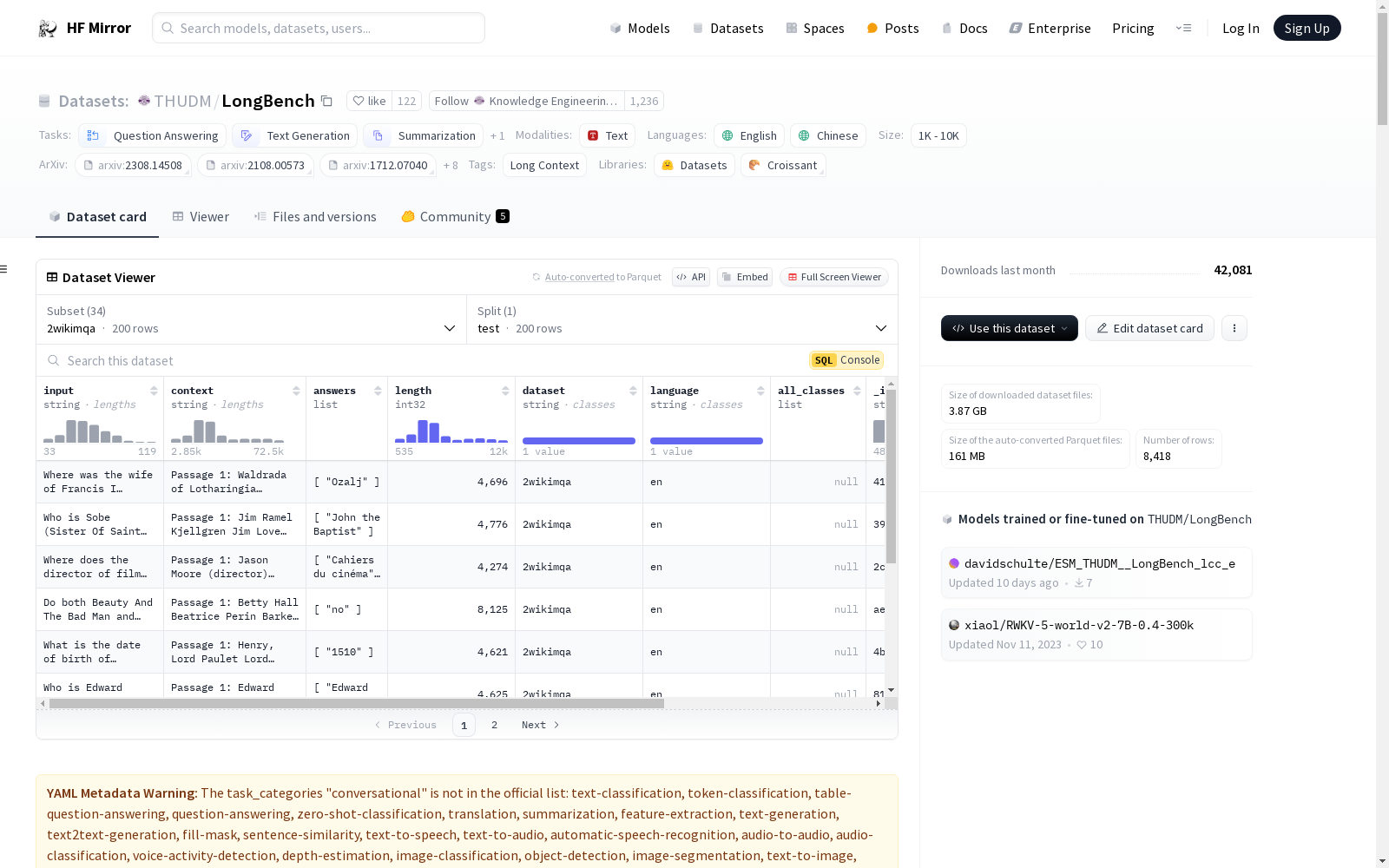

THUDM/LongBench|长上下文理解数据集|多语言多任务数据集

收藏数据集概述

LongBench 是一个双语、多任务的基准测试数据集,用于评估大型语言模型对长上下文理解的能力。该数据集包含中文和英文两种语言,涵盖了多种长文本应用场景,如单文档问答、多文档问答、摘要、少样本学习、合成任务和代码完成等。

数据集特点

- 任务类别:包括问答、文本生成、摘要、对话、文本分类等。

- 语言:支持中文和英文。

- 标签:涉及长上下文。

- 数据集大小:包含1K至10K的数据量。

数据集构成

- 任务数量:共包含21个不同的任务,分为六大类。

- 数据量:总共有4,750个测试数据。

- 平均长度:大多数任务的平均长度在5k至15k之间。

数据集使用

- 数据加载:可通过Python的

load_dataset函数从THUDM/LongBench加载数据。 - 数据格式:所有数据标准化为JSON格式,包含输入、上下文、答案、长度、数据集名称、语言等信息。

评估方法

- 自动化评估:采用自动化方法评估模型对长上下文的理解能力,以降低成本。

任务统计

- 任务类型:包括单文档问答、多文档问答、摘要、少样本学习、合成任务和代码完成等。

- 评估指标:如F1分数、Rouge-L等。

- 平均长度:根据任务不同,平均长度从1,235到22,337不等。

任务描述

- 具体任务:如HotpotQA、2WikiMultihopQA等,每个任务都有详细的描述和特定的应用场景。

LongBench-E统计

- 数据分布:在0-4k、4-8k、8k+长度区间内,数据分布均匀,用于分析模型在不同输入长度下的性能变化。

数据集详细信息

任务统计

| 任务 | 任务类型 | 评估指标 | 平均长度 | 语言 | 样本数 |

|---|---|---|---|---|---|

| HotpotQA | Multi-doc QA | F1 | 9,151 | EN | 200 |

| 2WikiMultihopQA | Multi-doc QA | F1 | 4,887 | EN | 200 |

| MuSiQue | Multi-doc QA | F1 | 11,214 | EN | 200 |

| DuReader | Multi-doc QA | Rouge-L | 15,768 | ZH | 200 |

| MultiFieldQA-en | Single-doc QA | F1 | 4,559 | EN | 150 |

| MultiFieldQA-zh | Single-doc QA | F1 | 6,701 | ZH | 200 |

| NarrativeQA | Single-doc QA | F1 | 18,409 | EN | 200 |

| Qasper | Single-doc QA | F1 | 3,619 | EN | 200 |

| GovReport | Summarization | Rouge-L | 8,734 | EN | 200 |

| QMSum | Summarization | Rouge-L | 10,614 | EN | 200 |

| MultiNews | Summarization | Rouge-L | 2,113 | EN | 200 |

| VCSUM | Summarization | Rouge-L | 15,380 | ZH | 200 |

| TriviaQA | Few shot | F1 | 8,209 | EN | 200 |

| SAMSum | Few shot | Rouge-L | 6,258 | EN | 200 |

| TREC | Few shot | Accuracy | 5,177 | EN | 200 |

| LSHT | Few shot | Accuracy | 22,337 | ZH | 200 |

| PassageRetrieval-en | Synthetic | Accuracy | 9,289 | EN | 200 |

| PassageCount | Synthetic | Accuracy | 11,141 | EN | 200 |

| PassageRetrieval-zh | Synthetic | Accuracy | 6,745 | ZH | 200 |

| LCC | Code | Edit Sim | 1,235 | Python/C#/Java | 500 |

| RepoBench-P | Code | Edit Sim | 4,206 | Python/Java | 500 |

任务描述

| 任务 | 任务描述 |

|---|---|

| HotpotQA | 基于多个给定文档回答相关问题 |

| 2WikiMultihopQA | 基于多个给定文档回答相关问题 |

| MuSiQue | 基于多个给定文档回答相关问题 |

| DuReader | 基于多个检索到的文档回答相关中文问题 |

| MultiFieldQA-en | 基于一篇长文章回答英语问题,文章来自相对多样化的领域 |

| MultiFieldQA-zh | 基于一篇长文章回答中文问题,文章来自相对多样化的领域 |

| NarrativeQA | 基于故事或剧本回答问题,包括理解重要元素如角色、情节、主题等 |

| Qasper | 基于一篇NLP研究论文回答问题,问题由NLP实践者提出和回答 |

| GovReport | 需要总结政府工作报告的摘要任务 |

| MultiNews | 需要总结多篇新闻的多文档摘要任务 |

| QMSum | 需要基于用户查询总结会议记录的摘要任务 |

| VCSUM | 需要总结中文会议记录的摘要任务 |

| SAMSum | 对话摘要任务,提供几个少样本示例 |

| TriviaQA | 单文档问答任务,提供几个少样本示例 |

| TREC | 需要对问题进行分类的分类任务,总共包含50个类别 |

| LSHT | 需要对新闻进行分类的中文分类任务,总共包含24个类别 |

| PassageRetrieval-en | 给定30篇英文维基百科段落,确定哪一段落与给定摘要相对应 |

| PassageCount | 确定给定重复文章中不同段落总数 |

| PassageRetrieval-zh | 给定几个来自C4数据集的中文段落,确定哪一段落与给定摘要相对应 |

| LCC | 给定一段长代码,预测下一段代码 |

| RepoBench-P | 给定一个GitHub仓库中的多文件代码(包括跨文件依赖),预测下一段代码 |

LongBench-E统计

| 任务 | 任务类型 | 0-4k数据量 | 4-8k数据量 | 8k+数据量 |

|---|---|---|---|---|

| HotpotQA | Multi-doc QA | 100 | 100 | 100 |

| 2WikiMultihopQA | Multi-doc QA | 100 | 100 | 100 |

| MultiFieldQA-en | Single-doc QA | 67 | 70 | 13 |

| Qasper | Single-doc QA | 100 | 100 | 24 |

| GovReport | Summarization | 100 | 100 | 100 |

| MultiNews | Summarization | 100 | 100 | 94 |

| TriviaQA | Few shot | 100 | 100 | 100 |

| SAMSum | Few shot | 100 | 100 | 100 |

| TREC | Few shot | 100 | 100 | 100 |

| PassageRetrieval-en | Synthetic | 100 | 100 | 100 |

| PassageCount | Synthetic | 100 | 100 | 100 |

| LCC | Code | 100 | 100 | 100 |

| RepoBench-P | Code | 100 | 100 | 100 |

数据集引用

@misc{bai2023longbench, title={LongBench: A Bilingual, Multitask Benchmark for Long Context Understanding}, author={Yushi Bai and Xin Lv and Jiajie Zhang and Hongchang Lyu and Jiankai Tang and Zhidian Huang and Zhengxiao Du and Xiao Liu and Aohan Zeng and Lei Hou and Yuxiao Dong and Jie Tang and Juanzi Li}, year={2023}, eprint={2308.14508}, archivePrefix={arXiv}, primaryClass={cs.CL} }

UniProt

UniProt(Universal Protein Resource)是全球公认的蛋白质序列与功能信息权威数据库,由欧洲生物信息学研究所(EBI)、瑞士生物信息学研究所(SIB)和美国蛋白质信息资源中心(PIR)联合运营。该数据库以其广度和深度兼备的蛋白质信息资源闻名,整合了实验验证的高质量数据与大规模预测的自动注释内容,涵盖从分子序列、结构到功能的全面信息。UniProt核心包括注释详尽的UniProtKB知识库(分为人工校验的Swiss-Prot和自动生成的TrEMBL),以及支持高效序列聚类分析的UniRef和全局蛋白质序列归档的UniParc。其卓越的数据质量和多样化的检索工具,为基础研究和药物研发提供了无可替代的支持,成为生物学研究中不可或缺的资源。

www.uniprot.org 收录

OpenPose

OpenPose数据集包含人体姿态估计的相关数据,主要用于训练和评估人体姿态检测算法。数据集包括多视角的图像和视频,标注了人体关键点位置,适用于研究人体姿态识别和动作分析。

github.com 收录

马达加斯加岛 – 世界地理数据大百科辞条

马达加斯加岛在非洲的东南部,位于11o56′59″S - 25o36′25″S及43o11′18″E - 50o29′36″E之间。通过莫桑比克海峡与位于非洲大陆的莫桑比克相望,最近距离为415千米。临近的岛屿分别为西北部的科摩罗群岛、北部的塞舌尔群岛、东部的毛里求斯岛和留尼汪岛等。在google earth 2015年遥感影像基础上研发的马达加斯加海岸线数据集表明,马达加斯加岛面积591,128.68平方千米,其中马达加斯加本岛面积589,015.06平方千米,周边小岛面积为2,113.62平方千米。马达加斯加本岛是非洲第一大岛,是仅次于格陵兰、新几内亚岛和加里曼丹岛的世界第四大岛屿。岛的形状呈南北走向狭长纺锤形,南北向长1,572千米;南北窄,中部宽,最宽处达574千米。海岸线总长16,309.27千米, 其中马达加斯加本岛海岸线长10,899.03千米,周边小岛海岸线长5,410.24千米。马达加斯加岛属于马达加斯加共和国。全国共划分22个区,119个县。22个区分别为:阿那拉芒加区,第亚那区,上马齐亚特拉区,博爱尼区,阿齐那那那区,阿齐莫-安德列发那区,萨瓦区,伊达西区,法基南卡拉塔区,邦古拉法区,索非亚区,贝齐博卡区,梅拉基区,阿拉奥特拉-曼古罗区,阿那拉兰基罗富区,阿莫罗尼马尼亚区,法土法韦-非图韦那尼区,阿齐莫-阿齐那那那区,伊霍罗贝区,美那贝区,安德罗伊区和阿诺西区。首都安塔那那利佛(Antananarivo)位于岛屿的中东部。马达加斯加岛是由火山及喀斯特地貌为主。贯穿海岛的是巨大火山岩山体-察腊塔纳山,其主峰马鲁穆库特鲁山(Maromokotro)海拔2,876米,是全国最高峰。马达加斯加自然景观垂直地带性分异显著,是热带雨林和热带草原广布的地区。岛上大约有20多万种动植物,其中包括马达加斯加特有物种狐猴(Lemur catta)、马达加斯加国树猴面包树(Adansonia digitata L.)等。

国家对地观测科学数据中心 收录

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

NuminaMath-CoT

数据集包含约86万道数学题目,每道题目的解答都采用思维链(Chain of Thought, CoT)格式。数据来源包括中国高中数学练习题以及美国和国际数学奥林匹克竞赛题目。数据主要从在线考试试卷PDF和数学讨论论坛收集。处理步骤包括从原始PDF中进行OCR识别、分割成问题-解答对、翻译成英文、重新对齐以生成CoT推理格式,以及最终答案格式化。

huggingface 收录