COCO数据集|图像识别数据集|计算机视觉数据集

收藏github2019-02-20 更新2024-05-31 收录

下载链接:

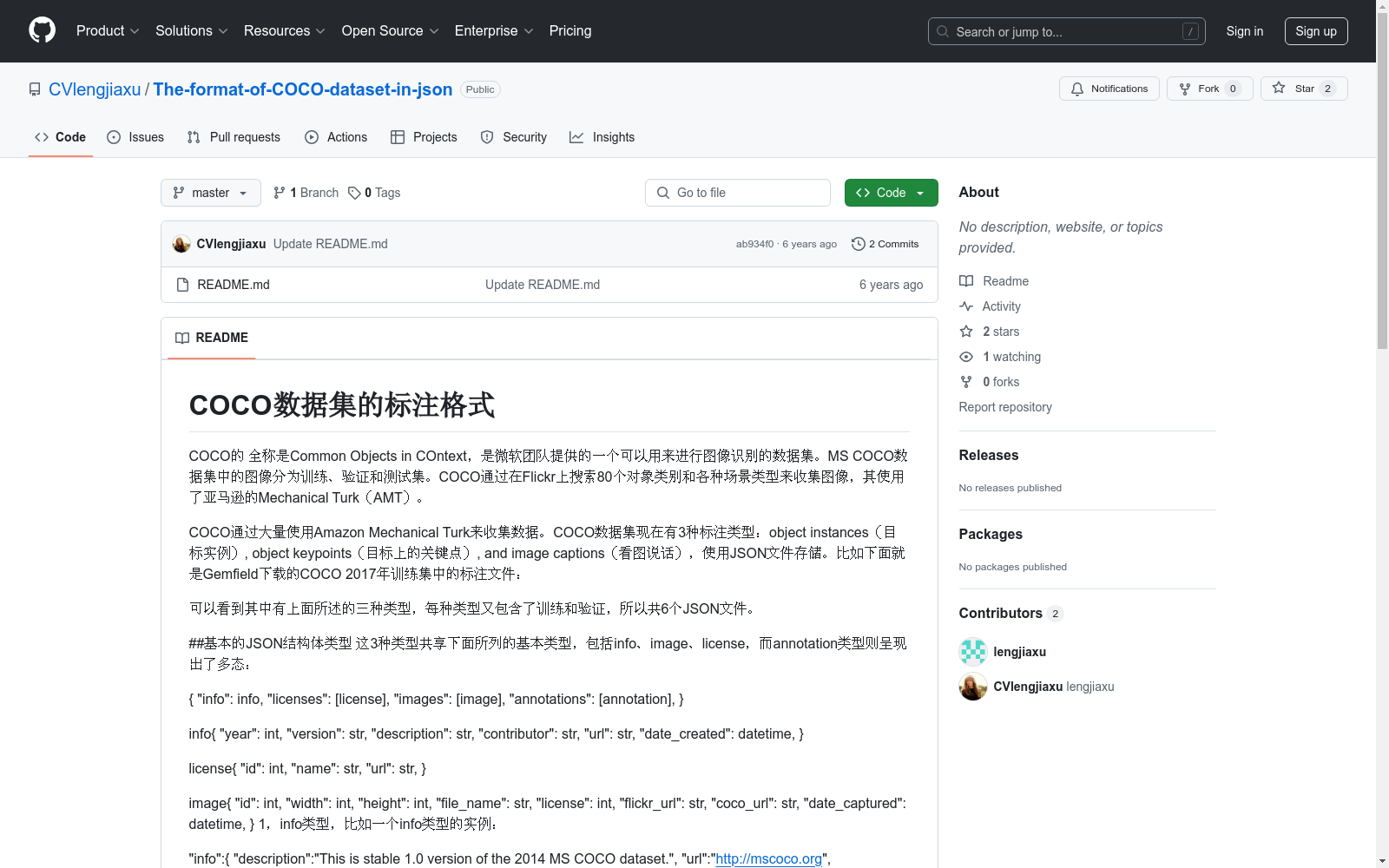

https://github.com/CVlengjiaxu/The-format-of-COCO-dataset-in-json

下载链接

链接失效反馈资源简介:

COCO数据集,全称Common Objects in COntext,是微软团队提供的一个用于图像识别的大型数据集。它包含了80个对象类别和多种场景类型的图像,通过在Flickr上搜索并使用Amazon Mechanical Turk进行数据收集。数据集分为训练、验证和测试集,并提供了三种标注类型:目标实例、目标上的关键点和看图说话,所有数据均使用JSON文件存储。

The COCO dataset, short for Common Objects in COntext, is a large-scale dataset for image recognition provided by the Microsoft team. It encompasses images of 80 object categories and various scene types, collected through searches on Flickr and data gathering via Amazon Mechanical Turk. The dataset is divided into training, validation, and test sets, and offers three types of annotations: object instances, keypoints on objects, and image captions. All data is stored in JSON files.

创建时间:

2018-09-13

原始信息汇总

COCO数据集概述

数据集名称与全称

- 名称:COCO数据集

- 全称:Common Objects in COntext

数据集来源与收集方式

- 来源:由微软团队提供

- 收集方式:通过在Flickr上搜索80个对象类别和各种场景类型,使用Amazon Mechanical Turk进行数据收集

数据集内容与标注类型

- 内容:包含图像识别相关的数据

- 标注类型:

- Object instances(目标实例)

- Object keypoints(目标上的关键点)

- Image captions(看图说话)

- 存储格式:JSON文件

数据集结构与文件类型

- 结构:数据集分为训练、验证和测试集

- 文件类型:包含6个JSON文件,分别对应三种标注类型的训练和验证集

JSON文件结构

-

基本结构: json { "info": info, "licenses": [license], "images": [image], "annotations": [annotation] }

-

info类型:包含年份、版本、描述、贡献者、URL和创建日期等信息

-

license类型:包含ID、名称和URL

-

image类型:包含ID、宽度、高度、文件名、许可证、Flickr URL、COCO URL和捕获日期

Object Instance 类型的标注格式

-

文件格式: json { "info": info, "licenses": [license], "images": [image], "annotations": [annotation], "categories": [category] }

-

annotations字段:包含多个annotation实例,每个实例包含ID、image_id、category_id、segmentation、area、bbox和iscrowd等字段

-

categories字段:包含多个category实例,每个实例包含ID、名称和supercategory

数据集特点

- 特点:数据集通过大量使用Amazon Mechanical Turk进行标注,支持多种标注类型,使用JSON格式存储,便于数据处理和分析。

AI搜集汇总

数据集介绍

构建方式

COCO数据集通过在Flickr上搜索80个对象类别和各种场景类型来收集图像,并利用Amazon Mechanical Turk(AMT)进行数据标注。该数据集分为训练、验证和测试集,涵盖了三种标注类型:目标实例、目标关键点和图像描述。这些标注信息以JSON格式存储,确保了数据的高效组织和灵活使用。

特点

COCO数据集的显著特点在于其丰富的标注类型和多样的图像内容。它不仅包含了目标实例的边界框和分割掩码,还提供了目标关键点的标注,适用于姿态估计等高级任务。此外,图像描述的标注使得该数据集在自然语言处理与计算机视觉的交叉领域中具有广泛的应用潜力。

使用方法

使用COCO数据集时,用户可以通过解析JSON文件获取图像的详细信息和标注数据。每种标注类型都有其特定的JSON结构,用户可以根据需求提取相应的信息。例如,对于目标实例的标注,用户可以获取每个对象的类别ID、分割掩码和边界框信息。此外,数据集的图像和标注信息可以通过编程接口进行访问,便于在各种机器学习和深度学习框架中进行模型训练和评估。

背景与挑战

背景概述

COCO数据集,全称为Common Objects in COntext,由微软团队于2014年创建,旨在为图像识别领域提供一个全面且多样化的数据集。该数据集通过在Flickr上搜索80个对象类别和各种场景类型来收集图像,并利用亚马逊的Mechanical Turk进行数据标注。COCO数据集不仅包含目标实例的标注,还涵盖了目标关键点和图像描述,极大地丰富了图像识别任务的多样性。其发布后,迅速成为计算机视觉领域的重要基准,推动了图像分类、目标检测和语义分割等技术的进步。

当前挑战

尽管COCO数据集在图像识别领域具有重要影响力,但其构建过程中仍面临诸多挑战。首先,数据集的多样性和复杂性要求高精度的标注,这依赖于大量的人工参与,增加了数据收集和处理的难度。其次,不同类型的标注(如目标实例、关键点和图像描述)需要统一且灵活的标注格式,以确保数据的一致性和可用性。此外,随着图像识别技术的不断发展,COCO数据集需要持续更新和扩展,以保持其前沿性和实用性,这对数据维护和更新提出了更高的要求。

常用场景

经典使用场景

COCO数据集在计算机视觉领域中被广泛应用于图像识别、目标检测和语义分割等任务。其丰富的标注信息,包括目标实例、关键点和图像描述,使得研究人员能够开发和验证各种先进的算法。例如,通过使用COCO数据集,研究人员可以训练深度学习模型以识别图像中的多个对象,并精确地定位它们的位置。

实际应用

在实际应用中,COCO数据集被广泛用于自动驾驶、智能监控和增强现实等领域。例如,自动驾驶系统需要精确识别和定位道路上的各种对象,COCO数据集的丰富标注信息为此提供了强大的支持。在智能监控中,通过分析监控视频中的对象和行为,可以有效提升安全性和管理效率。增强现实应用则依赖于对现实世界对象的精确识别和定位,以实现更逼真的虚拟叠加效果。

衍生相关工作

COCO数据集的发布催生了大量相关的经典工作。例如,许多基于深度学习的目标检测算法,如Faster R-CNN、YOLO和SSD,都使用COCO数据集进行训练和评估。此外,COCO数据集还推动了图像描述生成技术的发展,如Show and Tell模型和基于注意力机制的图像描述生成方法。这些工作不仅在学术界产生了深远影响,也在工业界得到了广泛应用。

以上内容由AI搜集并总结生成