The HellaSwag Dataset|自然语言处理数据集|常识推理数据集

收藏rowanzellers.com2024-11-02 收录

下载链接:

https://rowanzellers.com/hellaswag/

下载链接

链接失效反馈资源简介:

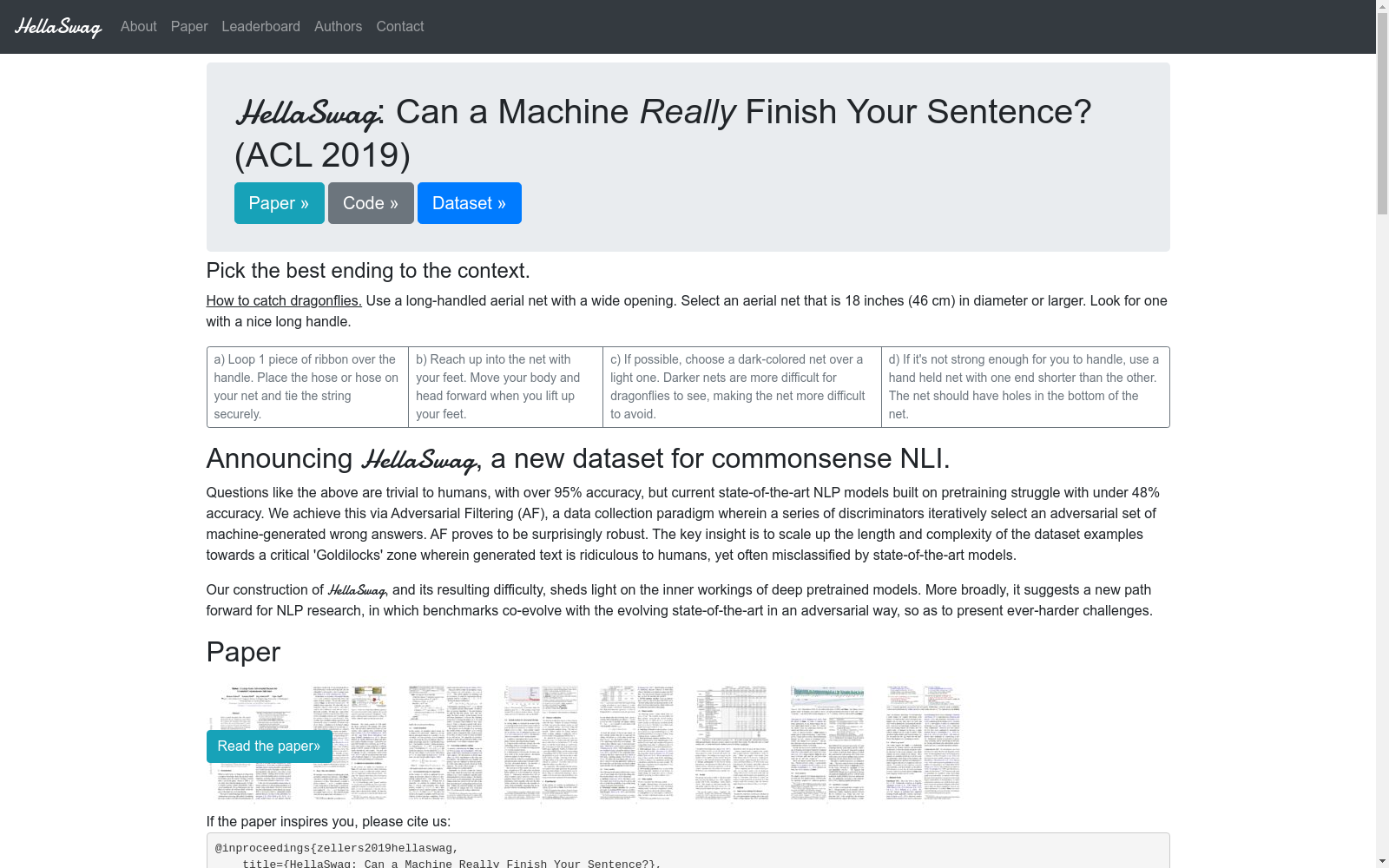

The HellaSwag Dataset是一个用于评估自然语言理解能力的基准数据集,主要用于测试模型在常识推理方面的表现。该数据集包含多个任务,要求模型判断给定的上下文和选项中哪一个最符合常识。

提供机构:

rowanzellers.com

AI搜集汇总

数据集介绍

构建方式

The HellaSwag Dataset的构建基于大规模的自然语言处理任务,旨在评估和提升模型在常识推理方面的能力。该数据集通过精心设计的问答对,涵盖了日常生活中的多种场景,确保了数据的多样性和复杂性。构建过程中,研究人员采用了众包平台,邀请大量参与者进行问答对的生成和验证,确保了数据的高质量和真实性。

使用方法

The HellaSwag Dataset主要用于自然语言处理领域的模型训练和评估。研究人员可以通过该数据集测试和提升模型在常识推理任务中的表现。使用时,可以将数据集划分为训练集和测试集,分别用于模型的训练和性能评估。此外,数据集的多样性和复杂性也使其适用于多种研究场景,如多模态学习、跨领域推理等。

背景与挑战

背景概述

HellaSwag数据集由密歇根大学和华盛顿大学的研究人员于2019年创建,旨在评估自然语言处理模型在常识推理任务中的表现。该数据集的核心研究问题是如何提高机器在理解复杂语境和常识推理方面的能力,这对于构建更加智能和人性化的对话系统至关重要。HellaSwag数据集的发布对自然语言处理领域产生了深远影响,推动了模型在处理复杂语言任务上的进步,并为后续研究提供了宝贵的资源。

当前挑战

HellaSwag数据集在构建过程中面临了多项挑战。首先,常识推理任务的复杂性要求数据集必须包含多样化和高度相关的情境,以确保模型能够学习到广泛的知识。其次,数据集的构建需要大量的人工标注,这不仅耗时且成本高昂。此外,如何确保标注的一致性和准确性也是一个重大挑战。最后,数据集的规模和多样性要求模型具备强大的泛化能力,以应对未见过的情境和问题。

发展历史

创建时间与更新

The HellaSwag Dataset由Zellers等人在2019年创建,旨在评估自然语言理解系统在常识推理任务中的表现。该数据集自创建以来未有官方更新记录。

重要里程碑

The HellaSwag Dataset的发布标志着自然语言处理领域在常识推理任务上的重要进展。该数据集通过引入复杂且多样的常识问题,显著提升了模型在真实世界场景中的推理能力评估标准。其独特的数据结构和高质量的标注使其成为研究者和开发者广泛使用的基准数据集,推动了相关算法的创新和发展。

当前发展情况

目前,The HellaSwag Dataset已成为自然语言处理领域中常识推理任务的重要基准之一。其广泛应用于各类模型的训练和评估,促进了模型在复杂语境下的表现提升。随着技术的进步,该数据集的应用范围不断扩大,不仅限于学术研究,还逐渐渗透到工业界,为智能助手、聊天机器人等应用提供了强大的技术支持。

发展历程

- The HellaSwag Dataset首次发表,由Rowan Zellers等人提出,旨在评估自然语言理解模型在常识推理任务中的表现。

- 该数据集被广泛应用于多个自然语言处理研究项目中,成为评估模型在复杂语境下推理能力的重要基准。

常用场景

经典使用场景

在自然语言处理领域,The HellaSwag Dataset 常用于评估和提升模型在常识推理任务中的表现。该数据集通过设计一系列包含日常情境的句子,要求模型判断其合理性或完成缺失部分,从而测试模型对人类常识的理解和应用能力。

解决学术问题

The HellaSwag Dataset 解决了当前自然语言处理模型在常识推理方面的不足。通过提供丰富的日常情境数据,该数据集帮助研究者开发和验证能够更好地理解和应用常识的模型,从而推动了人工智能在复杂语境下的推理能力。

实际应用

在实际应用中,The HellaSwag Dataset 为开发更智能的对话系统和推荐引擎提供了基础。通过提升模型对常识的理解,这些系统能够更准确地预测用户需求,提供更自然和贴切的交互体验,从而在客户服务、教育辅助和个性化推荐等领域展现出显著的应用价值。

数据集最近研究

最新研究方向

在自然语言处理领域,The HellaSwag Dataset因其对常识推理能力的挑战而备受关注。最新研究方向主要集中在提升模型对复杂情境的理解和推理能力,特别是在多模态数据融合方面。研究者们通过引入视觉信息和文本数据的联合训练,旨在增强模型在真实世界场景中的应用性能。此外,该数据集还被用于评估和改进模型的公平性和鲁棒性,确保其在不同文化和语言背景下的表现一致。这些前沿研究不仅推动了人工智能技术的进步,也为跨学科合作提供了新的契机。

相关研究论文

- 1HellaSwag: Can a Machine Really Finish Your Sentence?University of Washington · 2019年

- 2Beyond Accuracy: Behavioral Testing of NLP Models with CheckListMicrosoft Research · 2020年

- 3Language Models are Few-Shot LearnersOpenAI · 2020年

- 4Unsupervised Data Augmentation for Consistency TrainingGoogle Research · 2020年

- 5On the Opportunities and Risks of Foundation ModelsStanford University · 2021年

以上内容由AI搜集并总结生成