UniMed|医学成像数据集|多模态数据数据集

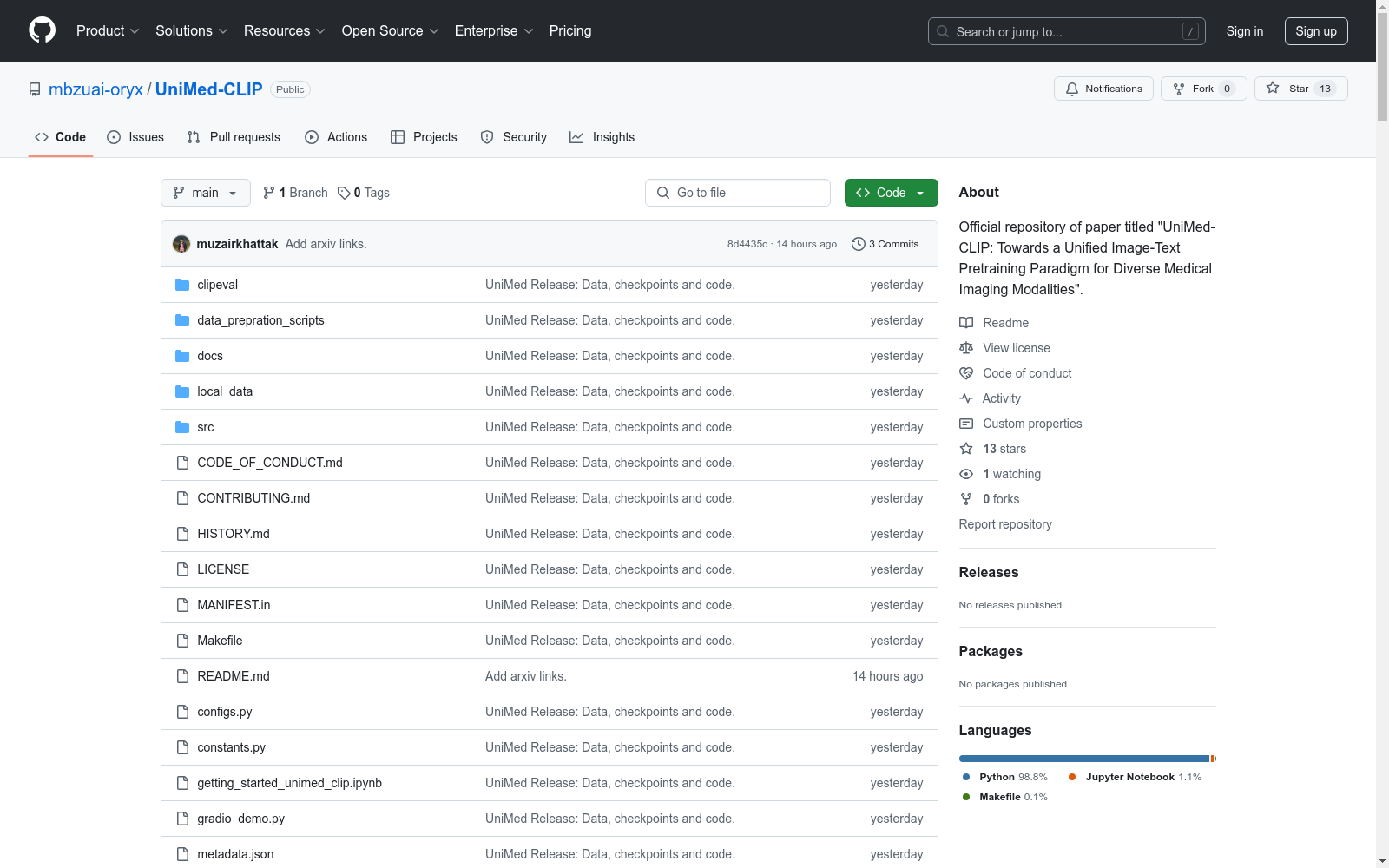

收藏UniMed-CLIP: Towards a Unified Image-Text Pretraining Paradigm for Diverse Medical Imaging Modalities

数据集概述

数据集名称

UniMed-CLIP

数据集描述

UniMed-CLIP 是一个用于多种医学影像模态的统一图像-文本预训练范式的数据集。该数据集包含超过 5.3 百万的图像-文本对,涵盖六种不同的医学影像模态:X-ray、CT、MRI、Ultrasound、Pathology 和 Fundus。

数据集特点

- 多模态数据集:UniMed 数据集包含六种不同的医学影像模态,提供了丰富的多模态数据。

- 大规模数据:数据集包含超过 5.3 百万的图像-文本对,为训练通用医学视觉-语言模型提供了坚实的基础。

- 开放源代码:提供了详细的代码和注释文件,用于准备 UniMed 数据集,促进医学视觉-语言模型的开源研究。

数据集应用

UniMed-CLIP 数据集主要用于训练和评估医学视觉-语言模型(VLMs),特别是在零样本评估中表现出色。

数据集贡献

- UniMed 数据集:一个开放源代码的大规模多模态医学数据集,包含超过 5.3 百万的样本,覆盖六种不同的医学模态。

- UniMed-CLIP VLMs:基于 UniMed 数据集训练的对比学习视觉-语言模型,显著优于现有的通用 VLMs,并在多种医学模态上表现出色。

- 广泛的评估和分析:提供了对不同设计选择的消融实验,并开源了训练代码、数据集和模型检查点,以促进医学 VLMs 的进一步研究。

数据集性能

| 方法 | 论文链接 | X-ray | Retinal-Fundus | CT | MRI | US | Histopathology | 平均分 |

|---|---|---|---|---|---|---|---|---|

| BioMedCLIP | Link | 55.43 | 22.87 | 43.99 | 64.59 | 49.20 | 54.50 | 49.02 |

| PMC-CLIP | Link | 52.64 | 25.84 | 66.06 | 63.68 | 62.51 | 53.56 | 53.37 |

| UniMed-CLIP | Link | 68.78 | 31.23 | 85.54 | 68.83 | 68.64 | 59.96 | 61.63 |

数据集更新

- 2024年12月13日:发布了用于准备 UniMed 预训练数据集的注释和代码脚本,以及 UniMed-CLIP 的训练和推理代码,以及预训练的检查点。

数据集准备

提供了详细的说明和注释文件,用于准备 UniMed 数据集,具体内容请参考 UniMed-DATA.md。

预训练模型

提供了三个 UniMed-CLIP 模型的权重,具体信息如下:

model_name |

text encoder |

pretrained_weights |

分辨率 | GPUs | 21个数据集的平均分 |

|---|---|---|---|---|---|

| ViT-B-16-quickgelu | BiomedNLP-BiomedBERT-base-uncased-abstract | unimed_clip_vit_b16 |

224 | 16 x A100 (40G) | 61.63 |

| ViT-L-14-quickgelu | BiomedNLP-BiomedBERT-large-uncased-abstract | unimed_clip_vit_l14_large_text_encoder |

336 | 16 x A100 (40G) | 62.09 |

| ViT-L-14-quickgelu | BiomedNLP-BiomedBERT-base-uncased-abstract | unimed_clip_vit_l14_base_text_encoder |

336 | 16 x A100 (40G) | 64.84 |

数据集引用

如果使用该数据集,请引用以下论文: bibtex @inproceedings{khattakunimed, title={UniMed-CLIP: Towards a Unified Image-Text Pretraining Paradigm for Diverse Medical Imaging Modalities}, author={khattak, Muhammad Uzair and Kunhimon, Shahina and Muzzamal, Naseer and Khan, Salman and Khan, Fahad Shahbaz}, journal={arXiv:2412.10372}, year={2024} }

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio 收录

AgiBot World

为了进一步推动通用具身智能领域研究进展,让高质量机器人数据触手可及,作为上海模塑申城语料普惠计划中的一份子,智元机器人携手上海人工智能实验室、国家地方共建人形机器人创新中心以及上海库帕思,重磅发布全球首个基于全域真实场景、全能硬件平台、全程质量把控的百万真机数据集开源项目 AgiBot World。这一里程碑式的开源项目,旨在构建国际领先的开源技术底座,标志着具身智能领域 「ImageNet 时刻」已到来。AgiBot World 是全球首个基于全域真实场景、全能硬件平台、全程质量把控的大规模机器人数据集。相比于 Google 开源的 Open X-Embodiment 数据集,AgiBot World 的长程数据规模高出 10 倍,场景范围覆盖面扩大 100 倍,数据质量从实验室级上升到工业级标准。AgiBot World 数据集收录了八十余种日常生活中的多样化技能,从抓取、放置、推、拉等基础操作,到搅拌、折叠、熨烫等精细长程、双臂协同复杂交互,几乎涵盖了日常生活所需的绝大多数动作需求。

github 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录

中国行政区划数据

本项目为中国行政区划数据,包括省级、地级、县级、乡级和村级五级行政区划数据。数据来源于国家统计局,存储格式为sqlite3 db文件,支持直接使用数据库连接工具打开。

github 收录