Enigmata-Data|逻辑推理数据集|谜题生成数据集

收藏Enigmata数据集概述

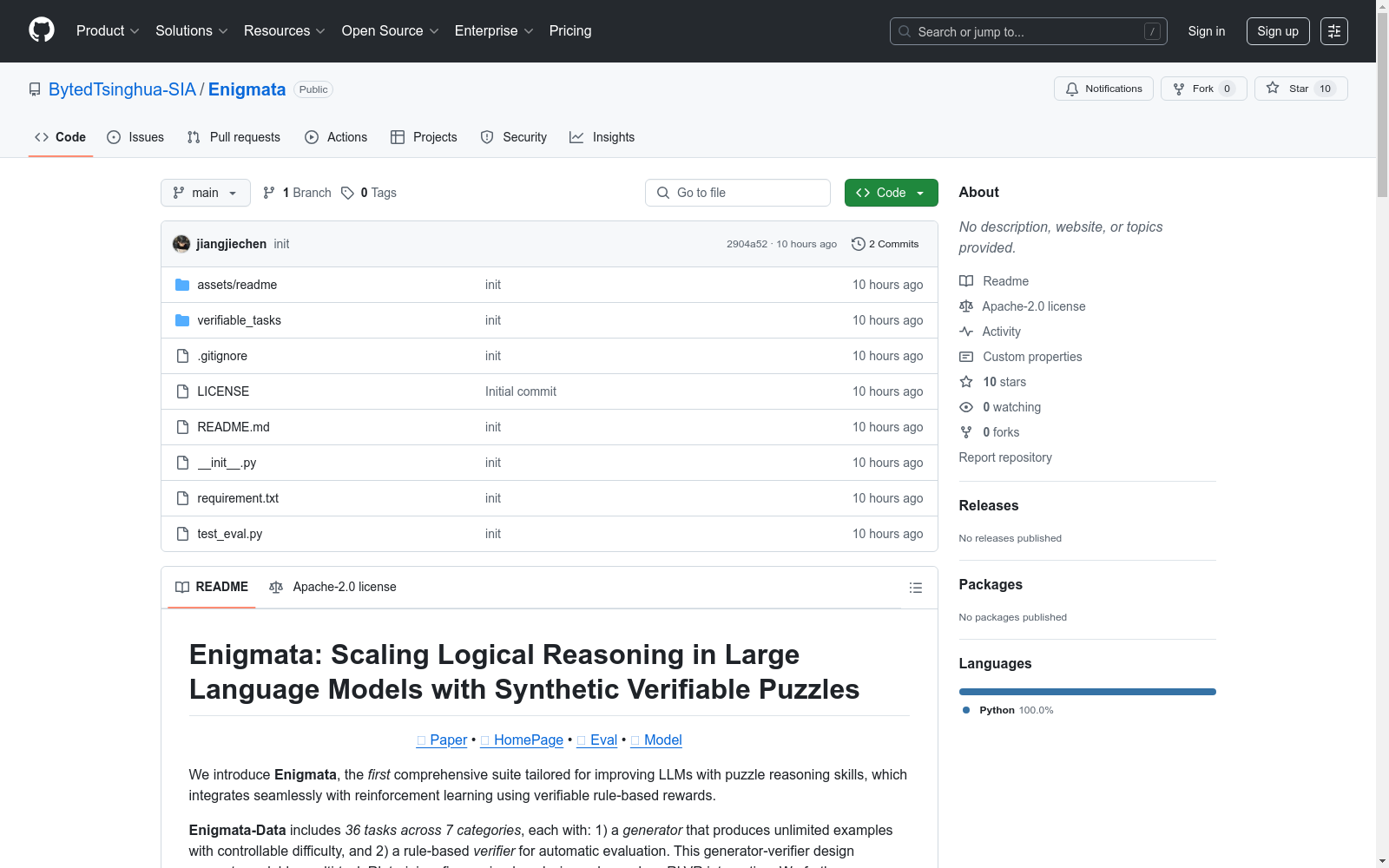

数据集简介

- 名称:Enigmata

- 类型:逻辑推理谜题数据集

- 目标:提升大语言模型的逻辑推理能力

- 特点:

- 首个专注于谜题推理能力的综合套件

- 支持基于规则的可验证奖励的强化学习

数据集组成

Enigmata-Data

- 任务数量:36个

- 任务类别:7类

- 核心组件:

- 生成器:可生成无限量实例,支持难度控制

- 验证器:提供基于规则的自动验证

- 优势:

- 无限自验证数据

- 可控难度

- 灵活的任务采样

Enigmata-Eval

- 基准测试规模:4,758个谜题实例

- 难度级别:Easy、Medium、Hard

- 数据划分:严格的训练-评估分离

模型训练与应用

训练方法

- 两阶段训练:

- 拒绝微调(RFT)

- 多任务强化学习(带可验证奖励)

- 代表性模型:Qwen2.5-32B-Enigmata

性能表现

- 优势领域:密码学、算术、逻辑任务

- 挑战领域:空间和顺序任务

- 泛化能力:在AIME、GPQA Diamond等高级推理任务中表现优异

数据与模型资源

- Enigmata-Eval下载:HuggingFace Dataset

- 模型资源:Qwen2.5-32B-Enigmata

引用

bibtex @article{2025enigmata, title={Enigmata: Scaling Logical Reasoning in Large Language Models with Synthetic Verifiable Puzzles}, author={Jiangjie Chen, Qianyu He, Siyu Yuan, Aili Chen, Zhicheng Cai, Weinan Dai, Hongli Yu, Qiying Yu, Xuefeng Li, Jiaze Chen, Hao Zhou, Mingxuan Wang}, journal={arXiv preprint arXiv:2505.19914}, year={2025} }

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录

UIEB, U45, LSUI

本仓库提供了水下图像增强方法和数据集的实现,包括UIEB、U45和LSUI等数据集,用于支持水下图像增强的研究和开发。

github 收录

ACPBench Hard

ACPBench Hard数据集是基于ACPBench构建的,由IBM Research创建。该数据集包含7种不同类型的推理任务,旨在将复杂的计划生成任务分解为独立的原子推理任务,以布尔问题或选择题的形式出现。ACPBench Hard是这些任务的生成版本,要求模型回答开放性问题。数据集适用于评估大型语言模型在自动规划器中作为组件的可靠性,涵盖多种规划领域,以帮助构建更高效的规划模型。

arXiv 收录

新疆-中亚矿产资源分布及其潜力评估(2018.1-2021.12)

1) 数据内容:本数据库包含空间范围:①我国青藏高原、新疆;②中亚(哈萨克斯坦、吉尔吉斯斯坦、塔吉克斯坦、乌兹别克斯坦);③西亚(巴基斯坦、阿富汗、伊朗);④东南亚(泰国、越南、老挝、缅甸、柬埔寨)。数据内容主要有:①1:500万地质数据集(地质体和构造);②1:100万各国地质矿产数据集(地质体、构造、矿产);②金属矿产数据集(矿床、矿点、矿化点);③新疆-中亚成矿地质背景数据集(岩石建造组合、构造分区、成矿区带、远景区、靶区、矿产);主要图件包括:泛第三极地质矿产图(1:500万)、中亚四国地质矿产图(1:150万)、巴基斯坦地质矿产图(1:100万)、阿富汗地质矿产图(1:100万)、伊朗地质矿产图(1:100万)、中国新疆-中亚廊带地质矿产图(1:250万)、中国新疆-中亚廊带成矿规律图(1:250万)、我国青藏高原地质矿产图(1:150万)。空间数据库采用ArcGIS平台,可为区域成矿规律研究、资源潜力评估、战略远景区圈定以及各类专题图件编制提供基础数据支撑。数据库格式为文件数据库(.GDB),图件包括工程文件(MXD)和栅格图(JPG),也可根据需要生成各类常见图形格式(PDF、TIF、EPS等)。泛第三极全区(1:500万)采用兰伯特等形圆锥投影,中央经线为东经84度,双纬分别为20度和55度。中国新疆-中亚廊带地质矿产数据采用兰伯特等形圆锥投影,中央经线为东经75度,双纬分别为30度和50度。中亚和西亚主要国别1:100万地质矿产数据采用采用兰伯特等形圆锥投影,中央经线和双纬根据各国所在位置具体确定。 2) 数据来源及加工方法;基础地质数据主要来源于任继舜院士编亚洲地质图(2015)(1:500万)、中欧亚构造成矿图和地质图(2008)(1:250万)、域内各国地质调查部门地质图(1:100万);②矿产数据主要来源包括全国矿产资源潜力评价项目成果(2012)、英国伦敦自然历史博物馆中亚矿产数据库及专题图(2014)、美国地质调查局阿富汗数据集(2008)、域内各国地质调查部门相关资料数据、域内矿产相关论文论著。此外,为满足各类数据修改及完善大量采用遥感数据,具体包括:ETM+、OLI、ASTER、Worldview等影像数据以及90m、30米、12.5mDEM数据等。 3) 数据质量描述;为满足泛第三极区域成矿规律研究、地质矿产图和成矿预测图编制需要,在数据空间准确性、逻辑一致性和数据完整性方面进行编辑、处理以及补充完善。具体包括:①矢量化,基于前述资料进行了大量矢量化工作,用于补充数字资料缺失区域(伊朗、巴基斯坦),同时根据资料更新程度合并、分割各类面要素和线要素,矢量化工作按照我国相关规范要求比例尺精度要求下完成;②拓扑处理,消除重叠面、空区等拓扑错误;③完善要素属性结构和补充要素属性内容,围绕区域成矿规律研究、地质矿产图和成矿预测图编制目标,依据我国相关规范,结合具体资料和数据内容,建立了相应数据模型,完善了地质体、构造、矿产要素类属性结构并完成了相应属性的填写工作;④基于以上数据处理内容,结合泛第三极研究成果和最新认识,对区内相关地质内容进行了进一步修改和完善。 4) 数据应用成果及前景:泛第三极地质矿产数据库主要服务于泛第三极全区、重要成矿带以及国别区域成矿规律研究、地质矿产图和成矿预测图编制,比例尺为1:500万(泛第三极全区)、1:250万(中国新疆-中亚廊带)、1:100万(重要成矿带、中西亚各国别)。

国家青藏高原科学数据中心 收录

N-Caltech 101 (Neuromorphic-Caltech101)

The Neuromorphic-Caltech101 (N-Caltech101) dataset is a spiking version of the original frame-based Caltech101 dataset. The original dataset contained both a "Faces" and "Faces Easy" class, with each consisting of different versions of the same images. The "Faces" class has been removed from N-Caltech101 to avoid confusion, leaving 100 object classes plus a background class. The N-Caltech101 dataset was captured by mounting the ATIS sensor on a motorized pan-tilt unit and having the sensor move while it views Caltech101 examples on an LCD monitor as shown in the video below. A full description of the dataset and how it was created can be found in the paper below. Please cite this paper if you make use of the dataset.

Papers with Code 收录