TxT360|预训练语言模型数据集|预训练数据集

收藏TxT360: 高质量LLM预训练数据集

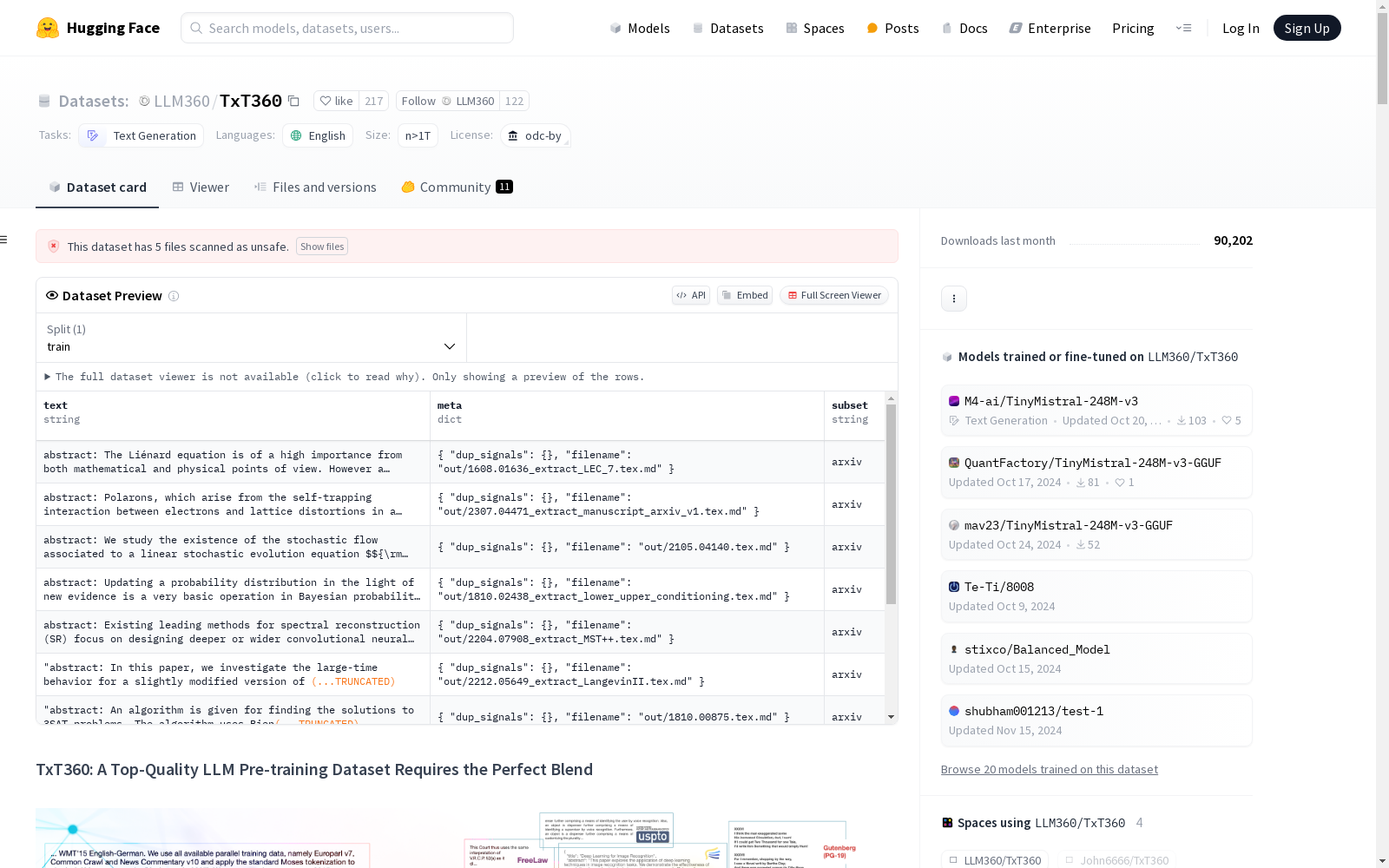

数据集概述

TxT360(Trillion eXtracted Text)是首个全球去重99个CommonCrawl快照和14个常用非网页数据源(如FreeLaw、PG-19等)的数据集。该数据集为预训练团队提供了一种轻松调整数据权重、获取最大高质量开源数据集并训练最优模型的方法。

数据源比较

| 数据源 | TxT360 | FineWeb | RefinedWeb | PedPajamaV2 | C4 | Dolma | RedPajamaV1 | The Pile |

|---|---|---|---|---|---|---|---|---|

| CommonCrawl快照 | 99 | 96 | 90 | 84 | 1 | 24 | 5 | 0.6% of 74 |

| 论文** | 5个来源 | - | - | - | - | 1个来源 | 1个来源 | 4个来源 |

| Wikipedia | 310+种语言 | - | - | - | - | 包含 | 包含 | 仅英文 |

| FreeLaw | 包含 | - | - | - | - | - | - | 包含 |

| DM Math | 包含 | - | - | - | - | - | - | 包含 |

| USPTO | 包含 | - | - | - | - | - | - | 包含 |

| PG-19 | 包含 | - | - | - | - | 包含 | 包含 | 包含 |

| HackerNews | 包含 | - | - | - | - | - | - | 包含 |

| Ubuntu IRC | 包含 | - | - | - | - | - | - | 包含 |

| EuroParl | 包含 | - | - | - | - | - | - | 包含 |

| StackExchange** | 包含 | - | - | - | - | - | - | 包含 |

| 代码 | * | - | - | - | - | 包含 | 包含 | 包含 |

-

TxT360不包含代码。此决定是由于代码与其他来源的重复率较低。

-

StackExchange和PubMed Central数据集将很快上传。所有其他数据集均已完整。

数据集性能

为了评估数据集的训练效率,我们从FineWeb和TxT360中各抽取了1.5T个token,并在一个8x8B的Mixture-of-Experts架构上进行了训练消融实验。通过跟踪训练损失、验证分数和在多种评估基准上的表现来比较学习曲线。验证集独立于SlimPajama采样。

初始数据表示

为了生成TxT360,设计了一个全面的数据处理管道,以处理网页和精选数据集的细微差别。该管道提供了一个统一的框架,方便用户根据自身需求调整和微调管道。

数据过滤与去重

- CommonCrawl数据过滤:详细讨论了如何过滤99个Common Crawl快照,并与之前的过滤技术(如Dolma、DataTrove、RedPajamaV2)进行比较。

- 精选数据源过滤:每个数据源都根据底层数据进行了单独过滤。详细讨论了每个数据源的过滤过程。

- 全局去重:在过滤网页和精选数据源后,所有数据源进行了全局去重,以创建TxT360。包含了去重过程中的技巧和窍门。

数据集详细信息

| 数据源 | 原始数据大小 | 标记数量 | 信息截止日期 |

|---|---|---|---|

| CommonCrawl | 9.2 TB | 4.83T | 2024-30 |

| 论文 | 712 GB | 154.96B | Q4 2023 |

| Wikipedia | 199 GB | 35.975B | - |

| Freelaw | 71 GB | 16.7B | Q1 2024 |

| DM Math | 22 GB | 5.23B | - |

| USPTO | 45 GB | 4.95B | Q3 2024 |

| PG-19 | 11 GB | 2.63B | - |

| HackerNews | 4.1 GB | 1.08B | Q4 2023 |

| Ubuntu IRC | 4.7 GB | 1.54B | Q3 2024 |

| Europarl | 6.1 GB | 1.96B | - |

| StackExchange | 79 GB | 27.0B | Q4 2023 |

引用

bibtex @misc{txt360data2024, title={TxT360: A Top-Quality LLM Pre-training Dataset Requires the Perfect Blend}, author={Liping Tang, Nikhil Ranjan, Omkar Pangarkar, Xuezhi Liang, Zhen Wang, Li An, Bhaskar Rao, Zhoujun Cheng, Suqi Sun, Cun Mu, Victor Miller, Yue Peng, Eric P. Xing, Zhengzhong Liu}, year={2024} }