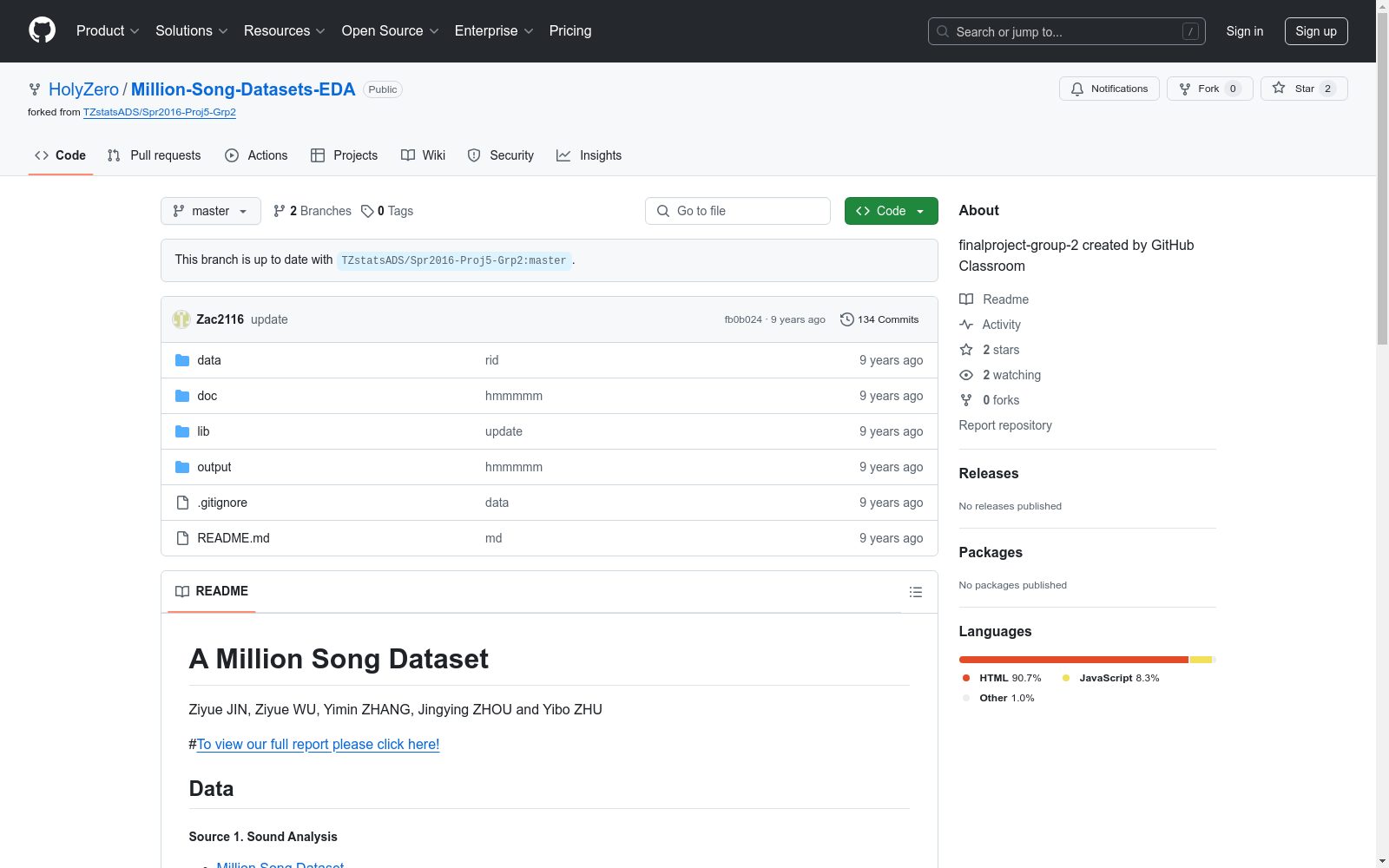

Million Song Dataset|音乐分析数据集|音频数据数据集

收藏数据集概述

数据来源

-

Sound Analysis

- 来源:Million Song Dataset

- 格式:.h5

- 使用情况:

- 对所有1,000,000首歌曲的元数据进行探索性数据分析(元数据大小:300 MB)

- 从随机子集中提取10,000首歌曲的声音分析数据(声音分析数据大小:1.8 GB)

- 时间结构分析:如节拍/小节长度分布

- 响度、音色和音高分析

-

User Preference

- 来源:Echo Nest Taste Profile Data

- 格式:每首歌曲的用户播放次数

- 使用情况:利用播放次数数据生成“用户定义”的歌曲相似度度量,并尝试使用随机森林和LASSO选择对决定此度量最重要的声音特征(来自数据集1)

-

Lyrics Bag-of-Words

- 来源:musiXmatch dataset

- 格式:.db(BoW)

- 使用情况:实施基于10和15个主题的Latent Dirichlet Allocation主题模型,独立于其他集群生成,以观察声音特征生成的集群是否在“文学上”有所不同

-

Genre

- 来源:Tagtraum Genre Annotations

- 格式:.cls

- 使用情况:未详细说明

方法论

- 基于歌曲特征对歌曲进行集群

- 使用歌词Bag-of-Words数据进行主题建模,并比较这两种集群结果的差异/相似性

- 利用播放次数数据选择对“群体定义的相似性”决定性重要的歌曲特征,然后仅使用这些选定的声音特征对歌曲进行再次集群

结论

基于上述结果得出结论。

中国劳动力动态调查

“中国劳动力动态调查” (China Labor-force Dynamics Survey,简称 CLDS)是“985”三期“中山大学社会科学特色数据库建设”专项内容,CLDS的目的是通过对中国城乡以村/居为追踪范围的家庭、劳动力个体开展每两年一次的动态追踪调查,系统地监测村/居社区的社会结构和家庭、劳动力个体的变化与相互影响,建立劳动力、家庭和社区三个层次上的追踪数据库,从而为进行实证导向的高质量的理论研究和政策研究提供基础数据。

中国学术调查数据资料库 收录

LEVIR-CD

LEVIR-CD 是一个新的大规模遥感建筑变化检测数据集。引入的数据集将成为评估变化检测 (CD) 算法的新基准,尤其是基于深度学习的算法。 LEVIR-CD 由 637 个非常高分辨率(VHR,0.5m/像素)Google Earth (GE) 图像块对组成,大小为 1024 × 1024 像素。这些时间跨度为 5 到 14 年的双时相图像具有显着的土地利用变化,尤其是建筑增长。 LEVIR-CD涵盖别墅住宅、高层公寓、小型车库和大型仓库等各类建筑。在这里,我们关注与建筑相关的变化,包括建筑增长(从土壤/草地/硬化地面或在建建筑到新建筑区域的变化)和建筑衰退。这些双时相图像由遥感图像解释专家使用二进制标签(1 表示变化,0 表示不变)进行注释。我们数据集中的每个样本都由一个注释器进行注释,然后由另一个注释器进行双重检查以产生高质量的注释。完整注释的 LEVIR-CD 总共包含 31,333 个单独的变更构建实例。

OpenDataLab 收录

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录

糖尿病预测数据集

糖尿病相关的医学研究或者健康数据

AI_Studio 收录

猫狗分类

## 数据集描述 ### 数据集简介 本数据集是简单的猫狗二分类数据集,共2个类别,其中训练集包含275张带注释的图像,验证集包含70张带注释的图像。整个数据集共10.3MB,可用于快速模型验证、性能评估、小数据集训练等。 ### 数据集支持的任务 可用于快速模型验证、性能评估、小数据集训练等。 ## 数据集的格式和结构 ### 数据格式 数据集包括训练集train和验证集val,train和val文件夹之下按文件夹进行分类,共有2个子文件夹,同类别标签的图片在同一个文件夹下,图片格式为JPG。同时包含与标注文件中label id相对应的类名文件classname.txt。 ### 数据集加载方式 ```python from modelscope.msdatasets import MsDataset from modelscope.utils.constant import DownloadMode ms_train_dataset = MsDataset.load( 'cats_and_dogs', namespace='tany0699', subset_name='default', split='train') # 加载训练集 print(next(iter(ms_train_dataset))) ms_val_dataset = MsDataset.load( 'cats_and_dogs', namespace='tany0699', subset_name='default', split='validation') # 加载验证集 print(next(iter(ms_val_dataset))) ``` ### 数据分片 本数据集包含train和val数据集。 | 子数据集 | train | val | test | |---------|-------------:|-----------:|---------:| | default | 训练集 | 验证集 | / | ### Clone with HTTP ```bash git clone https://www.modelscope.cn/datasets/tany0699/cats_and_dogs.git ```

魔搭社区 收录