有没有相关的论文或文献参考?

这个数据集是基于什么背景创建的?

数据集的作者是谁?

能帮我联系到这个数据集的作者吗?

这个数据集如何下载?

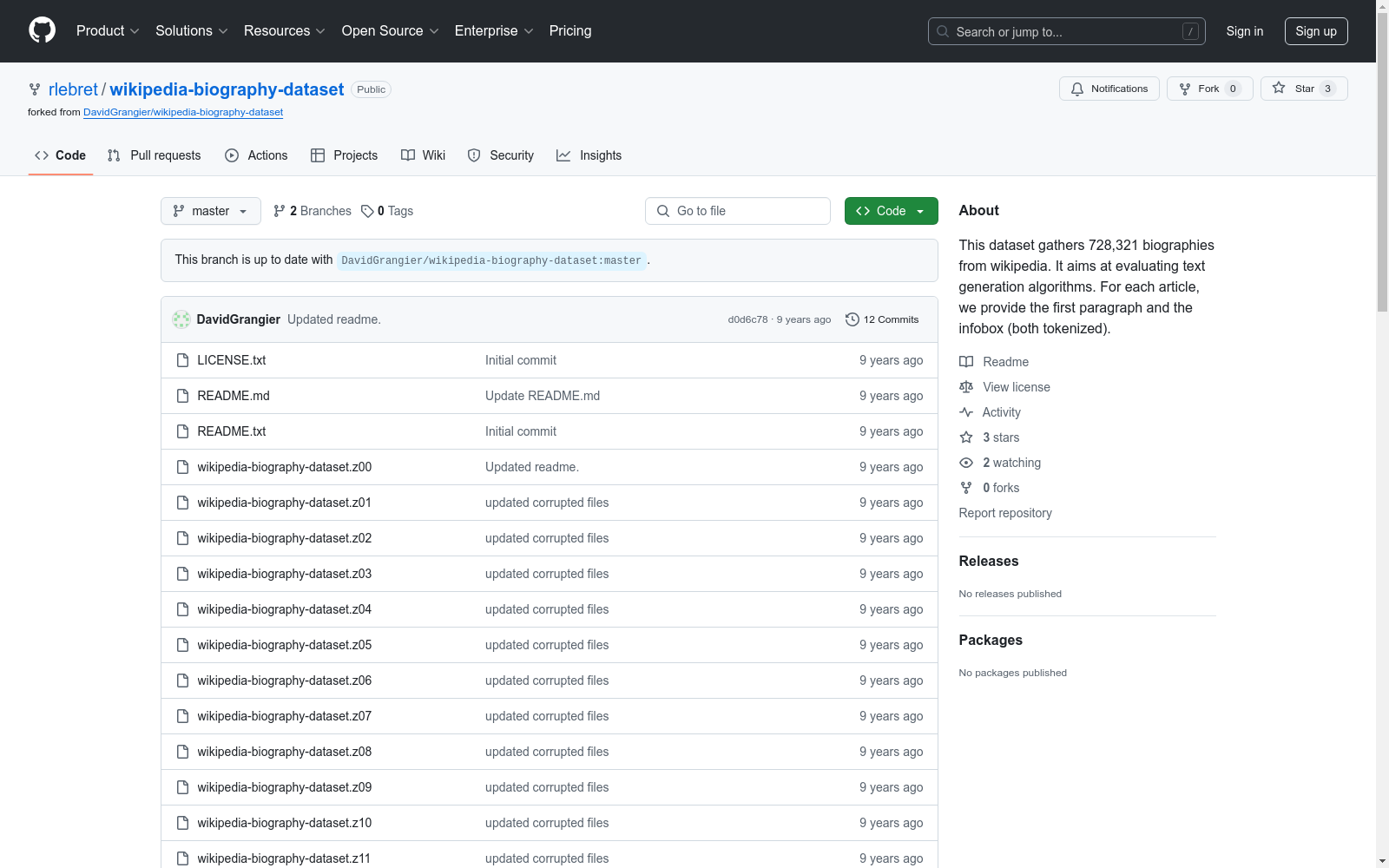

WikiBio (wikipedia biography dataset)

用于评估文本生成算法,特别是在传记领域。

数据集分为三个子目录:train, valid, test。每个子目录包含7个文件:

当使用此数据集时,建议引用以下论文:

Materials Project

材料项目是一组标有不同属性的化合物。数据集链接: MP 2018.6.1(69,239 个材料) MP 2019.4.1(133,420 个材料)

OpenDataLab 收录

Nexdata/chinese_dialect

该数据集包含25,000小时的中文方言语音数据,收集自多个方言区域的本地方言使用者,涵盖闽南语、粤语、四川话、河南话、东北话、上海话、维吾尔语和藏语等。数据格式为16kHz、16bit、未压缩的wav文件,单声道。句子准确率超过95%。数据集支持的任务包括自动语音识别(ASR)和音频说话人识别。

hugging_face 收录

中国农村教育发展报告

该数据集包含了中国农村教育发展的相关数据,涵盖了教育资源分布、教育质量、学生表现等多个方面的信息。

www.moe.gov.cn 收录

猫狗图像数据集

该数据集包含猫和狗的图像,每类各12500张。训练集和测试集分别包含10000张和2500张图像,用于模型的训练和评估。

github 收录

UAVDT

UAVDT是一个用于目标检测任务的数据集。

github 收录