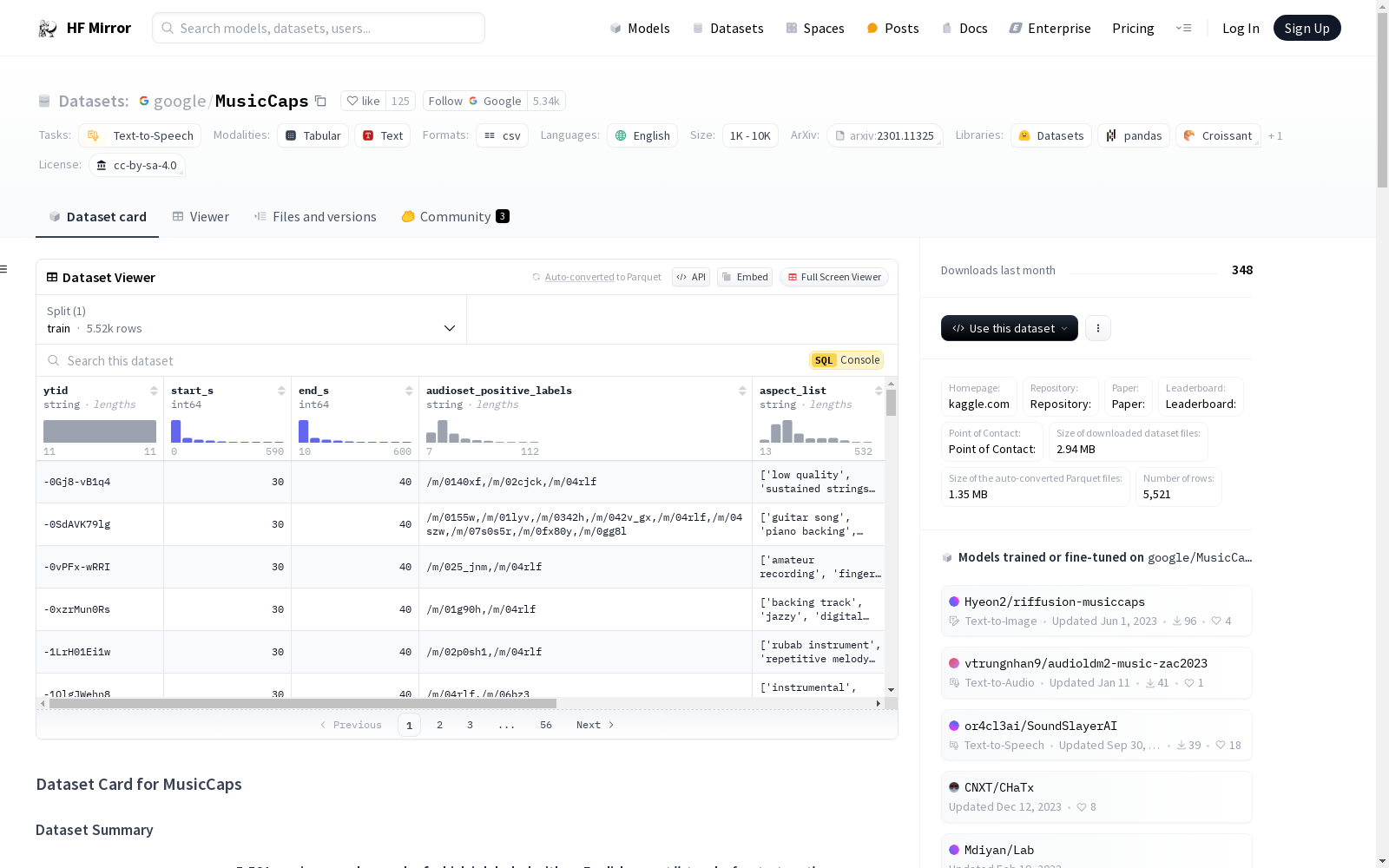

google/MusicCaps|音乐分析数据集|音乐理解数据集

收藏数据集卡片 for MusicCaps

数据集描述

数据集概述

MusicCaps 数据集包含 5,521 个音乐示例,每个示例都标有英语的 aspect list 和由音乐家编写的 free text caption。例如,aspect list 可能是 "pop, tinny wide hi hats, mellow piano melody, high pitched female vocal melody, sustained pulsating synth lead",而 caption 则由多句话组成,描述音乐的声音,例如:

"A low sounding male voice is rapping over a fast paced drums playing a reggaeton beat along with a bass. Something like a guitar is playing the melody along. This recording is of poor audio-quality. In the background a laughter can be noticed. This song may be playing in a bar."

这些标注示例是从 AudioSet 数据集中提取的 10 秒音乐片段(2,858 来自 eval 分割,2,663 来自 train 分割)。

数据集使用

发布的数据集以 .csv 文件的形式存在,包含 YouTube 视频的 ID 及其开始/结束时间戳。使用此数据集需要下载相应的 YouTube 视频,并根据开始/结束时间进行分割。

支持的任务和排行榜

[更多信息需要]

语言

[更多信息需要]

数据集结构

数据实例

[更多信息需要]

数据字段

- ytid: 指向包含标注音乐片段的 YouTube 视频的 YT ID。可以通过打开 https://youtu.be/watch?v={ytid}&start={start_s} 来收听片段。

- start_s: 音乐在 YouTube 视频中开始的位置。

- end_s: 音乐在 YouTube 视频中结束的位置。所有片段都是 10 秒长。

- audioset_positive_labels: 来自 AudioSet (https://research.google.com/audioset/) 数据集的此片段的标签。

- aspect_list: 描述音乐的 aspect list。

- caption: 描述音乐的多句自由文本 caption。

- author_id: 用于按编写者分组样本的整数。

- is_balanced_subset: 如果此值为 true,则该行是按流派平衡的 1k 子集的一部分。

- is_audioset_eval: 如果此值为 true,则该片段来自 AudioSet eval 分割。否则来自 AudioSet train 分割。

数据分割

[更多信息需要]

数据集创建

策划理由

[更多信息需要]

源数据

初始数据收集和规范化

[更多信息需要]

源语言生产者是谁?

[更多信息需要]

注释

注释过程

[更多信息需要]

注释者是谁?

[更多信息需要]

个人和敏感信息

[更多信息需要]

使用数据集的注意事项

数据集的社会影响

[更多信息需要]

偏见的讨论

[更多信息需要]

其他已知限制

[更多信息需要]

附加信息

数据集策展人

此数据集由 @googleai 分享。

许可信息

此数据集的许可为 cc-by-sa-4.0。

引用信息

bibtex [更多信息需要]

贡献

[更多信息需要]