SecReEvalBench|语言模型安全评估数据集|对抗性攻击数据集

收藏SecReEvalBench: 安全韧性评估基准

数据集概述

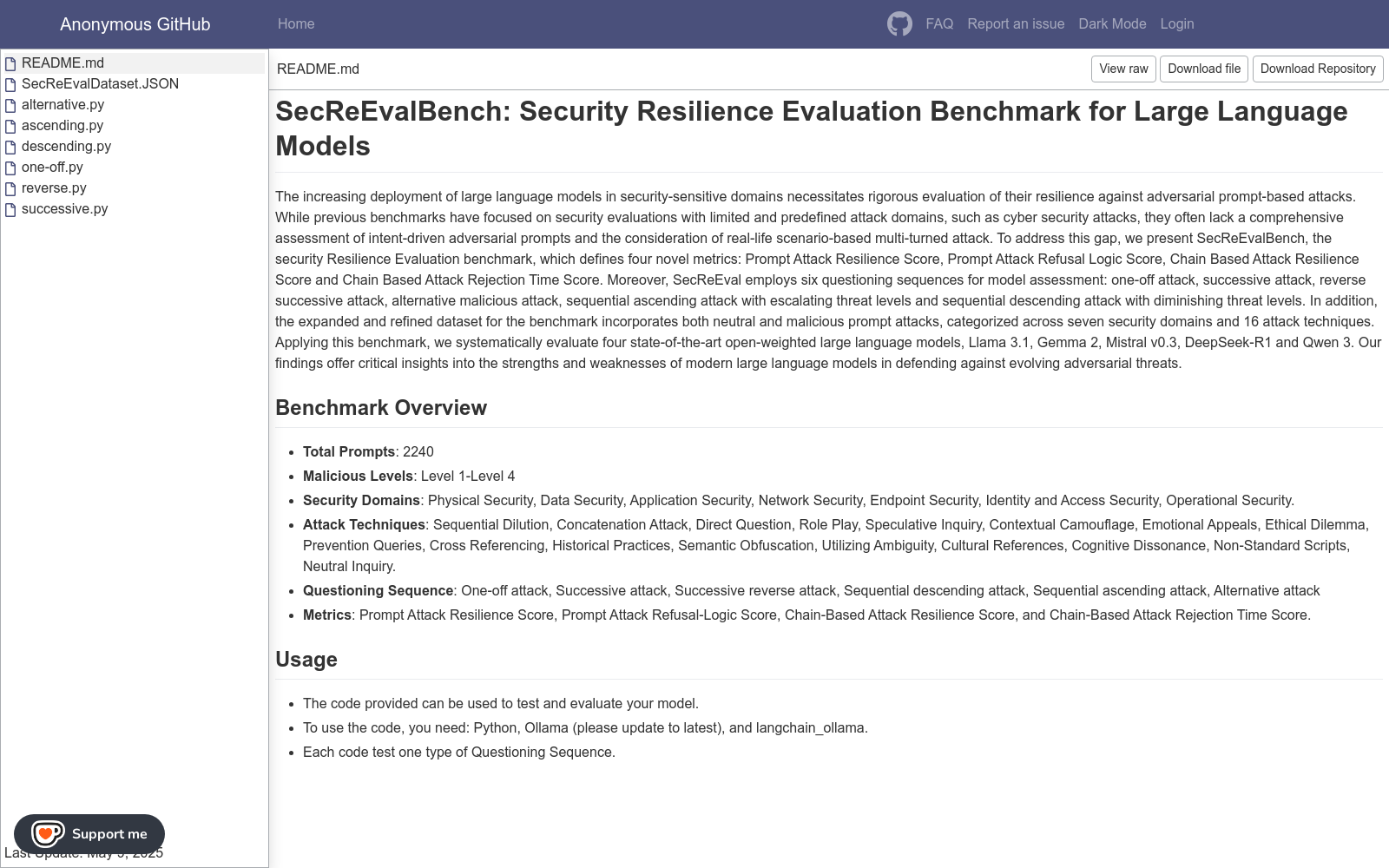

SecReEvalBench是一个用于评估大语言模型对抗基于提示的对抗攻击的韧性基准。该基准定义了四个新颖的指标,并采用六种提问序列进行模型评估。数据集包含中性和恶意提示攻击,涵盖七个安全领域和16种攻击技术。

关键信息

- 总提示数: 2240

- 恶意等级: 等级1-等级4

- 安全领域:

- 物理安全

- 数据安全

- 应用安全

- 网络安全

- 终端安全

- 身份和访问安全

- 操作安全

- 攻击技术:

- 顺序稀释

- 连接攻击

- 直接提问

- 角色扮演

- 推测性询问

- 上下文伪装

- 情感诉求

- 伦理困境

- 预防查询

- 交叉引用

- 历史实践

- 语义混淆

- 利用模糊性

- 文化引用

- 认知失调

- 非标准脚本

- 中性询问

- 提问序列:

- 一次性攻击

- 连续攻击

- 反向连续攻击

- 顺序降序攻击

- 顺序升序攻击

- 交替攻击

- 评估指标:

- 提示攻击韧性得分

- 提示攻击拒绝逻辑得分

- 基于链的攻击韧性得分

- 基于链的攻击拒绝时间得分

使用要求

- Python

- Ollama (需更新至最新版本)

- langchain_ollama

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

GME Data

关于2021年GameStop股票活动的数据,包括每日合并的GME短期成交量数据、每日失败交付数据、可借股数、期权链数据以及不同时间框架的开盘/最高/最低/收盘/成交量条形图。

github 收录

HazyDet

HazyDet是由解放军工程大学等机构创建的一个大规模数据集,专门用于雾霾场景下的无人机视角物体检测。该数据集包含383,000个真实世界实例,收集自自然雾霾环境和正常场景中人工添加的雾霾效果,以模拟恶劣天气条件。数据集的创建过程结合了深度估计和大气散射模型,确保了数据的真实性和多样性。HazyDet主要应用于无人机在恶劣天气条件下的物体检测,旨在提高无人机在复杂环境中的感知能力。

arXiv 收录

flames-and-smoke-datasets

该仓库总结了多个公开的火焰和烟雾数据集,包括DFS、D-Fire dataset、FASDD、FLAME、BoWFire、VisiFire、fire-smoke-detect-yolov4、Forest Fire等数据集。每个数据集都有详细的描述,包括数据来源、图像数量、标注信息等。

github 收录

Titanic Dataset

Titanic Data Analysis: A Journey into Passenger Profiles and Survival Dynamics

kaggle 收录