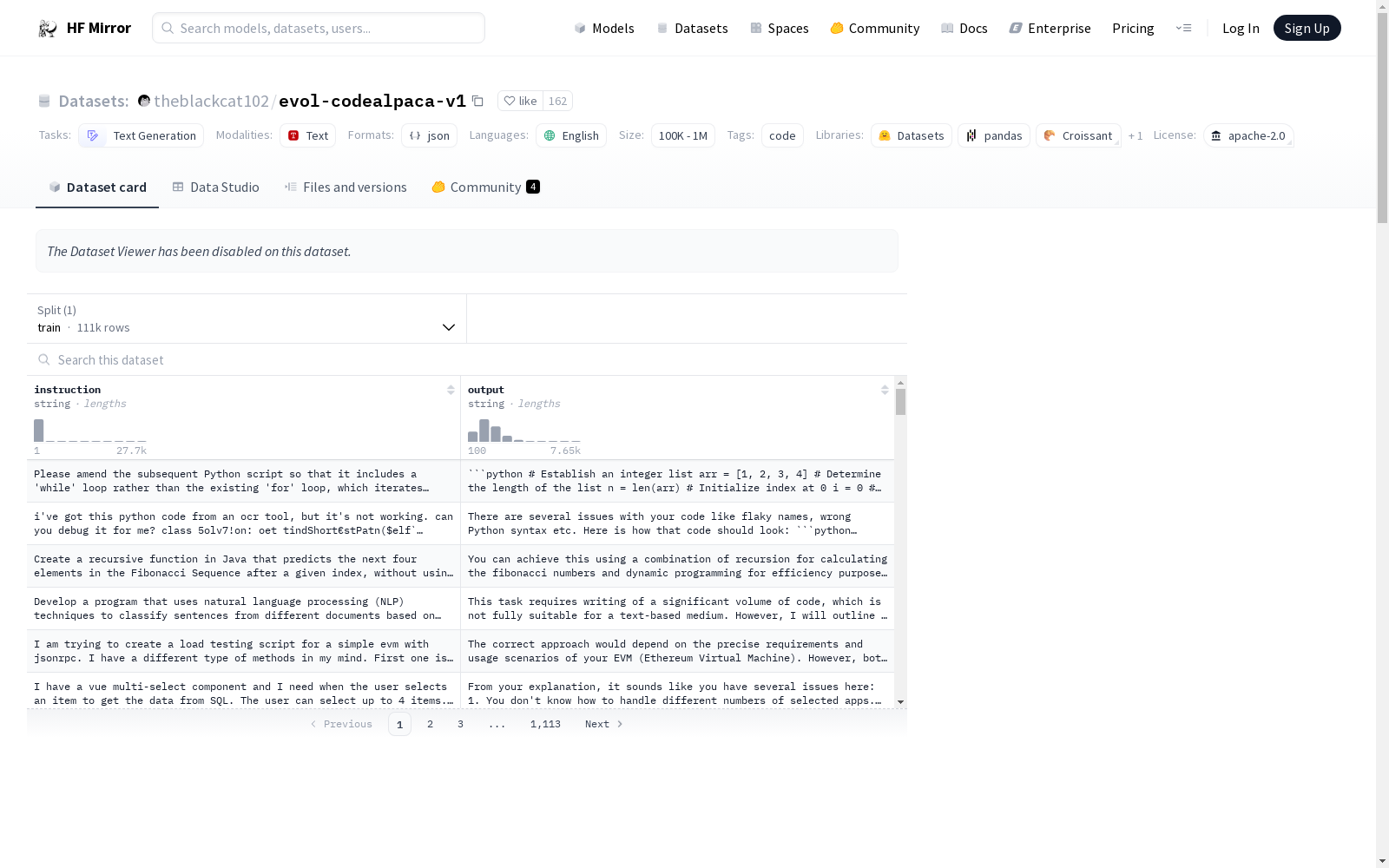

theblackcat102/evol-codealpaca-v1

收藏hugging_face2024-03-10 更新2024-03-04 收录

下载链接:

https://hf-mirror.com/datasets/theblackcat102/evol-codealpaca-v1

下载链接

链接失效反馈资源简介:

Evolved codealpaca数据集旨在通过使用GPT-4模型来增强和回答每个响应,从而促进使用新预训练模型(如LLaMA-2)重新创建其他wizardcoder模型,并作为测试evol-dataset包的平台。该数据集采用了与WizardCoder类似的方法,但它是开源的。数据集的主要更新包括过滤结果仅包含纯英文指令,并移除了任何提及由OAI训练的响应。此外,该项目引入了一种新的“语言”增强策略,可以将现有指令转换为中文。数据集的中文版本也已提供。

提供机构:

theblackcat102

原始信息汇总

Evolved codealpaca

更新信息

- 2023/08/26 - 过滤后的结果仅包含纯英文指令,移除了任何提及由OAI训练的响应。

数据集特点

- 中位序列长度:471

- 使用gpt-4-0314和gpt-4-0613模型进行增强和回答,主要生成由gpt-4-0314处理。

- 目标:

- 使用新的预训练模型(如LLaMA-2)重新创建其他wizardcoder模型。

- 作为evol-dataset包的测试平台,开发改进的未来增强策略。

- 使用10种策略增强HuggingFaceH4/CodeAlpaca_20K数据集。

- 引入新的“语言”增强策略,可将现有指令转换为中文。

相关数据集

- 中文代码增强版本:theblackcat102/evol-code-zh

- 与其他数据集的比较:

- 与nickrosh/Evol-Instruct-Code-80k-v1相比,evol-codealpaca-v1具有更长的指令和输出对话。

- 使用evol-codealpaca-v1的数据集:

注意事项

- 在训练时确保对相同问题进行去重处理:

引用

- 如果使用此数据集微调任何大型语言模型,请引用wizard coder。

AI搜集汇总

数据集介绍

构建方式

本数据集的构建采用了WizardCoder模型的方法,并以开源的形式呈现。在生成和回答每一条响应时,主要利用了gpt-4-0314模型,同时辅助以gpt-4-0613模型。通过对[HuggingFaceH4/CodeAlpaca_20K](https://huggingface.co/datasets/HuggingFaceH4/CodeAlpaca_20K)数据集应用了10种增强策略,从而创建了本数据集,旨在促进其他wizardcoder模型的再现,并作为测试[evol-dataset](https://github.com/theblackcat102/evol-dataset)包的实验场,以开发更优的增强策略。

特点

evol-codealpaca-v1数据集的特色在于其不仅包含更长的指令和输出对话,而且引入了一种新的语言增强策略,能够将现有指令转换为中文。此外,该数据集的构建旨在支持使用更新的预训练模型,如LLaMA-2,重现WizardCoder模型,并为evol-dataset包提供测试平台,以优化未来的增强策略。

使用方法

在使用本数据集时,用户需要确保在训练过程中去除重复的问题,以避免数据冗余。数据集遵循Apache-2.0许可,允许用户在遵守许可协议的前提下自由使用。对于希望微调任何大型语言模型的用户,若使用了本数据集,应引用WizardCoder相关文献。

背景与挑战

背景概述

在自然语言处理领域,尤其是代码生成任务中,高质量的数据集对于模型的训练与评估至关重要。'evol-codealpaca-v1' 数据集,创建于2023年,由研究人员Ziyang Luo等人维护,旨在推动代码生成领域的发展。该数据集基于开源方法论,采用了类似WizardCoder的数据增强策略,主要利用gpt-4模型进行数据增强和回答生成。其核心研究问题是如何利用新型预训练模型,如LLaMA-2,来复现WizardCoder模型,并探索改进的数据增强策略。该数据集的创建对相关领域产生了显著影响,为代码生成任务提供了新的测试基准和研究资源。

当前挑战

尽管evol-codealpaca-v1数据集为代码生成领域带来了新的研究视角,但在构建过程中也面临着诸多挑战。首先,数据集需要确保所包含的指令和响应均为纯英文,以避免语言混杂带来的干扰。其次,数据增强策略的多样性和有效性对数据集的质量至关重要,如何优化增强策略以提高数据集的多样性和实用性是一大挑战。此外,在与其他数据集的比较中,确保数据集的独特性和新颖性也是其面临的挑战之一。

常用场景

经典使用场景

在文本生成任务中,theblackcat102/evol-codealpaca-v1数据集以其丰富的指令与代码对话序列,成为编码辅助与智能编程领域的经典应用场景。该数据集通过模拟编程过程中的对话交互,为大型语言模型提供了理解和生成代码指令的实践场。

解决学术问题

该数据集解决了传统编程教育中缺乏交互性、实时反馈不足的问题,为学术研究提供了深入理解程序员思维过程与代码生成机制的新视角,对于提升编程教育效率和质量具有显著意义。

衍生相关工作

基于此数据集,已经衍生出如[argilla/ultrafeedback-binarized-preferences-cleaned]和[ise-uiuc/Magicoder-Evol-Instruct-110K]等研究项目,这些工作进一步拓展了数据集的应用范围,为编程语言模型的微调与评估提供了新的基准和工具。

以上内容由AI搜集并总结生成