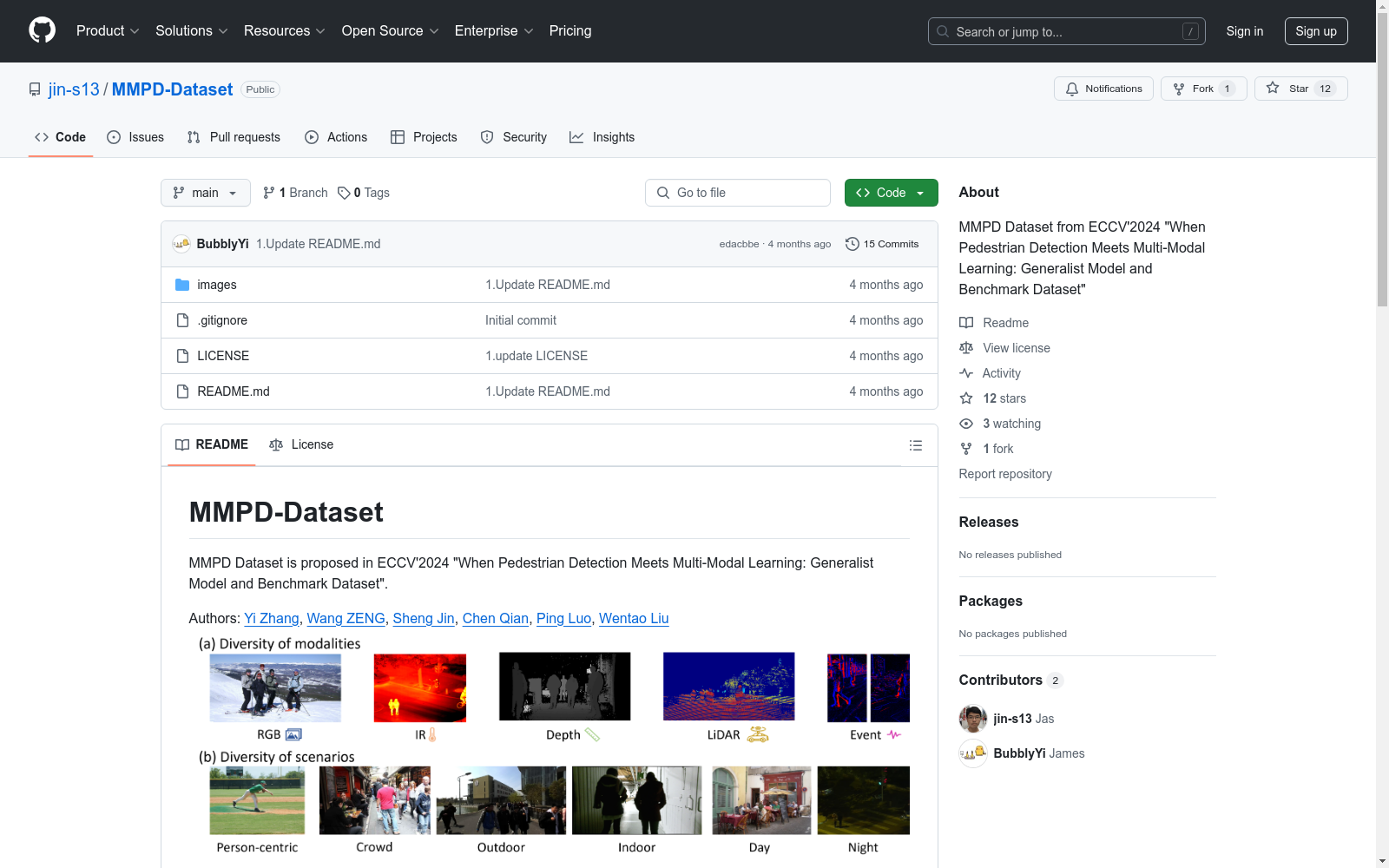

MMPD-Dataset|行人检测数据集|多模态学习数据集

收藏MMPD-Dataset

数据集概述

MMPD数据集是在ECCV2024提出的,论文标题为“When Pedestrian Detection Meets Multi-Modal Learning: Generalist Model and Benchmark Dataset”。该数据集由以下作者共同提出:

- Yi Zhang

- Wang ZENG

- Sheng Jin

- Chen Qian

- Ping Luo

- Wentao Liu

数据准备

MMPD数据集基于多个2D检测数据集构建,包括:

使用MMPD数据集前,请先从原始数据集网站下载图像,然后重新组织数据并使用提供的标注文件进行训练和测试。标注文件可通过以下链接获取:

数据集结构应如下所示: text ── mmpedestron_datasets │── mmpedestron_datasets_ann │ │-- crowdhuman_coco/annotation_train_full2coco_231020.json │ |-- LLVIP/ann_coco/LLVIP_coco_train_change_cat_id.json │ |-- PEDRo_events_dataset/coco_ann/pedro_train.json │ │-- ... │── mmpedestron_images │-- COCO │-- CrowdHuman │-- Object365 │-- LLVIP │-- InOutDoor │-- STCrowd │-- ...

数据处理

数据处理脚本可从以下仓库获取:MMPedestron

STCrowd Lidar2RGB

shell cd MMPedestron python tools/datasets_converters/stcrowd_pointcloud2cam.py

PEDRo events dataset Event2RGB

shell cd MMPedestron python tools/datasets_converters/multi_process_evs_handler.py

使用条款

- MMPD数据集仅用于研究和非商业用途。

- MMPD数据集包含多个现有公开数据集,这些数据集的版权归原始所有者所有,我们不拥有这些图像的版权。

- MMPD数据集还包含一个新提出的数据集(EventPed),该数据集可自由用于非商业用途,并可在这些条件下重新分发。EventPed数据集的图像和标注属于SenseTime Research。如需商业查询,请联系Sheng Jin (jinsheng13[at]foxmail[dot]com)。

引用

bibtex @inproceedings{zhang2024when, title={When Pedestrian Detection Meets Multi-Modal Learning: Generalist Model and Benchmark Dataset}, author={Zhang, Yi and Zeng, Wang and Jin, Sheng and Qian, Chen and Luo, Ping and Liu, Wentao}, booktitle={European Conference on Computer Vision (ECCV)}, year={2024}, month={September} }