KINS Dataset|计算机视觉数据集|实例分割数据集

收藏数据集名称

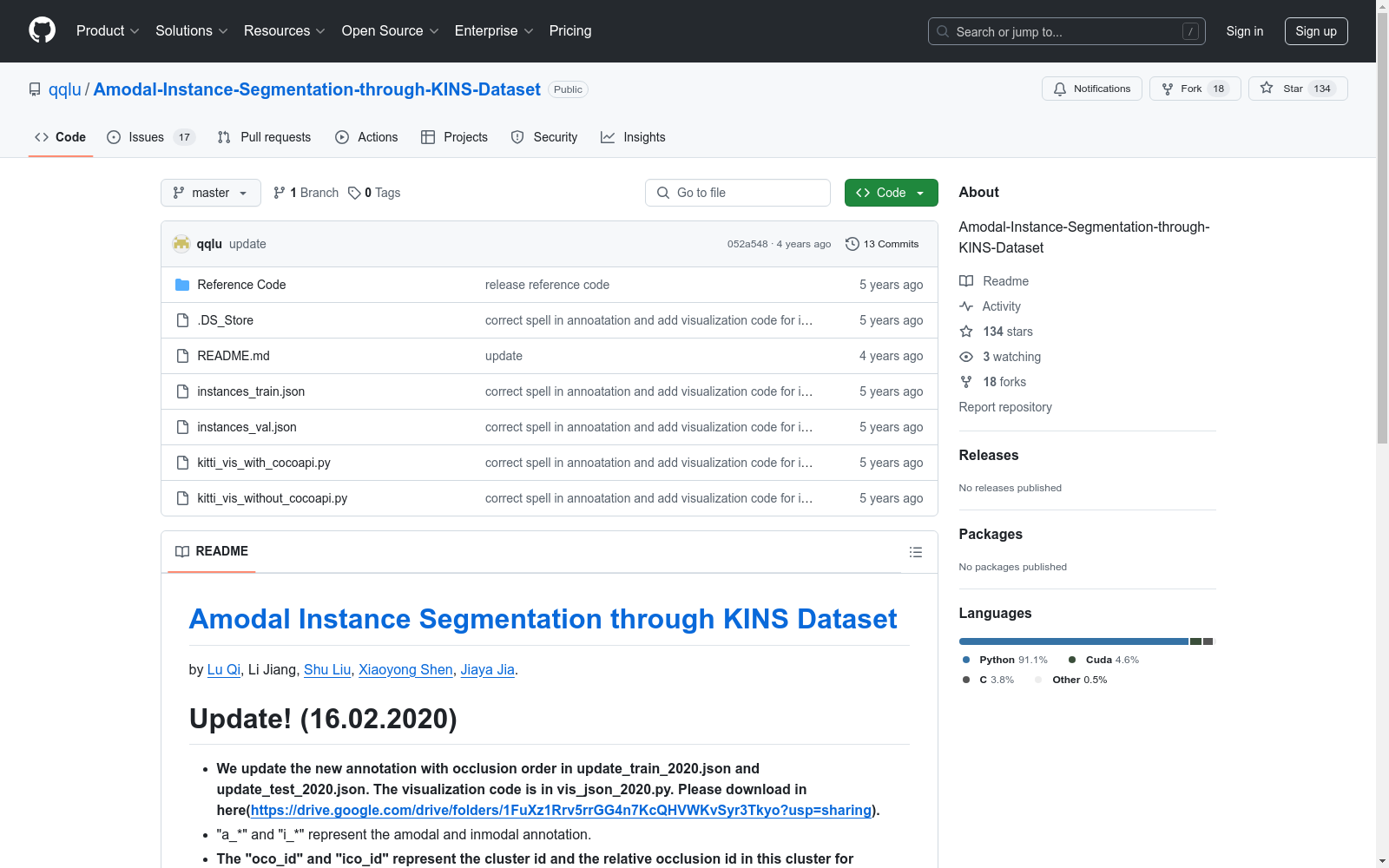

Amodal Instance Segmentation through KINS Dataset

数据集作者

- Lu Qi

- Li Jiang

- Shu Liu

- Xiaoyong Shen

- Jiaya Jia

数据集更新

- 2020年2月16日更新了包含遮挡顺序的新标注文件:update_train_2020.json 和 update_test_2020.json。

- 可视化代码位于 vis_json_2020.py。

- 下载链接:Google Drive

标注说明

- "a_" 和 "i_" 分别代表 amodal 和 inmodal 标注。

- "oco_id" 和 "ico_id" 分别代表集群ID和集群内相对遮挡ID。

数据集介绍

- 数据集包含训练和测试集,标注格式遵循COCO风格。

- 掩码可通过COCOAPI解码。

- 参考代码基于 pytorch-detectron。

数据集下载

- 下载地址:KITTI Dataset

- 下载对象数据集的左彩色图像:数据下载

引用信息

@inproceedings{qi2019amodal, title={Amodal Instance Segmentation With KINS Dataset}, author={Qi, Lu and Jiang, Li and Liu, Shu and Shen, Xiaoyong and Jia, Jiaya}, booktitle={Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition}, pages={3014--3023}, year={2019} }

giovannidemuri__sharegpt-ex50000-seed5_llama8b-er-v573-seed2-hx_256_ngt0.7_tp0.9

该数据集包含了用户与助手之间的对话,其中包含两个字段:用户发言和助手回应,均为字符串类型。训练集大小为38646852字节,共有44096条对话记录。

huggingface 收录

China Health and Nutrition Survey (CHNS)

China Health and Nutrition Survey(CHNS)是一项由美国北卡罗来纳大学人口中心与中国疾病预防控制中心营养与健康所合作开展的长期开放性队列研究项目,旨在评估国家和地方政府的健康、营养与家庭计划政策对人群健康和营养状况的影响,以及社会经济转型对居民健康行为和健康结果的作用。该调查覆盖中国15个省份和直辖市的约7200户家庭、超过30000名个体,采用多阶段随机抽样方法,收集了家庭、个体以及社区层面的详细数据,包括饮食、健康、经济和社会因素等信息。自2011年起,CHNS不断扩展,新增多个城市和省份,并持续完善纵向数据链接,为研究中国社会经济变化与健康营养的动态关系提供了重要的数据支持。

www.cpc.unc.edu 收录

Google Scholar

Google Scholar是一个学术搜索引擎,旨在检索学术文献、论文、书籍、摘要和文章等。它涵盖了广泛的学科领域,包括自然科学、社会科学、艺术和人文学科。用户可以通过关键词搜索、作者姓名、出版物名称等方式查找相关学术资源。

scholar.google.com 收录

BaiJia

BaiJia是一个由中国北京邮电大学创建的大规模历史角色扮演数据集,旨在为大语言模型提供低资源的历史角色扮演数据。该数据集包含19281个中国历史人物的信息,涵盖了唐、宋、元、明、清五个朝代。数据集的内容包括人物的传记、文学作品、家庭关系、历史事件等,数据来源广泛,包括历史文献、古籍、艺术作品、民间传说和口述传统。数据集的创建过程包括从多个来源收集人物简历、生成对话以及构建评估问题。该数据集的应用领域主要是增强大语言模型在历史角色扮演任务中的表现,旨在解决历史文本碎片化和多模态数据整合的挑战。

arXiv 收录

CFBenchmark

CFBenchmark是一个专为评估大型语言模型在中文金融助理领域性能而设计的数据集。由同济大学和上海人工智能实验室联合创建,该数据集包含3917个金融文本,覆盖金融识别、分类和生成三大方面,共计八个任务。数据集内容丰富,包括金融新闻和研究报告,文本长度从50字到超过1800字不等,旨在全面测试模型在金融文本处理中的基本能力。创建过程中,专业研究人员对文本进行了严格的筛选和标注,确保数据质量。CFBenchmark的应用领域广泛,主要用于提升金融决策的自动化和智能化水平,解决金融文本处理中的关键问题。

arXiv 收录