LCCC|中文对话数据集数据集|自然语言处理数据集

收藏数据集概述

数据集名称

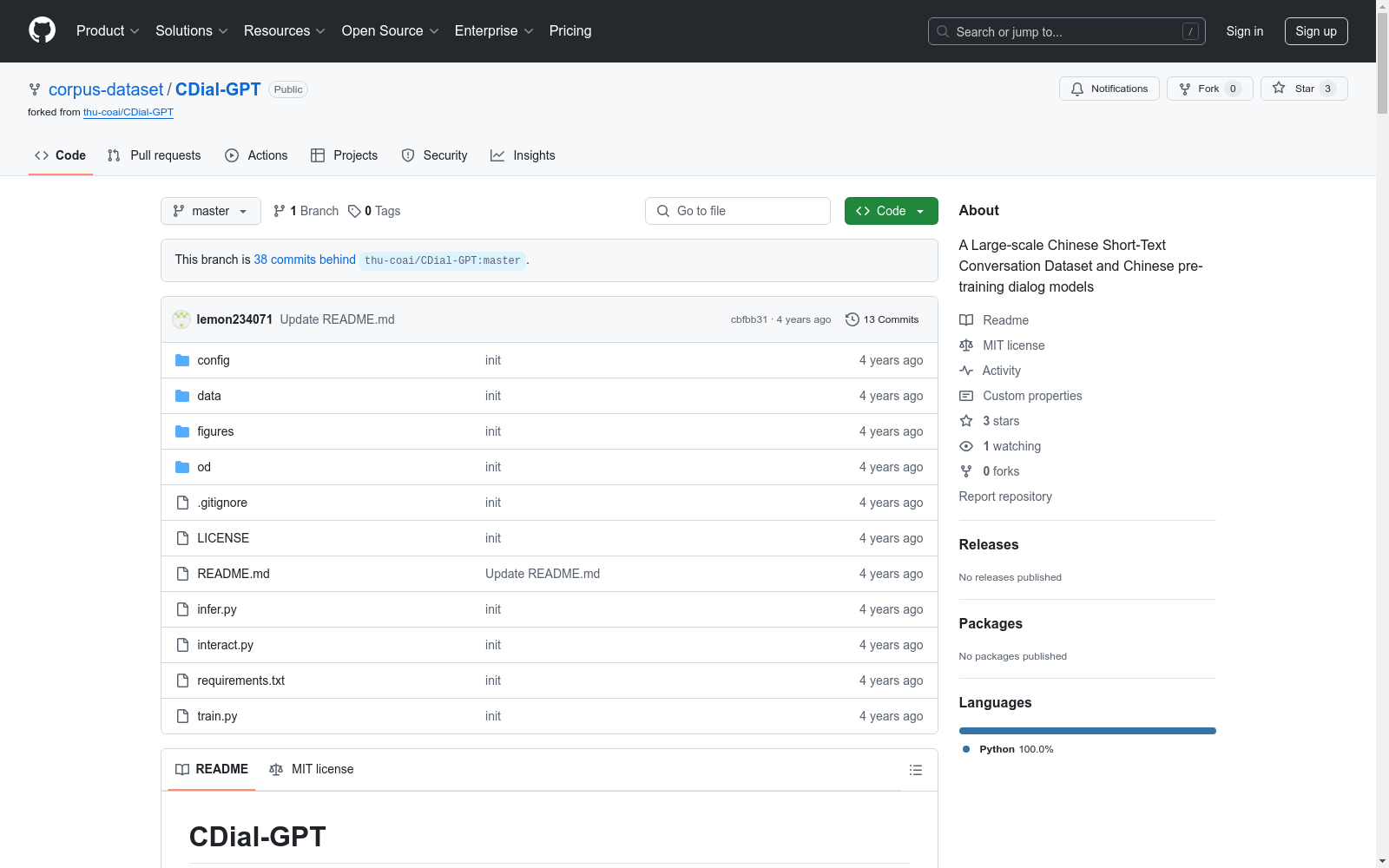

CDial-GPT

数据集描述

CDial-GPT 提供了一个大规模的经过系统清洗的中文对话数据集,名为 Large-scale Cleaned Chinese Conversation corpus (LCCC)。该数据集包括两个部分:LCCC-base 和 LCCC-large。LCCC-base 数据集更为干净但规模较小,而 LCCC-large 数据集规模更大。

数据集构成

-

LCCC-base:

- 会话数: 3,354,382 (单轮) / 3,466,607 (多轮)

- 话语数: 6,708,554 (单轮) / 13,365,268 (多轮)

- 字符数: 68,559,727 (单轮) / 163,690,614 (多轮)

- 词汇量: 372,063 (单轮) / 666,931 (多轮)

- 平均每话语字数: 6.79 (单轮) / 8.32 (多轮)

- 平均每会话轮数: 2 (单轮) / 3.86 (多轮)

-

LCCC-large:

- 会话数: 7,273,804 (单轮) / 4,733,955 (多轮)

- 话语数: 14,547,608 (单轮) / 18,341,167 (多轮)

- 字符数: 162,301,556 (单轮) / 217,776,649 (多轮)

- 词汇量: 662,514 (单轮) / 690,027 (多轮)

- 平均每话语字数: 7.45 (单轮) / 8.14 (多轮)

- 平均每会话轮数: 2 (单轮) / 3.87 (多轮)

数据集来源

LCCC-base 数据集基于微博语料库构建,而 LCCC-large 数据集则在此基础上增加了多个其他对话数据集,包括 PTT Gossiping Corpus、Subtitle Corpus、Xiaohuangji Corpus、Tieba Corpus、Qingyun Corpus、Douban Conversation Corpus、E-commerical Conversation Corpus 和 Chinese Chat Corpus。

数据集质量保证

数据集的质量通过一个严格的数据清洗流程来保证,该流程基于一系列规则和经过人工标注对话对训练的过滤器。考虑的噪音类型包括脏话、敏感词、特殊符号、表情符号、语法错误和无上下文的对话。

数据集用途

该数据集用于训练和评估中文对话预训练模型,支持模型的预训练和微调。

相关模型

- GPT<sub>Novel</sub>: 预训练于中文小说数据集。

- GPT<sub>LCCC-base</sub> 和 GPT2<sub>LCCC-base</sub>: 在 GPT<sub>Novel</sub> 基础上,后训练于 LCCC-base 数据集。

- GPT<sub>LCCC-large</sub>: 在 GPT<sub>Novel</sub> 基础上,后训练于 LCCC-large 数据集。

评估

评估包括自动评估和人工评估,评估指标包括 PPL、BLEU、Distinct 等。人工评估涉及流畅性、相关性和多样性。

中国近海台风路径集合数据集(1945-2024)

1945-2024年度,中国近海台风路径数据集,包含每个台风的真实路径信息、台风强度、气压、中心风速、移动速度、移动方向。 数据源为获取温州台风网(http://www.wztf121.com/)的真实观测路径数据,经过处理整合后形成文件,如使用csv文件需使用文本编辑器打开浏览,否则会出现乱码,如要使用excel查看数据,请使用xlsx的格式。

国家海洋科学数据中心 收录

Amazon电影评论数据集

该数据集包含从1997年8月至2012年10月期间,Amazon用户对253,059种产品的7,911,684条评论。数据集被添加了真实标签,这些标签是通过爬取/抓取Amazon.com获得的,用于分类产品。

github 收录

Google Scholar

Google Scholar是一个学术搜索引擎,旨在检索学术文献、论文、书籍、摘要和文章等。它涵盖了广泛的学科领域,包括自然科学、社会科学、艺术和人文学科。用户可以通过关键词搜索、作者姓名、出版物名称等方式查找相关学术资源。

scholar.google.com 收录

UDTIRI-Crack

UDTIRI-Crack数据集是由同济大学电子与信息工程学院等机构创建的高质量图像数据集,包含2500张来自七个公共注释数据源的图像,涵盖了不同类型的裂缝和道路表面材料,以及多种场景和照明条件。该数据集作为该领域首个全面的在线基准,用于评估现有算法在道路裂缝检测方面的性能。

arXiv 收录

Comparative Toxicogenomics Database (CTD)

Comparative Toxicogenomics Database(CTD)是一个公开的综合性数据库,专注于研究环境暴露与人类健康之间的关系。该数据库整合了化学物质、基因、疾病、通路等多维度信息,支持用户查询基因与疾病、化学物质与疾病以及化学物质与基因之间的相互作用,为毒理学研究和环境健康效应研究提供了重要资源。其最新成果包括2025年发布的20周年更新版本,进一步扩展了数据内容和功能。

ctdbase.org 收录