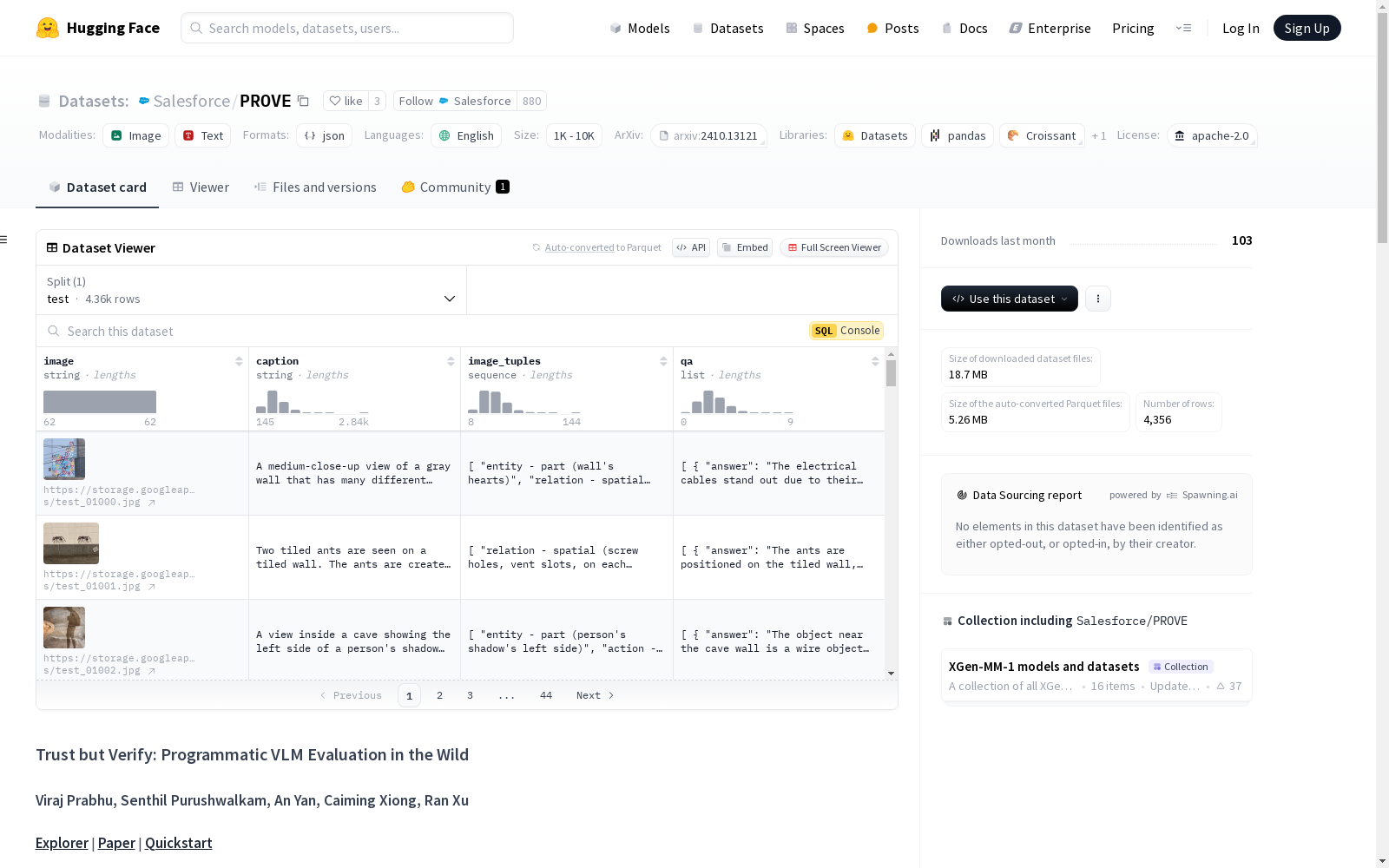

PROVE|视觉语言模型数据集|模型评估数据集

收藏PROVE 数据集概述

基本信息

- 许可证: Apache 2.0

- 语言: 英语

- 配置:

- 名称: default

- 数据文件:

- 分割: test

- 路径: prove.json

数据集描述

- 名称: Programmatic VLM Evaluation (PROVE)

- 目标: 评估视觉语言模型(VLM)对开放式查询的响应,量化响应中的幻觉效应。

- 构建方法: 使用大型语言模型(LLM)生成多样化的问答(QA)对,并通过场景图对象执行程序来验证每个QA对。

- 规模: 包含10.5k个具有视觉基础的挑战性QA对。

评估方法

- 策略: 基于场景图的程序化评估策略,测量响应的有用性和真实性。

- 模型评估: 评估多个VLM在PROVE上的有用性和真实性权衡。

快速开始

-

安装: bash conda create -n prove python=3.10 conda activate prove; pip3 install -r requirements.txt;

-

使用: bash python evaluate.py --vlm <vlm_name> --response_json <response_json_path> --scores_path <output_json_path>

排行榜

| 模型 | hscore | tscore | average |

|---|---|---|---|

| Qwen2 (2b) | 69.36 | 80.64 | 75.0 |

| Intern-VL2 (2b) | 73.96 | 79.51 | 76.74 |

| Phi-3.5-vision (4B) | 73.35 | 82.27 | 77.81 |

| LLaVA-1.5 (7B) | 72.67 | 82.58 | 77.62 |

| llava-next (7b) | 74.28 | 80.03 | 77.15 |

| Intern-VL2 (8b) | 74.55 | 80.56 | 77.56 |

| pixtral (12b) | 73.34 | 82.43 | 77.88 |

| llava-1.5 (13b) | 72.46 | 82.4 | 77.43 |

| Intern-VL2 (26b) | 74.63 | 79.23 | 76.93 |

| claude3.5-sonnet | 71.06 | 77.31 | 74.19 |

| gpt-4o-mini | 73.18 | 79.24 | 76.21 |

| gemini-1.5-flash | 72.73 | 81.74 | 77.23 |

| gpt-4o | 76.53 | 80.92 | 78.72 |

引用

@misc{prabhu2024prove, title={Trust but Verify: Programmatic VLM Evaluation in the Wild}, author={Viraj Prabhu and Senthil Purushwalkam and An Yan and Caiming Xiong and Ran Xu}, year={2024}, eprint={2410.13121}, archivePrefix={arXiv}, primaryClass={cs.CV}, url={https://arxiv.org/abs/2410.13121}, }

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

中国气象数据

本数据集包含了中国2023年1月至11月的气象数据,包括日照时间、降雨量、温度、风速等关键数据。通过这些数据,可以深入了解气象现象对不同地区的影响,并通过可视化工具揭示中国的气温分布、降水情况、风速趋势等。

github 收录

Subway Dataset

该数据集包含了全球多个城市的地铁系统数据,包括车站信息、线路图、列车时刻表、乘客流量等。数据集旨在帮助研究人员和开发者分析和模拟城市交通系统,优化地铁运营和乘客体验。

www.kaggle.com 收录

CMNEE(Chinese Military News Event Extraction dataset)

CMNEE(Chinese Military News Event Extraction dataset)是国防科技大学、东南大学和清华大学联合构建的一个大规模的、基于文档标注的开源中文军事新闻事件抽取数据集。该数据集包含17,000份文档和29,223个事件,所有事件均基于预定义的军事领域模式人工标注,包括8种事件类型和11种论元角色。数据集构建遵循两阶段多轮次标注策略,首先通过权威网站获取军事新闻文本并预处理,然后依据触发词字典进行预标注,经领域专家审核后形成事件模式。随后,通过人工分批、迭代标注并持续修正,直至满足既定质量标准。CMNEE作为首个专注于军事领域文档级事件抽取的数据集,对推动相关研究具有显著意义。

github 收录

Stanford Cars

Cars数据集包含196类汽车的16,185图像。数据被分成8,144训练图像和8,041测试图像,其中每个类被大致分成50-50。类别通常在品牌,型号,年份,例如2012特斯拉Model S或2012 BMW M3 coupe的级别。

OpenDataLab 收录