wenbopan/Chinese-dpo-pairs|偏好数据集数据集|机器翻译数据集

收藏hugging_face2024-04-02 更新2024-04-21 收录

下载链接:

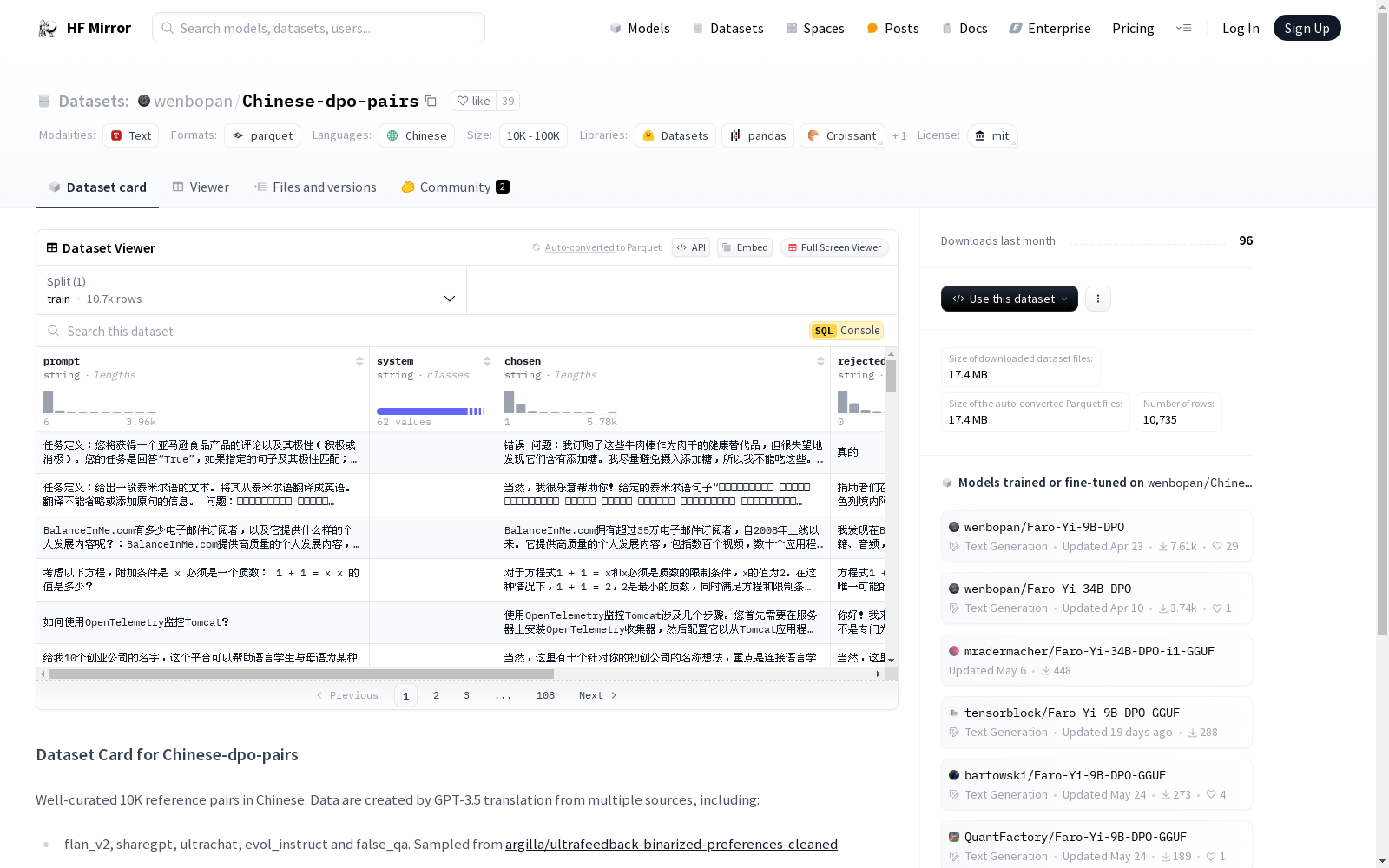

https://hf-mirror.com/datasets/wenbopan/Chinese-dpo-pairs

下载链接

链接失效反馈资源简介:

这是一个精心策划的中文数据集,包含10K对参考数据。数据通过GPT-3.5从多个来源翻译而来,包括flan_v2、sharegpt、ultrachat、evol_instruct和false_qa等,这些数据是从argilla/ultrafeedback-binarized-preferences-cleaned中采样的。此外,还包括来自Intel/orca_dpo_pairs的open_orca和来自jondurbin/truthy-dpo-v0.1的truthy_dpo。为了确保质量,最初翻译了超过30K个样本,然后删除了所有行数或主题不匹配的翻译。此数据集最好与上述英文数据集一起使用。

这是一个精心策划的中文数据集,包含10K对参考数据。数据通过GPT-3.5从多个来源翻译而来,包括flan_v2、sharegpt、ultrachat、evol_instruct和false_qa等,这些数据是从argilla/ultrafeedback-binarized-preferences-cleaned中采样的。此外,还包括来自Intel/orca_dpo_pairs的open_orca和来自jondurbin/truthy-dpo-v0.1的truthy_dpo。为了确保质量,最初翻译了超过30K个样本,然后删除了所有行数或主题不匹配的翻译。此数据集最好与上述英文数据集一起使用。

提供机构:

wenbopan

原始信息汇总

数据集概述

数据集名称

- 名称: Chinese-dpo-pairs

数据集描述

- 描述: 包含10,000对精心策划的中文参考数据,由GPT-3.5从多个来源翻译生成。

数据集来源

- 来源:

- 从argilla/ultrafeedback-binarized-preferences-cleaned采样自flan_v2, sharegpt, ultrachat, evol_instruct和false_qa。

- 来自Intel/orca_dpo_pairs的open_orca。

- 来自jondurbin/truthy-dpo-v0.1的truthy_dpo。

数据集特征

- 特征:

- prompt: 数据类型 - 字符串

- system: 数据类型 - 字符串

- chosen: 数据类型 - 字符串

- rejected: 数据类型 - 字符串

- source: 数据类型 - 字符串

- id: 数据类型 - 字符串

数据集配置

- 配置名称: train

- 数据文件:

- split: train

- 路径: train/train-*

- 默认: true

数据集大小

- 训练集:

- 字节数: 28,322,152

- 示例数: 10,735

- 下载大小: 17,430,997

- 数据集大小: 28,322,152

许可协议

- 许可: MIT

语言

- 语言: 中文

AI搜集汇总

数据集介绍

构建方式

该数据集名为wenbopan/Chinese-dpo-pairs,其构建过程涉及从多个英文数据源中选取样本,包括flan_v2、sharegpt、ultrachat、evol_instruct和false_qa,这些样本源自argilla/ultrafeedback-binarized-preferences-cleaned数据集。此外,还从Intel/orca_dpo_pairs和jondurbin/truthy-dpo-v0.1数据集中提取了部分内容。所有选取的样本通过GPT-3.5模型进行中文翻译,并经过严格筛选,剔除了翻译后行号或主题不匹配的样本,最终形成了包含10,000对高质量中文参考样本的数据集。

使用方法

该数据集适用于需要中文对话生成和偏好学习的人工智能模型训练。使用者可以通过加载数据集中的训练集(train)部分,提取prompt、system、chosen和rejected等特征,进行模型的训练和评估。建议在使用时结合原始的英文数据集,以充分利用跨语言的信息和知识。数据集的下载和使用均遵循MIT许可协议,确保了使用的灵活性和合法性。

背景与挑战

背景概述

wenbopan/Chinese-dpo-pairs数据集是由GPT-3.5翻译并精心筛选的10,000对中文参考数据集,主要用于自然语言处理领域的深度偏好优化(DPO)研究。该数据集的创建旨在提供高质量的中文数据,以支持模型在多源数据上的训练和评估。数据集的构建过程中,研究人员从多个来源如flan_v2、sharegpt、ultrachat、evol_instruct和false_qa等进行了数据采样,并通过严格的筛选过程确保了数据的一致性和质量。该数据集的发布对于推动中文自然语言处理技术的发展具有重要意义,尤其是在深度偏好优化和模型评估方面。

当前挑战

尽管wenbopan/Chinese-dpo-pairs数据集在提供高质量中文数据方面取得了显著成果,但其构建过程中仍面临若干挑战。首先,数据的多源性带来了数据一致性和质量控制的难题,尤其是在翻译过程中确保原文与译文在行号和主题上的一致性。其次,数据集的规模和多样性要求在筛选过程中进行大量的手动校对和调整,这不仅增加了数据处理的复杂性,也提高了构建成本。此外,如何确保数据集在中文语境下的适用性和广泛性,以及如何与其他英文数据集有效结合使用,也是该数据集未来需要解决的重要问题。

常用场景

经典使用场景

在自然语言处理领域,wenbopan/Chinese-dpo-pairs数据集的经典使用场景主要集中在对话系统的优化与评估。该数据集通过提供高质量的中文对话对,使得研究者能够训练和微调对话模型,以提升其在多轮对话中的表现。具体而言,研究者可以利用该数据集中的prompt、system、chosen和rejected字段,进行模型选择和偏好学习的实验,从而实现更智能、更符合用户需求的对话系统。

解决学术问题

wenbopan/Chinese-dpo-pairs数据集解决了对话系统研究中常见的偏好学习问题。通过提供经过精心筛选和翻译的中文对话对,该数据集帮助研究者克服了多语言环境下数据质量参差不齐的难题,使得模型能够更好地理解和学习用户的对话偏好。这不仅提升了对话系统的用户体验,还为跨语言对话模型的研究提供了宝贵的资源,推动了相关领域的发展。

实际应用

在实际应用中,wenbopan/Chinese-dpo-pairs数据集被广泛用于开发和优化智能客服系统、虚拟助手等对话型应用。通过利用该数据集进行模型训练和评估,企业能够构建出更高效、更人性化的对话系统,从而提升客户满意度和服务质量。此外,该数据集还可用于教育领域的智能辅导系统,帮助学生通过自然对话获取知识,提升学习效果。

数据集最近研究

最新研究方向

在自然语言处理领域,wenbopan/Chinese-dpo-pairs数据集的最新研究方向主要集中在多语言模型的优化与评估。该数据集通过GPT-3.5翻译技术,从多个高质量的英文数据源中提取并精炼出10K对中文参考样本,为研究者提供了丰富的跨语言对比资源。当前,研究者们正利用这一数据集进行模型跨语言迁移能力的提升,以及在不同语言环境下模型性能的细致评估。此外,该数据集还促进了多语言对话系统的发展,特别是在中文语境下的对话生成与优化方面,为实现更自然、更智能的人机交互提供了有力支持。

以上内容由AI搜集并总结生成