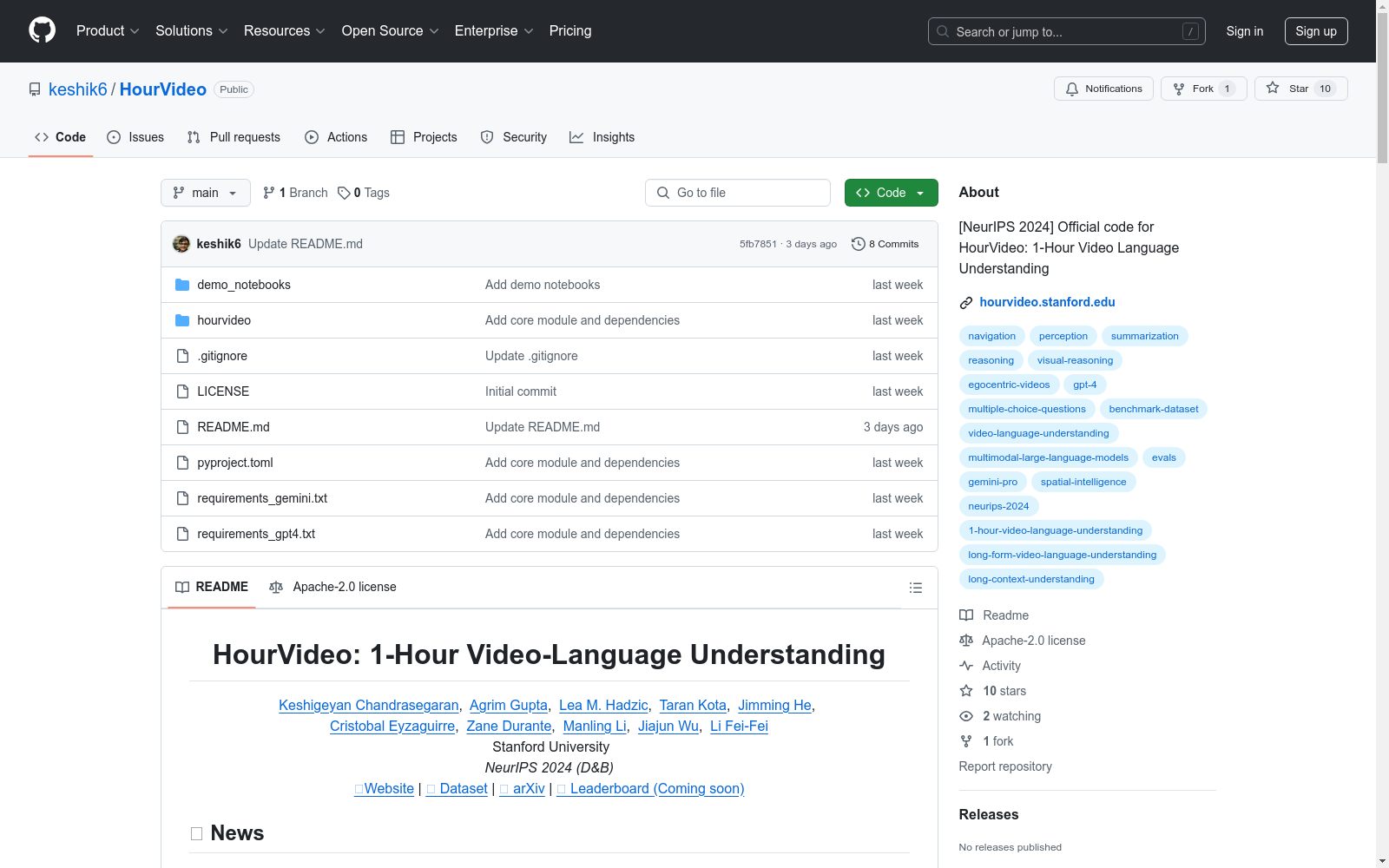

HourVideo|视频理解数据集|多模态模型数据集

收藏HourVideo: 1-Hour Video-Language Understanding

概述

HourVideo 是一个用于长时间视频语言理解的数据集,包含 500 个从 Ego4D 数据集中手动筛选的以自我为中心的视频,时长从 20 分钟到 120 分钟不等。数据集包含 12,976 个高质量的五选一多选题,涵盖总结、感知(回忆、跟踪)、视觉推理(空间、时间、预测、因果、反事实)和导航(房间到房间、物体检索)任务。

数据集组成

- 视频数量: 500 个

- 视频时长: 20 分钟到 120 分钟

- 问题数量: 12,976 个五选一多选题

任务类型

- 总结

- 感知

- 回忆

- 跟踪

- 视觉推理

- 空间

- 时间

- 预测

- 因果

- 反事实

- 导航

- 房间到房间

- 物体检索

基准结果

- GPT-4: 平均得分 19.6%

- LLaVA-34B-DPO: 平均得分 22.3%

- Gemini 1.5 Pro: 平均得分 37.3%

数据集下载

- 开发集: 包含 50 个视频,1182 个多选题,时长 39.3 小时。下载地址:HourVideo 开发集

联系信息

- Keshigeyan Chandrasegaran: keshik@stanford.edu

- Agrim Gupta: agrim@stanford.edu

- Lea M. Hadzic: lea27@stanford.edu

- Manling Li: manlingl@stanford.edu

引用

bibtex @inproceedings{chandrasegaran2024hourvideo, title={HourVideo: 1-Hour Video-Language Understanding}, author={Chandrasegaran, Keshigeyan and Gupta, Agrim and Hadzic, Lea M. and Kota, Taran and He, Jimming and Eyzaguirre, Cristobal and Durante, Zane and Li, Manling and Wu, Jiajun and Li, Fei-Fei}, booktitle = {Advances in Neural Information Processing Systems}, year={2024}, volume = {37}, }

AIS数据集

该研究使用了多个公开的AIS数据集,这些数据集经过过滤、清理和统计分析。数据集涵盖了多种类型的船舶,并提供了关于船舶位置、速度和航向的关键信息。数据集包括来自19,185艘船舶的AIS消息,总计约6.4亿条记录。

github 收录

集装箱图像数据集

本数据集主要是使用Realsense 435I相机对堆场实验平台中的集装箱堆进行拍摄得到的图像文件,对识别集装箱上表面的实例分割算法进行了训练和验证,包括1个用于训练实例分割模型的训练集图像文件夹和1个验证实例分割模型准确性的验证集图像文件夹。

国家基础学科公共科学数据中心 收录

DNS-Challenge

深度噪声抑制挑战数据集,包含干净的语音和噪声剪辑,用于训练和评估在有噪声环境下增强语音的模型。

huggingface 收录

CMU-MOSI

CMU-MOSI数据集包括了从93个YouTube的视频中获取的2199个独白类型的短视频片段。每个片段都是一个独立的多模态示例,其中图像、文本和音频占比是均匀的,情感分数取值为[-3,+3],表示从强负向到强正向情感。

DataCite Commons 收录

MIDV-500

该数据集包含使用移动设备拍摄的不同文档图像,这些图像通常具有投影变形。数据集分为训练和测试两部分,其中训练部分包含30种文档类型,测试部分包含20种,在应用神经网络之前,所有图像都被缩放到统一的宽度,宽度为400像素。该数据集的任务是进行消失点检测。

arXiv 收录