Vesuvius Challenge CT Scan Papyrus Scroll Segmentation Dataset|CT扫描数据集|图像分割数据集

收藏github2024-07-01 更新2024-07-03 收录

下载链接:

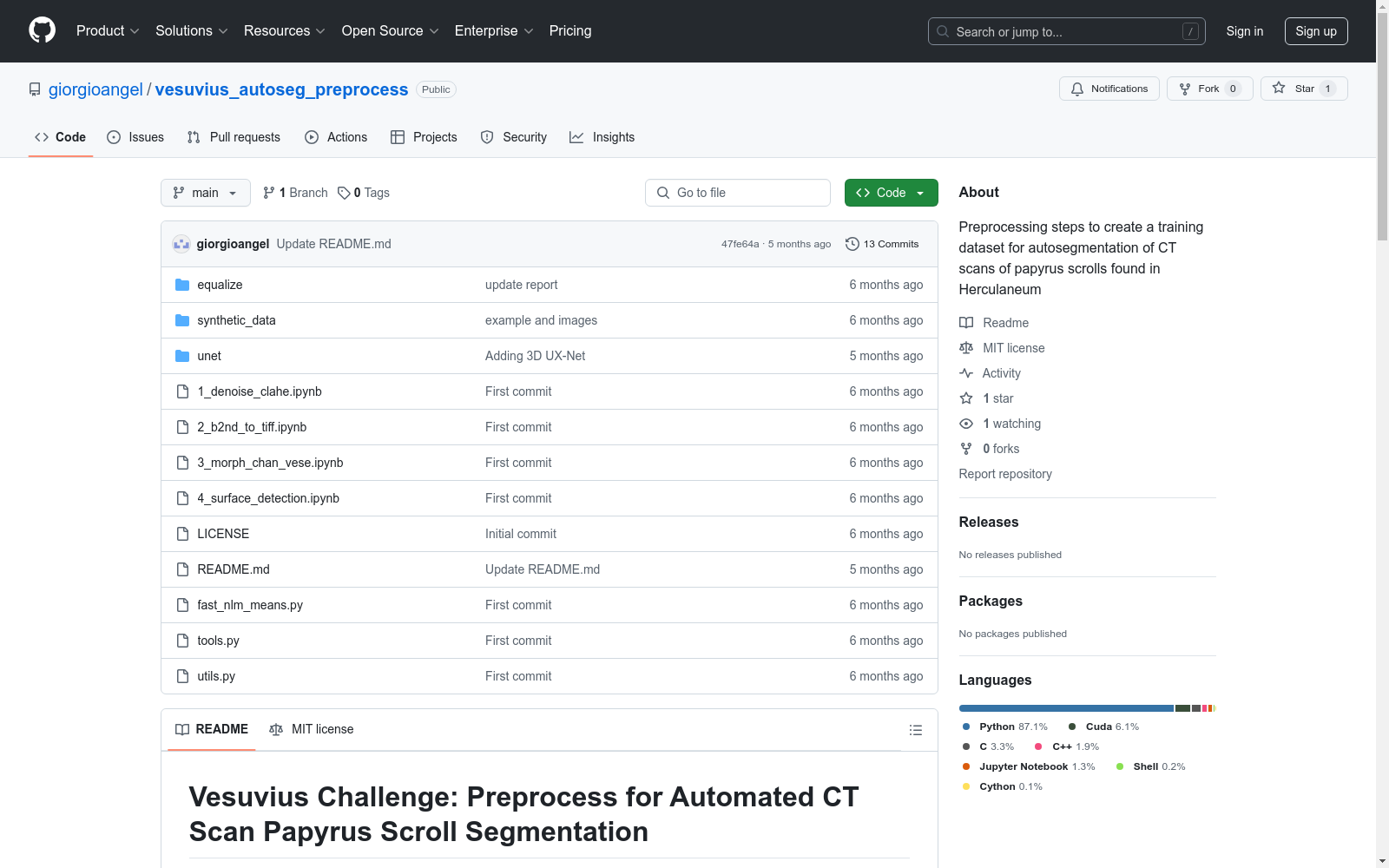

https://github.com/giorgioangel/vesuvius_autoseg_preprocess

下载链接

链接失效反馈资源简介:

该数据集用于训练自动分割CT扫描纸莎草卷的模型,包含多个预处理步骤和合成数据生成脚本。

创建时间:

2024-06-14

原始信息汇总

Vesuvius Challenge: Preprocess for Automated CT Scan Papyrus Scroll Segmentation

数据集预处理步骤

1. 去噪和对比度增强

- Notebook:

1_denoise_clahe.ipynb - 描述: 该Notebook使用非局部均值进行体积去噪,并通过CLAHE在多GPU并行设置中增强对比度。

2. 体积到堆栈转换

- Notebook:

2_b2nd_to_tiff.ipynb - 描述: 将去噪和对比度增强后的体积(保存为B2NDarray)转换为TIFF图像堆栈。

3. 形态学Chan Vese分割

- Notebook:

3_morphological_chan_vese.ipynb - 描述: 应用形态学Chan Vese算法生成厚体积标签。

4. 三维表面检测

- Notebook:

4_surface_detection.ipynb - 描述: 使用梯度幅值和Hessian行列式的绝对值对每个体素进行阈值处理,进行表面检测。梯度和Hessian通过Pavel Holoborodko的3D噪声鲁棒梯度算子估计,结合各向同性噪声抑制和精确梯度估计。结果应用非极大值抑制。

合成数据集

- 脚本:

.synthetic_datadataset.py - 描述: 包含生成完全合成数据集的脚本。 示例创建数据集: python block_size = [128, 128, 128] synthetic_dataset = SyntheticDataset(num_samples=1000, array_shape=tuple(block_size), transform=get_transforms(tuple(block_size)))

深度神经网络的语义分割

3D UX-Net

- 训练脚本:

.unet rain_uxnet.py --config config-uxnet.yaml - 描述: 用于训练3D UX-Net进行语义分割的训练脚本。使用的损失函数是二元焦点损失和边界损失的混合。为了改进实例分离,在全立方体上进行初步训练后,使用中等强度体素(明显不是空气)遮蔽边界可以提高指标。还使用软标签1 -> 0.95和0 -> 0.05。

3D UNet

- 训练脚本:

.unet rain.py --config config.yaml - 描述: 用于在多个数据集上训练3D UNet进行语义分割的训练脚本。使用的损失函数是统一对称焦点损失和边界损失的混合,特别适用于不平衡的3D分割数据集。应用权重指数移动平均(EMA)以稳定训练,因为在噪声标签的场景中,文献中有使用EMA改善训练性能的积极结果。

使用方法

-

克隆仓库: bash git clone https://github.com/yourusername/vesuvius-ct-scan-segmentation.git cd vesuvius-ct-scan-segmentation

-

安装依赖项(要求文件即将提供)。

-

按提供的顺序打开并运行Notebook以预处理CT扫描数据。记得在单元格中更改路径。

AI搜集汇总

数据集介绍

构建方式

该数据集的构建过程经过精心设计,分为多个步骤以确保高质量的CT扫描图像分割。首先,通过非局部均值(Non-Local-Means)进行去噪处理,并利用对比度受限的自适应直方图均衡化(CLAHE)增强图像对比度。随后,将处理后的体积数据转换为TIFF图像堆栈,以便进一步分析。接着,应用形态学Chan-Vese算法生成厚体积标签,最后通过表面检测技术在三维空间中进行精确的分割。此外,还包含一个合成数据生成脚本,用于创建完全合成的数据集,以增强模型的泛化能力。

特点

该数据集的显著特点在于其多步骤的预处理流程,确保了CT扫描图像的高质量分割。通过非局部均值去噪和CLAHE对比度增强,有效提升了图像的清晰度和对比度。形态学Chan-Vese算法和三维表面检测技术的应用,进一步提高了分割的准确性和细节捕捉能力。此外,合成数据集的引入为模型训练提供了多样化的数据支持,有助于提升模型的鲁棒性和泛化能力。

使用方法

使用该数据集时,首先需克隆GitHub仓库并安装相关依赖。随后,按照提供的顺序运行各个预处理笔记本,确保CT扫描数据的正确预处理。每个步骤都处理体积数据的分离块,确保处理的高效性和准确性。特别地,合成数据集的生成脚本提供了创建多样化数据集的便捷方式,用户可根据需求调整参数以生成适合的训练数据。此外,提供了3D UX-Net和3D UNet的训练脚本,用户可根据具体需求选择合适的模型进行训练。

背景与挑战

背景概述

Vesuvius Challenge CT Scan Papyrus Scroll Segmentation Dataset是由Vesuvius Challenge项目创建的,旨在通过CT扫描技术对古埃及纸莎草卷进行自动化分割。该项目由知名研究机构和专家团队主导,核心研究问题是如何在复杂的CT扫描图像中准确识别和分割纸莎草卷的各个部分。该数据集的创建不仅推动了文化遗产保护技术的发展,还为深度学习在医学影像处理领域的应用提供了宝贵的资源。

当前挑战

该数据集在构建过程中面临多项挑战。首先,CT扫描图像中存在大量的噪声和低对比度区域,这增加了图像预处理的难度。其次,纸莎草卷的复杂结构和多样性使得分割任务异常复杂,需要高效的算法和模型来实现精确的语义和实例分割。此外,由于缺乏高质量的标注数据,模型的训练和评估也面临较大困难。这些挑战不仅影响了数据集的质量,也限制了其在实际应用中的效果。

常用场景

经典使用场景

Vesuvius Challenge CT Scan Papyrus Scroll Segmentation Dataset 主要用于古卷轴的CT扫描图像的自动分割。通过该数据集,研究人员可以训练深度神经网络模型,如3D UX-Net和3D UNet,以实现对古卷轴中文字和图像的精确分割。这种分割技术不仅有助于恢复古卷轴的原始内容,还能为历史学家和考古学家提供宝贵的研究材料。

实际应用

在实际应用中,Vesuvius Challenge CT Scan Papyrus Scroll Segmentation Dataset 被广泛用于文化遗产保护和历史研究。例如,考古学家可以利用该数据集快速分析和解读古卷轴,从而加速历史文献的数字化进程。此外,博物馆和图书馆也可以利用这一技术来保存和展示珍贵的古卷轴,确保这些文化遗产得以长久保存。

衍生相关工作

基于该数据集,研究者们开发了多种深度学习模型,如3D UX-Net和3D UNet,这些模型在古卷轴分割任务中表现出色。此外,该数据集还激发了其他相关研究,如Flood-Filling Networks的改进和应用,进一步推动了3D图像分割技术的发展。这些衍生工作不仅丰富了古卷轴研究的工具箱,也为其他领域的3D图像处理提供了新的思路和方法。

以上内容由AI搜集并总结生成