Chumor|中文幽默理解数据集|大型语言模型数据集

收藏arXiv2024-12-24 更新2024-12-25 收录

下载链接:

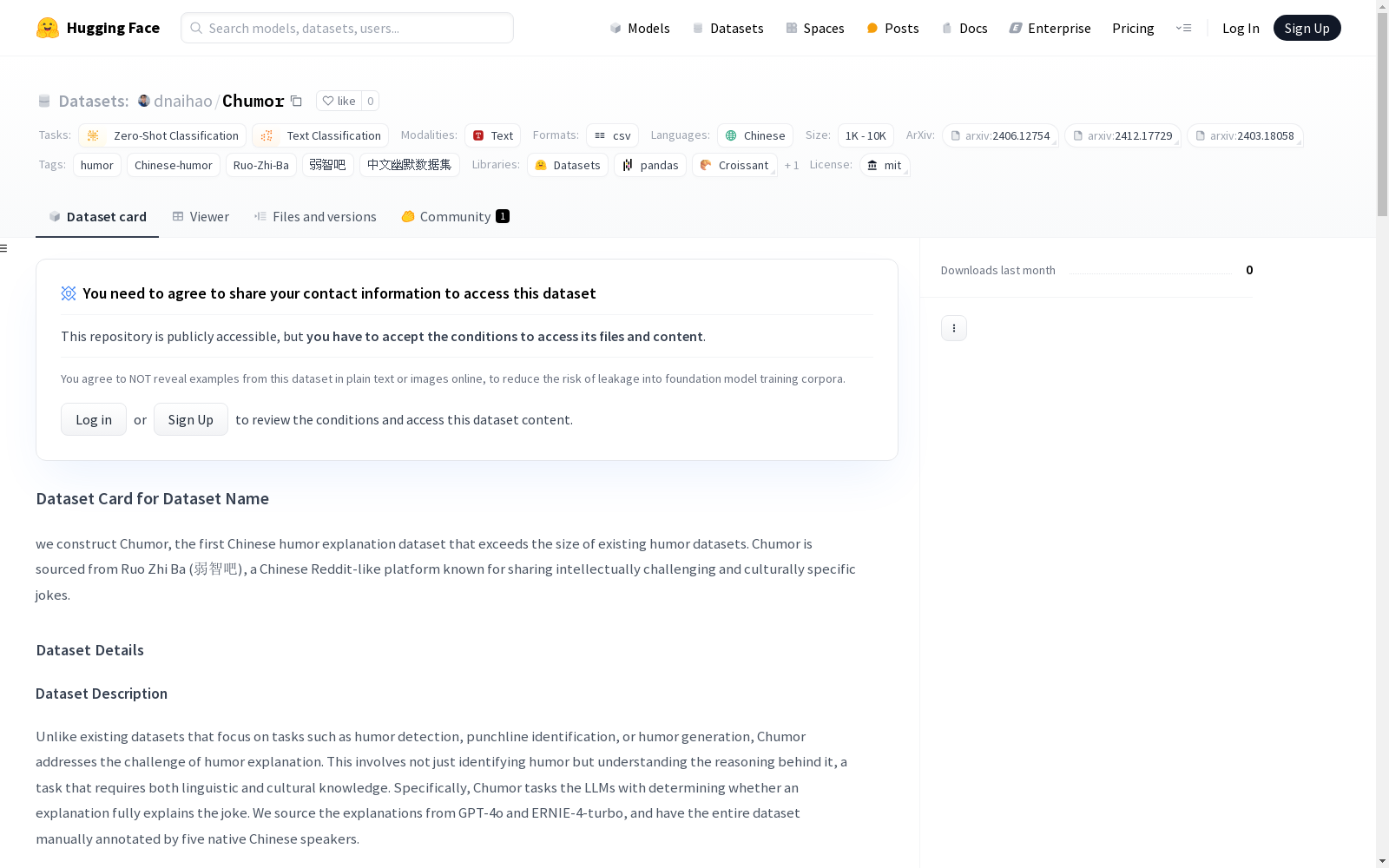

https://huggingface.co/datasets/dnaihao/Chumor

下载链接

链接失效反馈资源简介:

Chumor是由密歇根大学、卡内基梅隆大学和上海交通大学联合创建的第一个中文幽默解释数据集,旨在填补非英语语言幽默理解资源的空白。该数据集从中国类似Reddit的平台“弱智吧”(RZB)中收集,包含3339条幽默笑话及其解释,涵盖多种幽默类型。数据集通过手动标注和模型生成的解释进行分类,主要用于测试大型语言模型(LLMs)在中文幽默理解中的表现。Chumor的应用领域主要集中在文化特定的幽默理解研究,旨在解决现有LLMs在中文幽默解释任务中的不足。

提供机构:

密歇根大学、卡内基梅隆大学、上海交通大学

创建时间:

2024-12-24

AI搜集汇总

数据集介绍

构建方式

Chumor数据集通过从中国类似Reddit的论坛Ruo Zhi Ba(弱智吧)中收集笑话构建而成,该平台以分享具有文化特定性和智力挑战性的笑话而闻名。数据集涵盖了2018年至2021年间的‘最佳年度帖子’和‘版主推荐’部分的内容。每个笑话包括标题和内容,并经过去重和清理,确保笑话的完整性和质量。此外,数据集中的笑话解释由GPT-4o和ERNIE4-turbo生成,并由五位母语为中文的注释者进行手动标注,标注结果分为‘完全解释’和‘部分/没有解释’两类,最终形成了3,339个实例的数据集。

特点

Chumor数据集的显著特点在于其专注于幽默解释任务,而不仅仅是幽默检测或笑话生成。该数据集包含了多种类型的笑话,如基于文化背景、情景、双关语、同音字、字形和跨语言的笑话,这些笑话要求模型具备深厚的语言和文化知识。此外,数据集的构建方式确保了其规模超过现有的幽默数据集,且具有较高的文化特定性和挑战性,能够有效评估大型语言模型在中文幽默理解方面的能力。

使用方法

Chumor数据集主要用于评估大型语言模型(LLMs)在中文幽默理解任务中的表现。研究者可以通过直接提示(DP)或链式思维提示(CoT)方法,要求模型判断给定的解释是否完全解释了笑话。数据集的实例包括笑话及其解释,模型需要根据解释的完整性进行分类。通过对比模型生成的解释与人工标注的解释,研究者可以评估模型在不同类型笑话上的表现,并进一步优化模型的幽默理解能力。

背景与挑战

背景概述

随着大型语言模型(LLMs)的快速发展,研究人员在多个领域对其性能进行了广泛评估,尤其是在幽默理解方面。然而,现有的幽默数据集和评估主要集中在英语,忽略了非英语语言中文化特定的幽默理解。为了填补这一空白,密歇根大学、卡内基梅隆大学和上海交通大学的研究人员于2024年共同构建了Chumor数据集,这是首个专注于中文幽默解释的大型数据集。Chumor数据集从中国类似Reddit的平台‘弱智吧’中收集,该平台以其智力挑战和文化特定的笑话而闻名。通过测试十种LLMs,研究人员发现Chumor对现有模型提出了显著挑战,揭示了LLMs在中文幽默理解上的不足。

当前挑战

Chumor数据集的构建和应用面临多重挑战。首先,中文幽默的理解需要深厚的文化背景知识,包括历史、社会和语言的细微差别,这对LLMs的文化敏感性提出了高要求。其次,数据集的构建过程中,研究人员需要从大量非结构化的网络文本中筛选出高质量的幽默内容,并进行细致的标注和分类,这一过程耗时且复杂。此外,LLMs在处理中文幽默时表现不佳,准确率远低于人类水平,尤其是在涉及双关语、文化背景和语言歧义的笑话类型中。最后,链式思维提示(CoT)并未显著提升模型的表现,甚至在某些情况下导致性能下降,表明当前LLMs在幽默推理方面的局限性。

常用场景

经典使用场景

Chumor数据集的经典使用场景在于评估和提升大型语言模型(LLMs)对中文幽默的理解能力。通过提供来自中国论坛Ruo Zhi Ba(弱智吧)的多样化幽默样本,Chumor允许研究人员测试模型在不同幽默类型(如双关语、文化背景依赖、情景幽默等)中的表现。这种评估不仅有助于识别模型在理解中文幽默时的局限性,还能为模型在跨文化背景下的推理能力提供深入洞察。

衍生相关工作

Chumor数据集的发布催生了一系列相关研究工作,特别是在中文幽默理解和跨文化推理领域。例如,一些研究者利用Chumor数据集对不同类型的中文幽默进行分类和分析,进一步揭示了模型在处理复杂文化背景时的局限性。此外,Chumor还激发了对多语言模型在不同文化背景下的推理能力进行更深入研究的兴趣,推动了跨文化推理基准的建立和发展。

数据集最近研究

最新研究方向

Chumor数据集的最新研究方向主要集中在探索大型语言模型(LLMs)在中文幽默理解中的表现。研究者通过构建Chumor 2.0数据集,评估了多种LLMs在幽默解释任务中的性能,发现这些模型在理解中文幽默时存在显著挑战。研究不仅揭示了LLMs在文化特定幽默理解中的局限性,还通过对比人类标注的解释与模型生成的解释,展示了人类在幽默解释任务中的显著优势。此外,研究还探讨了链式思维(CoT)提示对模型性能的影响,发现CoT提示在某些情况下反而降低了模型的表现。这些发现为未来在多语言和文化特定幽默理解领域的研究提供了重要参考。

相关研究论文

- 1Chumor 2.0: Towards Benchmarking Chinese Humor Understanding密歇根大学、卡内基梅隆大学、上海交通大学 · 2024年

以上内容由AI搜集并总结生成