Institutional Books 1.0|机构藏书数据集|自然语言处理数据集

收藏arXiv2025-06-10 更新2025-06-12 收录

下载链接:

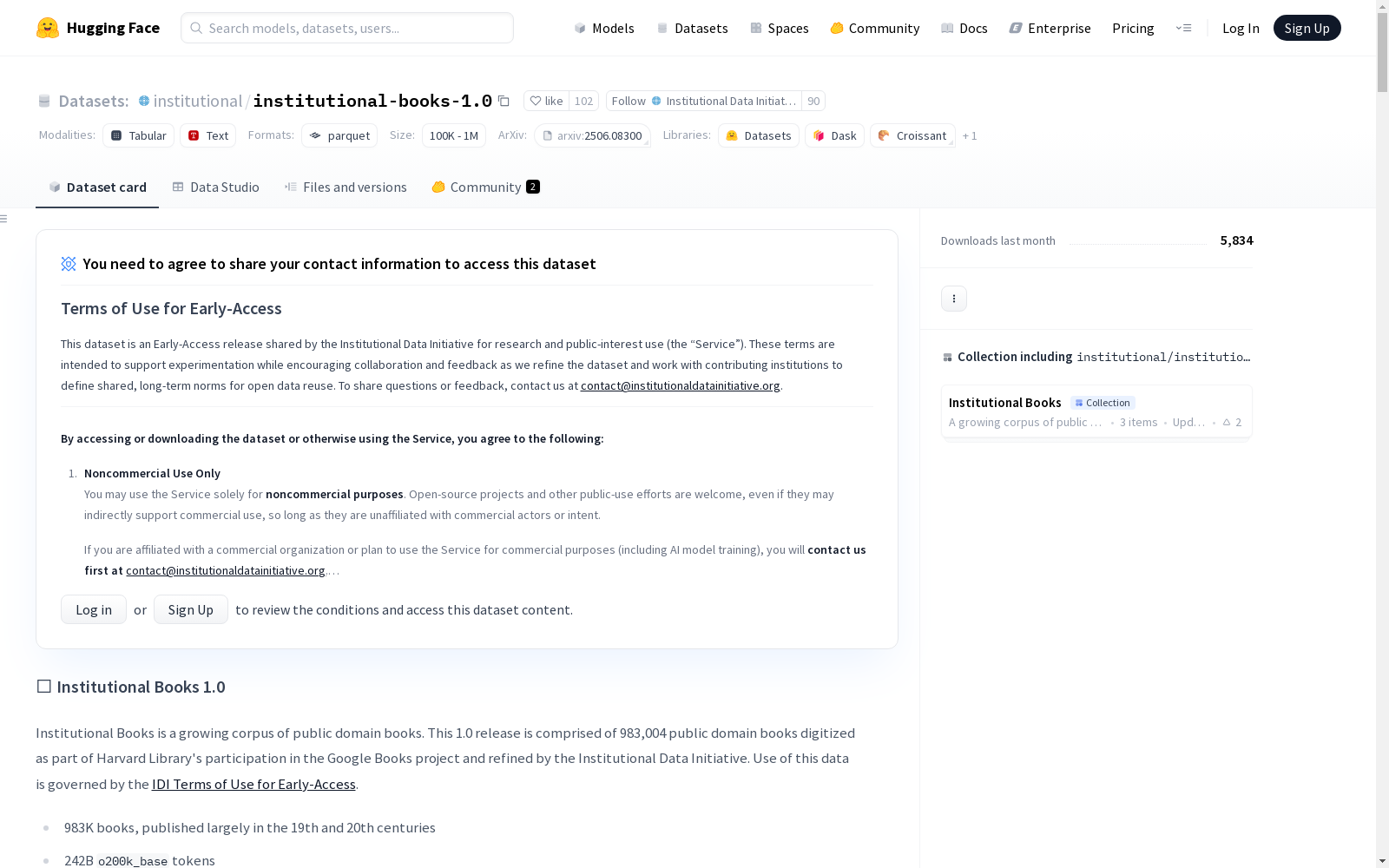

https://huggingface.co/datasets/instdin/institutional-books-1.0

下载链接

链接失效反馈资源简介:

Institutional Books 1.0 是一个由哈佛图书馆的藏品组成的大型数据集,包含了2420亿个token的公共领域书籍。该数据集由哈佛法学院图书馆、图书馆创新实验室和哈佛图书馆合作创建,旨在为大型语言模型(LLMs)提供高质量的训练数据。数据集涵盖了1,075,899卷,使用250多种语言编写,总共有约2500亿个token。其中,983,004卷被认为是公共领域的,包括原始和后处理的OCR提取文本以及书目、来源和生成的元数据。数据集涵盖了多个世纪,其中60%的内容是在1820年至1920年间出版的。该数据集可用于文学、法律、哲学、科学等领域的训练,旨在解决大型语言模型训练数据稀缺的问题。

提供机构:

哈佛法学院图书馆

创建时间:

2025-06-10

AI搜集汇总

数据集介绍

构建方式

Institutional Books 1.0数据集基于哈佛图书馆与Google Books合作项目中的公共领域书籍构建而成。研究人员通过GRIN API检索了1,075,899卷数字化书籍的扫描图像、OCR文本和元数据,经过解密和提取处理后形成原始数据集。为确保数据质量,研究团队对OCR文本进行了去重、语言检测、主题分类等多层次分析,并开发了专门的文本后处理流程以提升机器可读性。最终发布的版本包含983,004卷经权利确认的公共领域书籍,共计2420亿token。

特点

该数据集最显著的特点是涵盖了大量历史文献,其中60%的内容出版于1820至1920年间,具有重要的历史研究价值。数据集支持多语言分析,包含250种语言标识的文本,在细粒度分析中更检测到379种语言的存在。独特的主题分类系统基于国会图书馆分类法,可识别20个主要主题领域,其中文学、法律、哲学和科学类文献占主导地位。此外,数据集提供了原始OCR文本和经过特殊处理的两个版本,以及详尽的元数据描述,为研究者提供了丰富的分析维度。

使用方法

该数据集特别适合用于语言模型训练、数字人文研究和跨学科分析。使用者可通过Hugging Face平台获取数据集,利用提供的元数据字段(如语言代码、出版年代、主题分类等)进行高效筛选。对于机器学习应用,建议结合OCR质量评分和文本分析指标评估数据适用性。研究历史文献时,应注意数据集可能包含过时或具有时代局限性的内容。数据集采用非商业许可协议,使用者需遵守相关条款,并可通过GitHub获取配套的数据处理管道和分类模型以支持进一步研究。

背景与挑战

背景概述

Institutional Books 1.0是由哈佛大学法学院图书馆的Institutional Data Initiative团队于2023年推出的一个大规模公共领域书籍数据集。该数据集源自哈佛图书馆参与Google Books项目的数字化成果,始于2006年,涵盖了来自哈佛图书馆收藏的107万册书籍,涉及250多种语言,总计约2500亿个标记。数据集的核心研究问题在于解决当前大型语言模型(LLMs)训练数据稀缺、质量不均和来源多样性的挑战。通过提供高质量、经过严格处理的文本数据,该数据集旨在为自然语言处理、机器学习和数字人文研究提供可靠的数据支持。其影响力不仅体现在为AI社区提供了多样化的训练资源,还通过强调数据来源的透明性和可持续管理,推动了数据伦理和治理的讨论。

当前挑战

构建Institutional Books 1.0数据集面临多重挑战。首先,在领域问题层面,数据集需解决OCR提取文本中的噪声问题,如错误的字符识别、版面混乱(如表格和乐谱)以及多语言混合文本的处理,这些因素直接影响模型训练的质量。其次,在构建过程中,团队需应对大规模数据检索的技术难题,包括从Google Books接口获取加密数据、处理70,922册无法检索的书籍,以及跨语言、跨世纪的元数据整合。此外,数据集的版权状态确认依赖于HathiTrust的复杂权利判定流程,需确保仅包含无版权争议的文本(占91.37%)。最后,历史文本中存在的过时或有害内容(如种族歧视表述)也要求设计严格的过滤机制和使用警示。

常用场景

经典使用场景

Institutional Books 1.0数据集作为哈佛图书馆数字化馆藏的重要组成部分,广泛应用于自然语言处理(NLP)和大型语言模型(LLM)的预训练与微调。其2420亿标记的文本覆盖了超过250种语言,特别适合用于跨语言模型的训练。该数据集在长上下文理解和生成任务中表现出色,因其平均每卷文本长度超过10万标记,为模型处理复杂语义关系提供了丰富素材。

解决学术问题

该数据集有效缓解了高质量训练数据稀缺的学术困境,通过提供经过严格去重、OCR后处理及语言分析的公共领域文本,解决了数据来源混杂、版权不清等问题。其详尽的元数据标注(包括时间跨度、语言分布和主题分类)为研究数据偏差、模型多语言能力等关键课题提供了基准。特别在低资源语言模型训练方面,数据集包含的230种百万标记级语言资源显著提升了小语种模型的性能上限。

衍生相关工作

该数据集催生了多个里程碑式研究,包括基于其主题分类器改进的BERT变体Institutional-BERT,以及针对历史文本优化的OCR校正工具包。相关团队进一步开发了图像文本分离技术,从原始扫描件中提取图表数据形成多模态数据集。其数据处理方法论更被Common Corpus等项目借鉴,推动了知识机构数据发布的标准化进程。

以上内容由AI搜集并总结生成