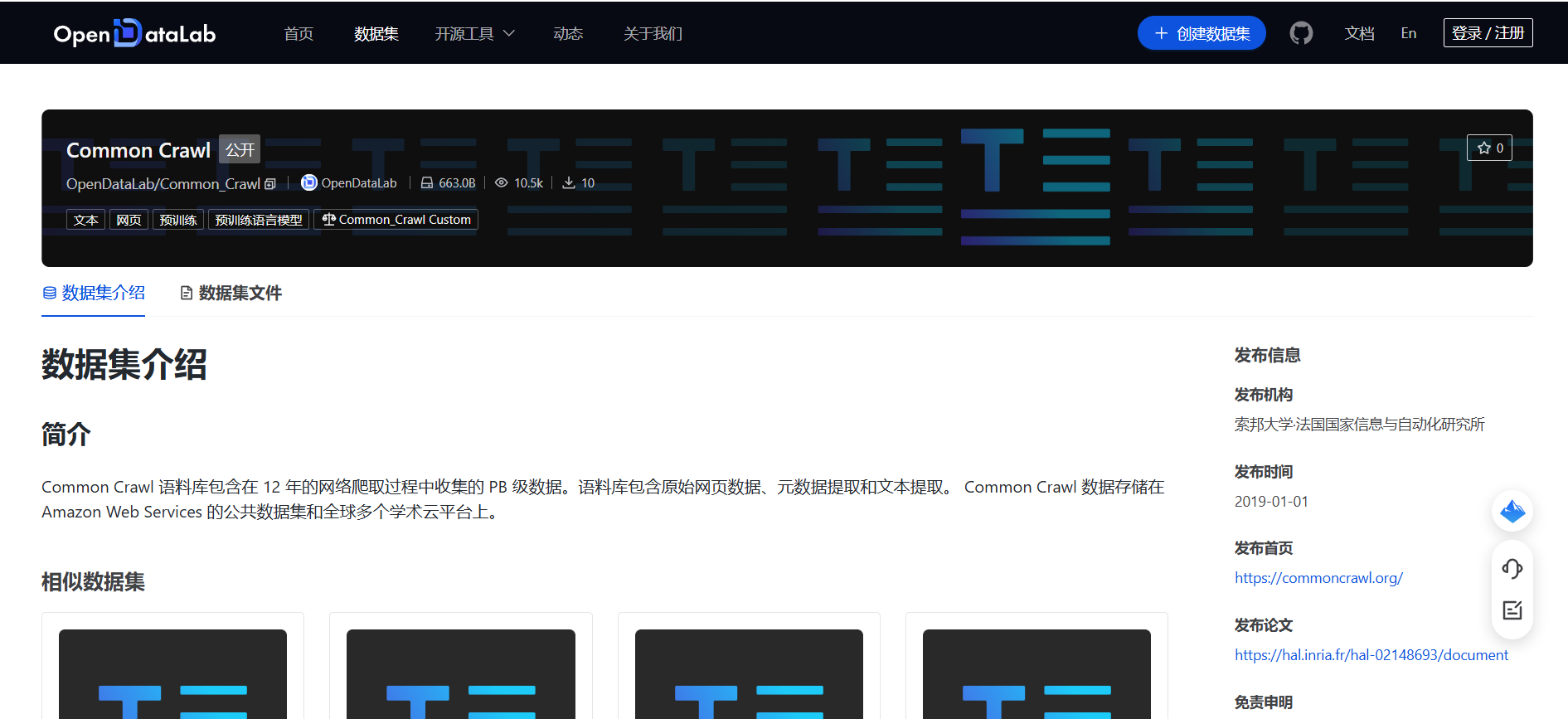

Common Crawl|网络爬取数据集|文本挖掘数据集

收藏

- Common Crawl项目正式启动,旨在创建一个开放的网络数据集,供研究人员和开发者使用。

- 首次发布Common Crawl数据集,包含约50亿个网页的文本数据,标志着该项目进入实际应用阶段。

- Common Crawl数据集的规模显著扩大,涵盖了超过100亿个网页,成为全球最大的开放网络数据集之一。

- Common Crawl开始提供每月更新的数据集,确保数据的时效性和实用性,进一步推动了其在学术和工业界的应用。

- Common Crawl数据集被广泛应用于自然语言处理、机器学习和数据挖掘等领域,成为研究者和开发者的重要资源。

stanford_cars

该数据集是一个包含多个汽车品牌和型号的图片数据集,每个图片样本都标记有相应的汽车品牌和型号信息。数据集适用于图像识别和分类任务,特别是汽车品牌和型号的识别。

huggingface 收录

UAVDT Dataset

The authors constructed a new UAVDT Dataset focused on complex scenarios with new level challenges. Selected from 10 hours raw videos, about 80, 000 representative frames are fully annotated with bounding boxes as well as up to 14 kinds of attributes (e.g., weather condition, flying altitude, camera view, vehicle category, and occlusion) for three fundamental computer vision tasks: object detection, single object tracking, and multiple object tracking.

datasetninja.com 收录

双色球开奖号码数据集

双色球开奖号码数据集从2003001-2025011

魔搭社区 收录

云浮市人口状况表信息

该数据包含了2022年至今云浮市人口状况表,指云浮市政务服务数据管理局对该信息的变动情况进行跟踪、采集、预测、分析、公布等活动。

开放广东 收录

GME Data

关于2021年GameStop股票活动的数据,包括每日合并的GME短期成交量数据、每日失败交付数据、可借股数、期权链数据以及不同时间框架的开盘/最高/最低/收盘/成交量条形图。

github 收录