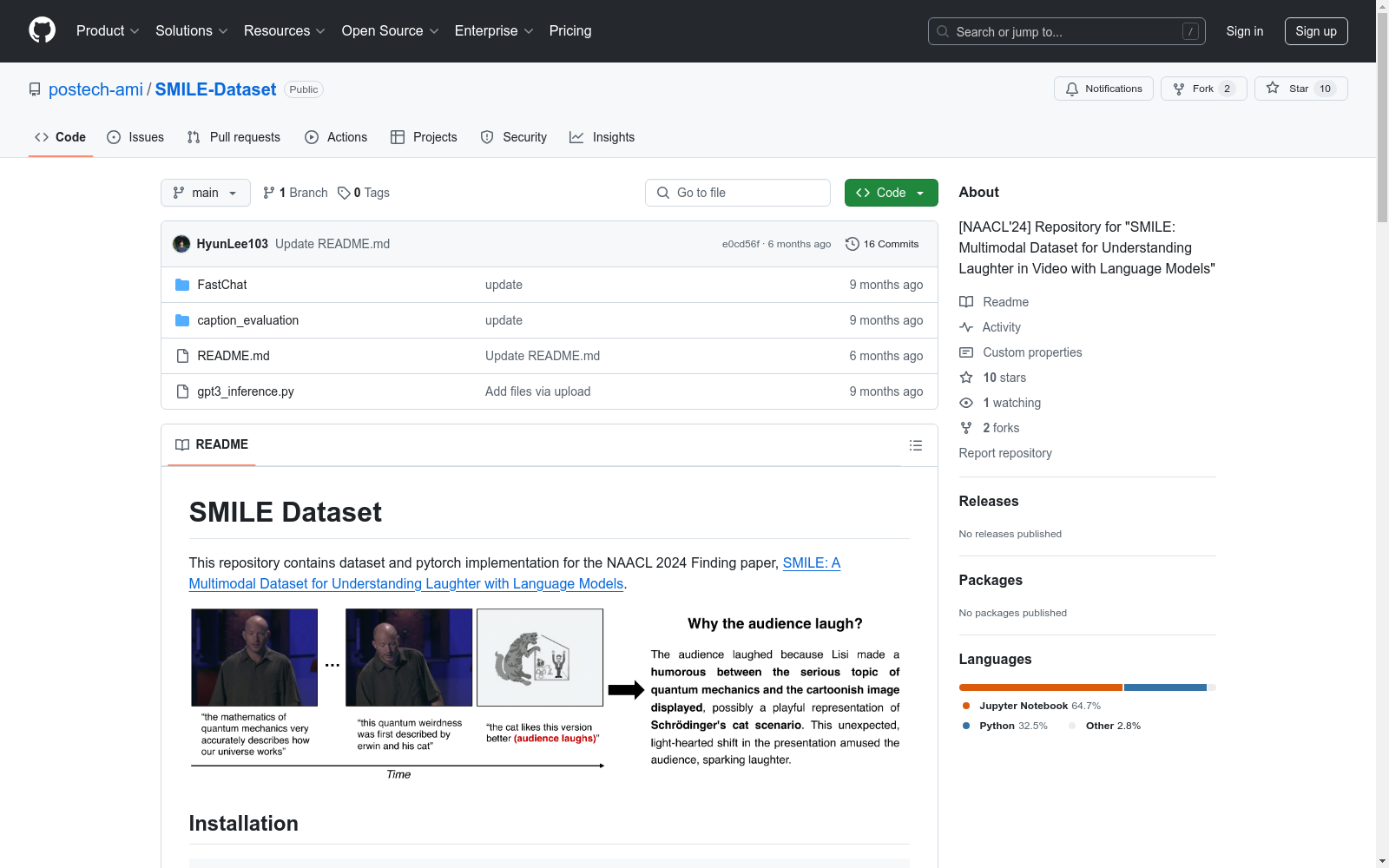

SMILE Dataset|情感分析数据集|多模态学习数据集

收藏SMILE Dataset 概述

数据集版本

- SMILE Dataset v.2: 当前正在更新,更新后将更新笑的推理基准。

- SMILE Dataset v.1: 提供用于评估的版本。

数据集结构

-

SMILE Dataset v.2:

├── annotations | ├── data_split.json | ├── GT_laughter_reason.json | └── multimodal_textual_representation.json | └── videos └── SMILE_videos.zip ├── video_clips └── video_segments

- data_split.json: 训练、验证、测试分割的关键索引。

- GT_laughter_reason.json: 视频片段的Ground-Truth笑的原因。

- multimodal_textual_representation.json: 从视频片段编码的多模态文本表示。

- video_clips: 来自情景喜剧和TED的887个视频片段。

- video_segments: 从视频片段中修剪的4482个视频段,按话语分割。

-

SMILE Dataset v.1 for evaluation:

├── SMILE_v1_evaluation ├── smile_reasoning_train.json ├── smile_reasoning_val.json ├── sitcom_reasoning_train.json ├── sitcom_reasoning_val.json ├── ted_reasoning_train.json └── ted_reasoning_val.json

评估

- 笑的推理:

- 提供使用GPT3和LLaMA的推理代码。

- GPT3需要用户自己的openai api密钥,并收取运行模型的费用。

- LLaMA提供预训练权重,仅供研究使用。

引用信息

@inproceedings{hyun-etal-2024-smile, title = "{SMILE}: Multimodal Dataset for Understanding Laughter in Video with Language Models", author = "Hyun, Lee and Sung-Bin, Kim and Han, Seungju and Yu, Youngjae and Oh, Tae-Hyun", booktitle = "Findings of the Association for Computational Linguistics: NAACL 2024", publisher = "Association for Computational Linguistics" }

中国区域交通网络数据集

该数据集包含中国各区域的交通网络信息,包括道路、铁路、航空和水路等多种交通方式的网络结构和连接关系。数据集详细记录了各交通节点的位置、交通线路的类型、长度、容量以及相关的交通流量信息。

data.stats.gov.cn 收录

MeSH

MeSH(医学主题词表)是一个用于索引和检索生物医学文献的标准化词汇表。它包含了大量的医学术语和概念,用于描述医学文献中的主题和内容。MeSH数据集包括主题词、副主题词、树状结构、历史记录等信息,广泛应用于医学文献的分类和检索。

www.nlm.nih.gov 收录

UAVDT Dataset

The authors constructed a new UAVDT Dataset focused on complex scenarios with new level challenges. Selected from 10 hours raw videos, about 80, 000 representative frames are fully annotated with bounding boxes as well as up to 14 kinds of attributes (e.g., weather condition, flying altitude, camera view, vehicle category, and occlusion) for three fundamental computer vision tasks: object detection, single object tracking, and multiple object tracking.

datasetninja.com 收录

OpenSonarDatasets

OpenSonarDatasets是一个致力于整合开放源代码声纳数据集的仓库,旨在为水下研究和开发提供便利。该仓库鼓励研究人员扩展当前的数据集集合,以增加开放源代码声纳数据集的可见性,并提供一个更容易查找和比较数据集的方式。

github 收录

Solar Radiation Data

该数据集包含全球多个地点的太阳辐射数据,涵盖了不同时间段和气象条件下的辐射强度。数据包括直接辐射、散射辐射和总辐射等指标,适用于太阳能资源评估和气候研究。

www.nrel.gov 收录