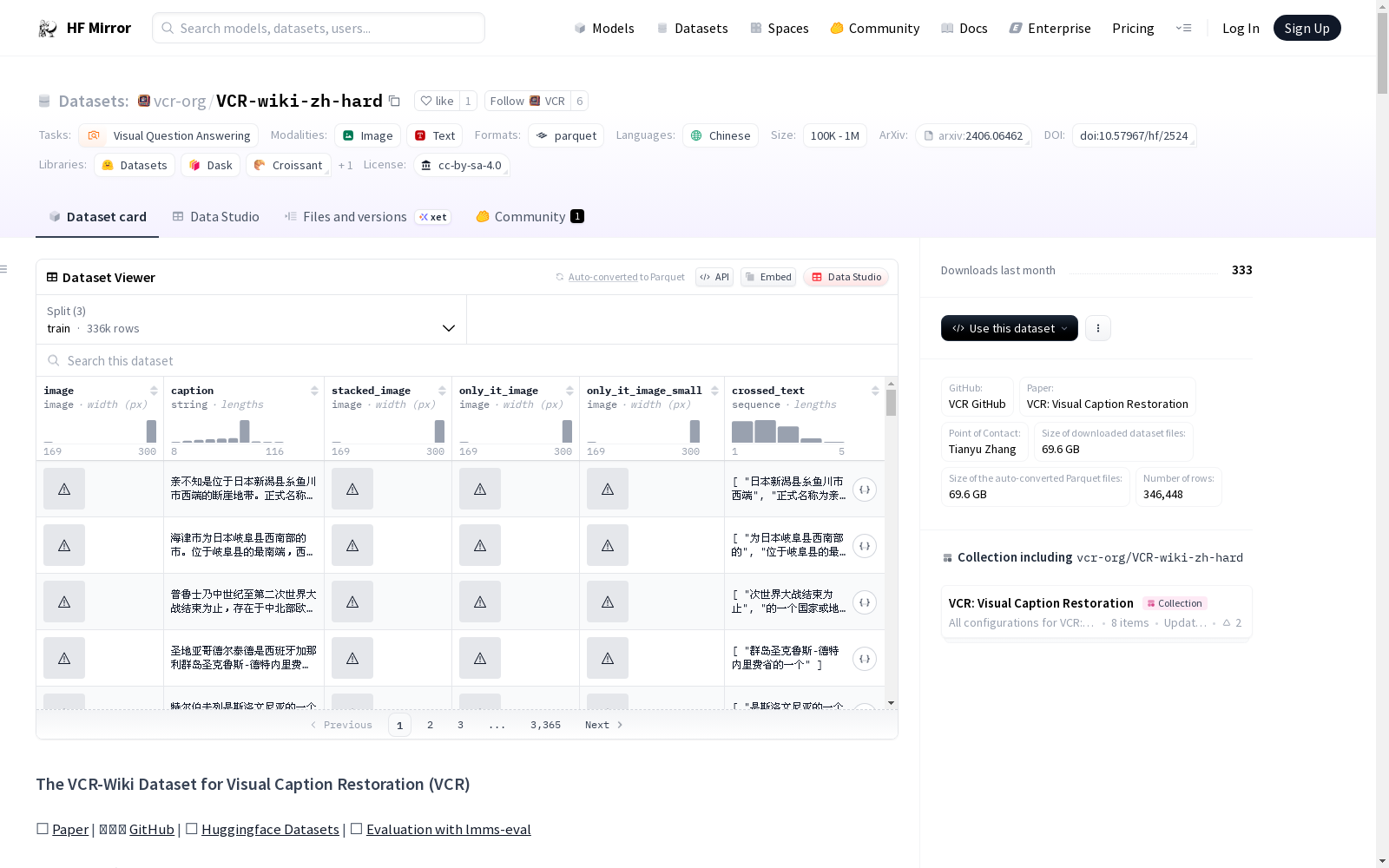

vcr-org/VCR-wiki-zh-hard|视觉问答数据集|图像理解数据集

收藏数据集概述

数据集特征

- image:图像数据类型

- caption:字符串数据类型

- stacked_image:图像数据类型

- only_it_image:图像数据类型

- only_it_image_small:图像数据类型

- crossed_text:字符串序列数据类型

数据集分割

- test:包含5000个示例,总大小为1005851898.7488415字节

- validation:包含5000个示例,总大小为1007605144.261219字节

- train:包含336448个示例,总大小为67801347115.279724字节

数据集大小

- 下载大小:69580595287字节

- 数据集总大小:69814804158.28978字节

数据文件配置

- default配置:

- test:路径为

data/test-* - validation:路径为

data/validation-* - train:路径为

data/train-*

- test:路径为

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录

UniProt

UniProt(Universal Protein Resource)是全球公认的蛋白质序列与功能信息权威数据库,由欧洲生物信息学研究所(EBI)、瑞士生物信息学研究所(SIB)和美国蛋白质信息资源中心(PIR)联合运营。该数据库以其广度和深度兼备的蛋白质信息资源闻名,整合了实验验证的高质量数据与大规模预测的自动注释内容,涵盖从分子序列、结构到功能的全面信息。UniProt核心包括注释详尽的UniProtKB知识库(分为人工校验的Swiss-Prot和自动生成的TrEMBL),以及支持高效序列聚类分析的UniRef和全局蛋白质序列归档的UniParc。其卓越的数据质量和多样化的检索工具,为基础研究和药物研发提供了无可替代的支持,成为生物学研究中不可或缺的资源。

www.uniprot.org 收录

中国逐日格点降水数据集V2(1960–2024,0.1°)

CHM_PRE V2数据集是一套高精度的中国大陆逐日格点降水数据集。该数据集基于1960年至今共3476个观测站的长期日降水观测数据,并纳入11个降水相关变量,用于表征降水的相关性。数据集采用改进的反距离加权方法,并结合基于机器学习的LGBM算法构建。CHM_PRE V2与现有的格点降水数据集(包括CHM_PRE V1、GSMaP、IMERG、PERSIANN-CDR和GLDAS)表现出良好的时空一致性。数据集基于63,397个高密度自动雨量站2015–2019年的观测数据进行验证,发现该数据集显著提高了降水测量精度,降低了降水事件的高估,为水文建模和气候评估提供了可靠的基础。CHM_PRE V2 数据集提供分辨率为0.1°的逐日降水数据,覆盖整个中国大陆(18°N–54°N,72°E–136°E)。该数据集涵盖1960–2024年,并将每年持续更新。日值数据以NetCDF格式提供,为了方便用户,我们还提供NetCDF和GeoTIFF格式的年度和月度总降水数据。

国家青藏高原科学数据中心 收录

DNS-Challenge

深度噪声抑制挑战数据集,包含干净的语音和噪声剪辑,用于训练和评估在有噪声环境下增强语音的模型。

huggingface 收录

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio 收录