M3SCIQA|科学问答数据集|多模态数据数据集

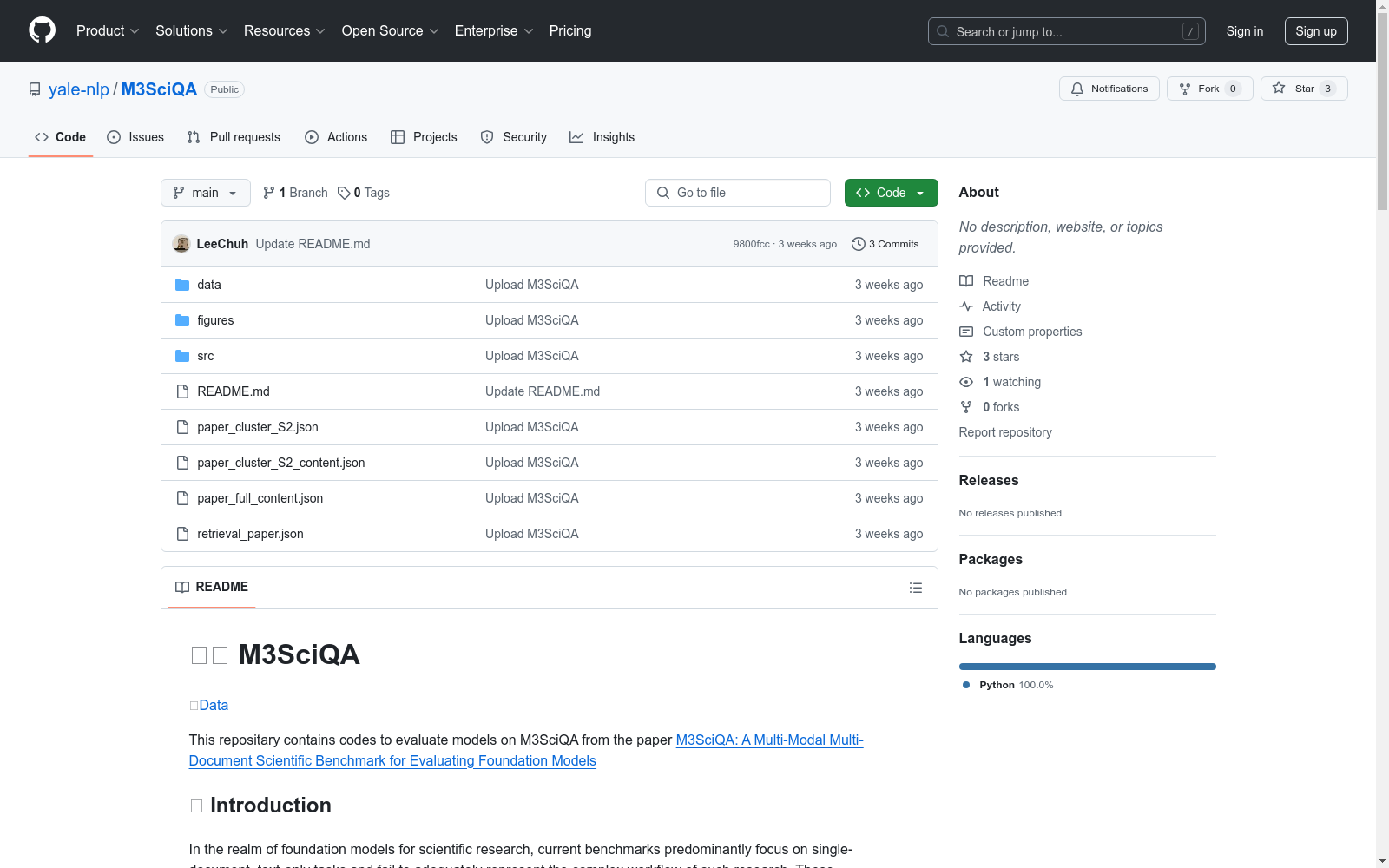

收藏M3SciQA 数据集概述

简介

M3SciQA 是一个多模态、多文档的科学问答基准数据集,旨在更全面地评估基础模型。该数据集包含 1,452 个专家注释的问题,涵盖 70 个自然语言处理(NLP)论文集群。每个集群代表一篇主要论文及其所有引用的文档,模拟了通过多模态和多文档数据理解单篇论文的工作流程。

数据集结构

-

数据文件夹 (

data/):locality.jsonl: 包含特定位置的问题。combined_test.jsonl: 包含组合的测试问题。combined_val.jsonl: 包含组合的验证问题。locality/: 包含用于构成特定位置问题的所有图像。

-

结果文件夹 (

results/):- 包含不同设置下的评估结果。

-

源代码文件夹 (

src/):data_utils.py: 数据处理工具。evaluate_detail.py: 用于评估细节特定问题的响应。evaluate_locality.py: 用于评估位置特定问题的响应。generate_detail.py: 用于生成细节特定问题的响应。generate_locality.py: 用于生成位置特定问题的响应。models_w_vision.py: 包含视觉模型的代码。models_wo_vision.py: 不包含视觉模型的代码。

位置特定问题评估

输出格式

json { "question_anchor": "...", "reference_arxiv_id": "...", "reference_s2_id": "...", "response": "..." }

response字段包含模型的输出排名。

响应生成

例如,评估 GPT-4o 的命令: bash cd src python generate_locality.py --model gpt_4_o

响应评估

例如,计算 GPT-4o 的 MRR、NDCG@3 和 Recall@3 的命令:

bash

python evaluate_locality.py

--result_path ../results/locality_response/gpt_4_o.jsonl

--k 3

细节特定问题评估

输出格式

json { "question": "...", "answer": "...", "response": "...", "reference_reasoning_type": "..." }

响应生成

例如,使用 GPT-4 生成响应的命令: bash cd src python generate_detail.py --model gpt_4 --k 3 --chunk_length 15000

响应评估

例如,评估 GPT-4 生成响应的命令: bash python evaluate_detail.py --result_path ../results/retrieval@3/gpt_4.jsonl

- 1M3SciQA: A Multi-Modal Multi-Document Scientific QA Benchmark for Evaluating Foundation Models耶鲁大学 · 2024年