Leopard-Instruct|多模态数据集|指令微调数据集

收藏huggingface2024-11-08 更新2024-12-12 收录

下载链接:

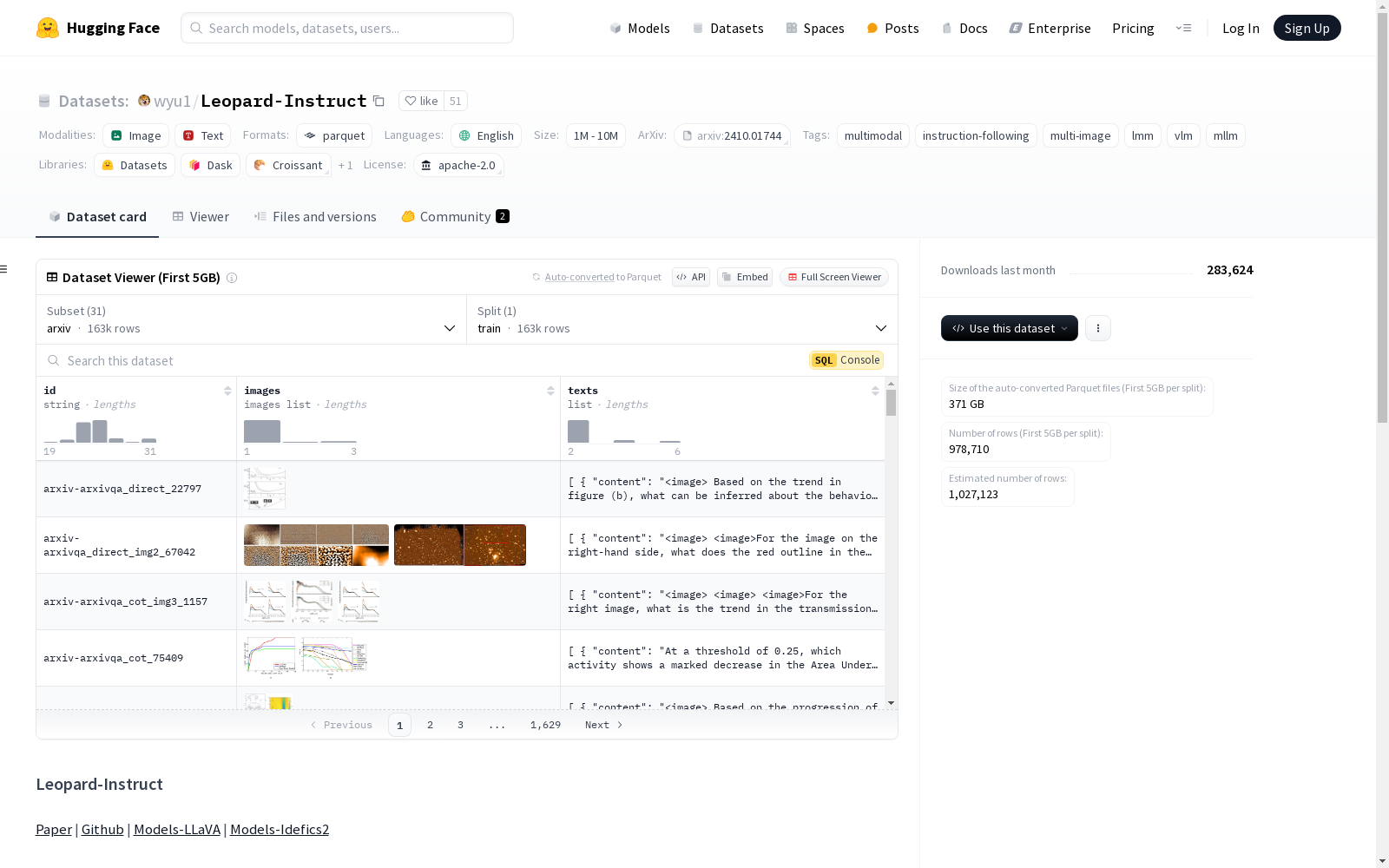

https://huggingface.co/datasets/wyu1/Leopard-Instruct

下载链接

链接失效反馈资源简介:

Leopard-Instruct 是一个大规模指令微调数据集,包含92.5万条实例,其中73.9万条专为文本丰富的多图像场景设计。该数据集已用于训练 Leopard-LLaVA 和 Leopard-Idefics2。

Leopard-Instruct 是一个大规模指令微调数据集,包含92.5万条实例,其中73.9万条专为文本丰富的多图像场景设计。该数据集已用于训练 Leopard-LLaVA 和 Leopard-Idefics2。

创建时间:

2024-11-08

原始信息汇总

Leopard-Instruct 数据集概述

基本信息

- 许可证: Apache 2.0

- 语言: 英语

- 标签:

- multimodal

- instruction-following

- multi-image

- lmm

- vlm

- mllm

- 数据量: 100K<n<1M

数据集配置

- arxiv:

- 分割: train

- 路径: arxiv/*

- chartgemma:

- 分割: train

- 路径: chartgemma/*

- chartqa:

- 分割: train

- 路径: chartqa/*

- dude:

- 分割: train

- 路径: dude/*

- dvqa:

- 分割: train

- 路径: dvqa/*

- figureqa:

- 分割: train

- 路径: figureqa/*

- iconqa:

- 分割: train

- 路径: iconqa/*

- infographics:

- 分割: train

- 路径: infographics/*

- llavar:

- 分割: train

- 路径: llavar/*

- mapqa:

- 分割: train

- 路径: mapqa/*

- mathv360k:

- 分割: train

- 路径: mathv360k/*

- mind2web:

- 分割: train

- 路径: mind2web/*

- monkey:

- 分割: train

- 路径: monkey/*

- mpdocvqa:

- 分割: train

- 路径: mpdocvqa/*

- mplugdocreason:

- 分割: train

- 路径: mplugdocreason/*

- multichartqa:

- 分割: train

- 路径: multi_chartqa/*

- multihiertt:

- 分割: train

- 路径: multihiertt/*

- multitab:

- 分割: train

- 路径: multitab/*

- omniact:

- 分割: train

- 路径: omniact/*

- pew_chart:

- 分割: train

- 路径: pew_chart/*

- rico:

- 分割: train

- 路径: rico/*

- slidesgeneration:

- 分割: train

- 路径: slidesgeneration/*

- slideshare:

- 分割: train

- 路径: slideshare/*

- slidevqa:

- 分割: train

- 路径: slidevqa/*

- docvqa:

- 分割: train

- 路径: spdocvqa/*

- tab_entity:

- 分割: train

- 路径: tab_entity/*

- tabmwp:

- 分割: train

- 路径: tabmwp/*

- tat_dqa:

- 分割: train

- 路径: tat_dqa/*

- website_screenshots:

- 分割: train

- 路径: website_screenshots/*

- webui:

- 分割: train

- 路径: webui/*

- webvision:

- 分割: train

- 路径: webvision/*

数据集概述

- Leopard-Instruct 是一个大规模指令调优数据集,包含925K个实例,其中739K个实例专门设计用于文本丰富的多图像场景。

- 该数据集用于训练 Leopard-LLaVA 和 Leopard-Idefics2 模型。

数据加载

-

加载数据集而不自动下载和处理图像: python import datasets dataset = datasets.load_dataset("wyu1/Leopard-Instruct", "webvision")

-

加载所有子集的图像: python from datasets import get_dataset_config_names, load_dataset config_dataset = {} for config_name in get_dataset_config_names(): config_dataset[config_name] = load_dataset("wyu1/Leopard-Instruct", config_name)

引用

@article{jia2024leopard, title={LEOPARD: A Vision Language Model For Text-Rich Multi-Image Tasks}, author={Jia, Mengzhao and Yu, Wenhao and Ma, Kaixin and Fang, Tianqing and Zhang, Zhihan and Ouyang, Siru and Zhang, Hongming and Jiang, Meng and Yu, Dong}, journal={arXiv preprint arXiv:2410.01744}, year={2024} }

AI搜集汇总

数据集介绍

构建方式

Leopard-Instruct数据集的构建基于多模态指令调优的需求,涵盖了925K个实例,其中739K专门针对文本丰富的多图像场景。数据集通过整合多个子集,如arxiv、chartgemma、chartqa等,确保了数据的多样性和广泛性。每个子集均以训练集的形式存在,路径明确,便于后续的数据加载和处理。

使用方法

使用Leopard-Instruct数据集时,可以通过Hugging Face的datasets库进行加载。用户可以选择加载特定子集,如webvision,或一次性加载所有子集。加载时,可以选择是否自动下载和处理图像,以适应不同的研究需求。通过简单的代码调用,用户可以快速获取数据集中的图像和文本信息,便于后续的模型训练和评估。

背景与挑战

背景概述

Leopard-Instruct数据集由腾讯AI实验室于2024年推出,旨在解决多模态任务中的文本丰富多图像场景问题。该数据集包含925K个实例,其中739K专门用于文本丰富的多图像场景,为训练视觉语言模型(如Leopard-LLaVA和Leopard-Idefics2)提供了重要支持。该数据集的推出标志着在多模态学习领域的一个重要进展,特别是在处理复杂多图像任务时,为模型提供了丰富的训练资源。

当前挑战

Leopard-Instruct数据集面临的挑战主要体现在两个方面。首先,在处理文本丰富的多图像场景时,模型需要具备强大的跨模态理解能力,以准确解析图像中的文本信息并生成相应的指令。其次,在数据集的构建过程中,如何确保数据的多样性和质量是一个关键问题,特别是在多图像场景下,图像之间的关联性和一致性需要精心设计。此外,数据集的规模庞大,如何高效地处理和存储这些数据也是一个技术挑战。

常用场景

经典使用场景

Leopard-Instruct数据集在多模态学习领域具有广泛的应用,尤其是在文本丰富的多图像任务中。该数据集通过提供大量指令调优实例,为视觉语言模型(VLM)和多模态大语言模型(MLLM)的训练提供了坚实的基础。研究人员可以利用该数据集进行多图像推理、文本与图像的联合理解等任务,从而推动多模态学习技术的发展。

解决学术问题

Leopard-Instruct数据集解决了多模态学习中的关键问题,特别是在文本与图像联合理解方面。通过提供丰富的多图像场景和文本指令,该数据集帮助研究人员克服了传统单图像任务中的局限性,提升了模型在处理复杂多模态任务时的性能。这一数据集的出现为多模态学习领域的研究提供了新的方向,推动了视觉语言模型的进一步发展。

实际应用

在实际应用中,Leopard-Instruct数据集被广泛用于开发智能助手、自动化文档处理和视觉问答系统。例如,在智能助手中,该数据集可以帮助模型更好地理解用户指令并生成相应的图像或文本响应。在自动化文档处理中,模型可以利用该数据集进行多图像文档的分析和理解,从而提高处理效率和准确性。这些应用展示了Leopard-Instruct数据集在实际场景中的巨大潜力。

数据集最近研究

最新研究方向

在视觉语言模型领域,Leopard-Instruct数据集以其丰富的多图像文本场景数据,成为当前研究的热点。该数据集包含925K实例,其中739K专门针对文本丰富的多图像场景设计,为训练Leopard-LLaVA和Leopard-Idefics2模型提供了坚实的基础。近年来,随着多模态学习的快速发展,视觉语言模型在处理复杂多图像任务中的表现备受关注。Leopard-Instruct的出现,不仅推动了多图像任务的研究,还为文本与图像结合的深度理解提供了新的可能性。其应用范围涵盖文档理解、图表解析、网页截图分析等多个领域,显著提升了模型在实际场景中的泛化能力和准确性。这一数据集的研究方向,正逐步引领视觉语言模型向更高效、更智能的方向发展。

以上内容由AI搜集并总结生成