垂直领域的数据集及评测基准|垂直领域数据集|评测基准数据集

收藏数据集概述

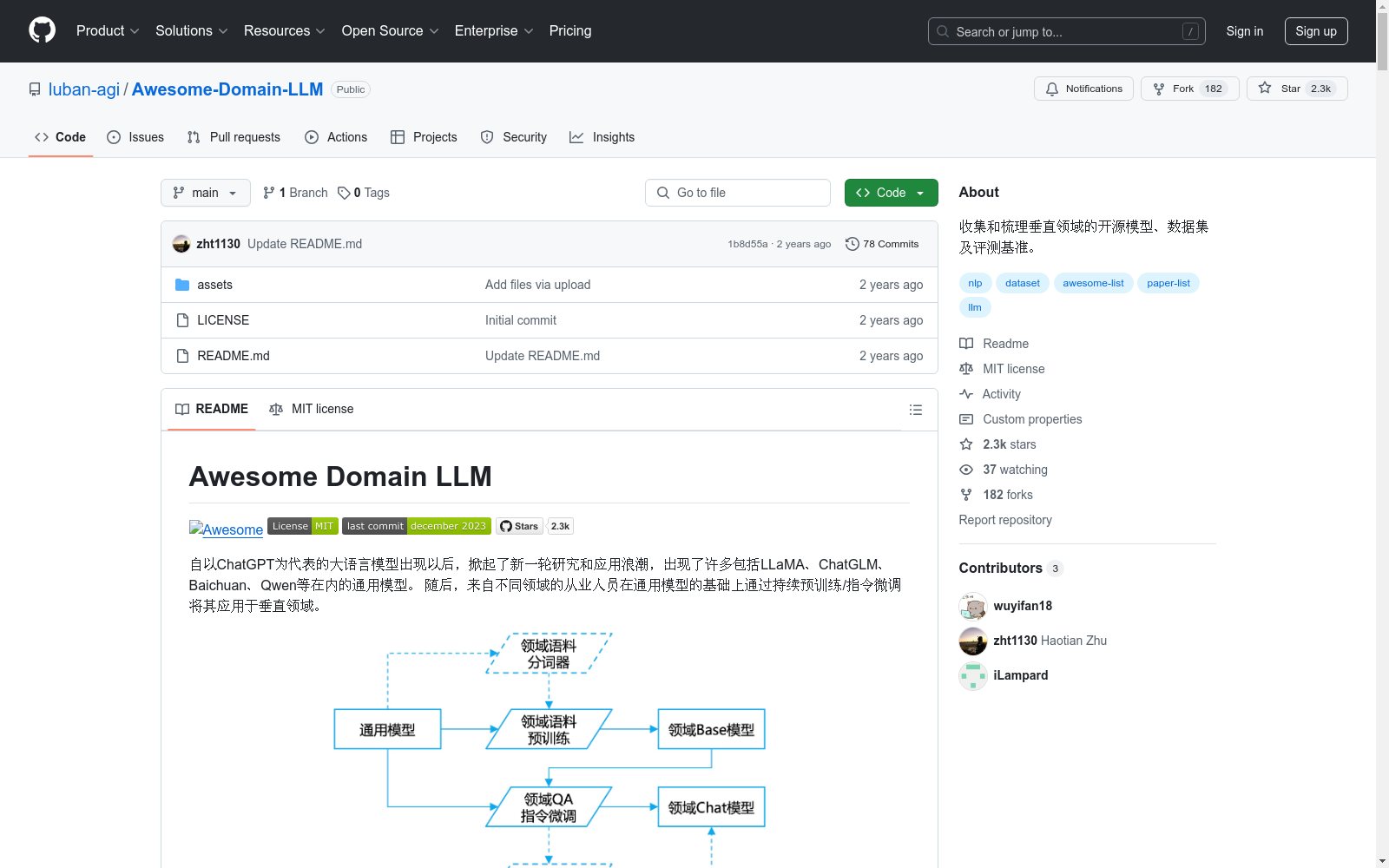

本项目旨在收集和梳理垂直领域的开源模型、数据集及评测基准。以下是数据集相关信息:

📚 数据集

-

医疗领域:

- ChiMed-GPT:基于Ziya-v2的中文医疗大模型。

- AlpaCare:医学大模型,基于LLaMA微调。

- Taiyi (太一):中英双语生物医学大模型。

- MentalLLaMA:心理大模型,用于社交媒体上可解释的心理健康分析。

- WiNGPT2:基于GPT的医疗垂直领域大模型。

- ChatPsychiatrist:心理大模型,基于LLaMA-7B微调。

- Zhongjing-LLaMA (仲景):包含预训练、有监督微调和RLHF完整训练流程的中文医学大模型。

- DoctorGLM:基于ChatGLM-6B的中文问诊模型。

- BenTsao (本草):经过中文医学指令微调的大语言模型集。

- Med-ChatGLM:经过中文医学指令微调的ChatGLM-6B模型。

- BianQue (扁鹊):生活空间健康大模型。

- HuatuoGPT (华佗):医疗大模型,包括HuatuoGPT-7B和HuatuoGPT-13B。

- QiZhenGPT:利用启真医学知识库构建的中文医学指令数据集。

- ChatMed:中文医疗大模型ChatMed-Consult。

- ShenNong-TCM-LLM (神农):中文中医药大模型。

- XrayGLM:中文多模态医学数据集及模型。

- MedicalGPT:医疗大模型,实现了增量预训练、有监督微调、RLHF和DPO。

- Sunsimiao (孙思邈):中文医疗大模型。

- CareGPT:医疗大模型,集合了数十个公开可用的医疗微调数据集和开放可用的医疗大语言模型。

- DISC-MedLLM:针对医疗健康对话式场景而设计的医疗领域大模型与数据集。

- PMC-LLaMA:医疗大模型,包括预训练版本的MedLLaMA_13B和指令微调版本的PMC_LLaMA_13B。

- ChatDoctor:医疗大模型,在LLaMA的基础上训练得到。

- MING (明医):医疗大模型,基于bloomz-7b指令微调得到MING-7B。

- IvyGPT:医疗大模型,在高质量的医学问答数据上进行了监督微调,并使用人类反馈的强化学习进行了训练。

- PULSE:中文医疗大模型,使用约4,000,000个中文医学领域和通用领域的指令微调数据进行微调。

- HuangDI (皇帝):中医大模型,首先在Ziya-LLaMA-13B-V1基座模型的基础上加入中医教材、中医各类网站数据等语料库。

- ZhongJing (仲景):中医大模型,旨在阐明中医博大精深之知识。

- TCMLLM:中医临床辅助诊疗大模型,目前针对中医临床智能诊疗问题中的处方推荐任务,发布了中医处方推荐大模型TCMLLM-PR。

- MeChat:中文心理健康支持对话大模型与数据集。

- SoulChat (灵心):心理健康大模型,以ChatGLM-6B作为初始化模型,经过百万规模心理咨询领域中文长文本指令与多轮共情对话数据联合指令微调得到。

- MindChat (漫谈):心理大模型,采用了经过人工清洗的约20万条的高质量多轮心理对话数据进行训练。

- QiaoBan (巧板):儿童情感对话大模型,基于开源通用大模型,使用通用域人机对话、单轮指令数据以及儿童情感陪伴对话数据进行指令微调。

-

法律领域:

- DISC-LawLLM:旨在为用户提供专业、智能、全面的法律服务的法律领域大模型。

- LawGPT_zh (獬豸):中文法律通用模型,由ChatGLM-6B LoRA 16-bit指令微调得到。

- LaWGPT:系列模型在通用中文基座模型(如Chinese-LLaMA、ChatGLM等)的基础上扩充法律领域专有词表、大规模中文法律语料预训练。

- LexiLaw:经过微调的中文法律大模型,基于ChatGLM-6B架构。

- Lawyer LLaMA:法律领域的指令微调数据和基于LLaMA训练的中文法律大模型。

- HanFei (韩非):全参数训练的法律大模型,参数量7b。

- ChatLaw:一系列法律大模型,包括基于姜子牙-13B、Anima-33B训练而来的ChatLaw-13B和ChatLaw-33B。

- Lychee (律知):中文司法领域大模型Law-GLM-10B。

- wisdomInterrogatory (智海-录问):法律大模型,基于Baichuan-7B进行了法律领域数据的二次预训练与指令微调。

- JurisLMs:基于中文法学语料训练了一系列语言模型。

- 夫子•明察:司法大模型,以 ChatGLM 为大模型底座,基于海量中文无监督司法语料与有监督司法微调数据训练。

-

金融领域:

- Tongyi-Finance-14B:针对金融行业推出的大语言模型。

- DISC-FinLLM:金融领域的大语言模型,由面向不同金融场景的4个模组构成的多专家智慧金融系统。

- InvestLM:基于LLaMA-65B微调得到的英文金融大模型。

- FinGLM:致力于构建一个开放的、公益的、持久的金融大模型项目。

- WeaverBird (织工鸟):金融领域对话大模型,可接入本地知识库以及网络搜索引擎。

- BBT-FinCUGE-Applications:中文金融领域语料库BBT-FinCorpus,知识增强型大模型BBT-FinT5及评测基准CFLEB。

- Cornucopia (聚宝盆):基于公开和爬取的中文金融领域问答数据构建指令数据集。

- XuanYuan (轩辕):国内首个开源的千亿级中文对话大模型,同时也是首个针对中文金融领域优化的千亿级开源对话大模型。

- PIXIU (貔貅):金融领域指令微调数据集FIT,大模型FinMA及评测基准FLARE。

- FinGPT:多个金融大模型,包括ChatGLM2-6B+LoRA和LLaMA2-7B+LoRA等。

- FLANG:金融大模型FLANG和评测基准FLUE。

-

教育领域:

- 桃李 (Taoli):适用于国际中文教育领域的大模型,基于目前国际中文教育领域流通的500余册国际中文教育教材与教辅书、汉语水平考试试题以及汉语学习者词典等。

- EduChat:教育领域的大模型,基于目前国际中文教育领域流通的500余册国际中文教育教材与教辅书、汉语水平考试试题以及汉语学习者词典等。

以上数据集和模型涵盖了医疗、法律、金融和教育等多个垂直领域,旨在推动大模型在各行各业的应用。

中国农村金融统计数据

该数据集包含了中国农村金融的统计信息,涵盖了农村金融机构的数量、贷款余额、存款余额、金融服务覆盖率等关键指标。数据按年度和地区分类,提供了详细的农村金融发展状况。

www.pbc.gov.cn 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

中国区域地面气象要素驱动数据集 v2.0(1951-2020)

中国区域地面气象要素驱动数据集(China Meteorological Forcing Data,以下简称 CMFD)是为支撑中国区域陆面、水文、生态等领域研究而研发的一套高精度、高分辨率、长时间序列数据产品。本页面发布的 CMFD 2.0 包含了近地面气温、气压、比湿、全风速、向下短波辐射通量、向下长波辐射通量、降水率等气象要素,时间分辨率为 3 小时,水平空间分辨率为 0.1°,时间长度为 70 年(1951~2020 年),覆盖了 70°E~140°E,15°N~55°N 空间范围内的陆地区域。CMFD 2.0 融合了欧洲中期天气预报中心 ERA5 再分析数据与气象台站观测数据,并在辐射、降水数据产品中集成了采用人工智能技术制作的 ISCCP-ITP-CNN 和 TPHiPr 数据产品,其数据精度较 CMFD 的上一代产品有显著提升。 CMFD 历经十余年的发展,其间发布了多个重要版本。2019 年发布的 CMFD 1.6 是完全采用传统数据融合技术制作的最后一个 CMFD 版本,而本次发布的 CMFD 2.0 则是 CMFD 转向人工智能技术制作的首个版本。此版本与 1.6 版具有相同的时空分辨率和基础变量集,但在其它诸多方面存在大幅改进。除集成了采用人工智能技术制作的辐射和降水数据外,在制作 CMFD 2.0 的过程中,研发团队尽可能采用单一来源的再分析数据作为输入并引入气象台站迁址信息,显著缓解了 CMFD 1.6 中因多源数据拼接和气象台站迁址而产生的虚假气候突变。同时,CMFD 2.0 数据的时间长度从 CMFD 1.6 的 40 年大幅扩展到了 70 年,并将继续向后延伸。CMFD 2.0 的网格空间范围虽然与 CMFD 1.6 相同,但其有效数据扩展到了中国之外,能够更好地支持跨境区域研究。为方便用户使用,CMFD 2.0 还在基础变量集之外提供了若干衍生变量,包括近地面相对湿度、雨雪分离降水产品等。此外,CMFD 2.0 摒弃了 CMFD 1.6 中通过 scale_factor 和 add_offset 参数将实型数据化为整型数据的压缩技术,转而直接将实型数据压缩存储于 NetCDF4 格式文件中,从而消除了用户使用数据时进行解压换算的困扰。 本数据集原定版本号为 1.7,但鉴于本数据集从输入数据到研制技术都较上一代数据产品有了大幅的改变,故将其版本号重新定义为 2.0。CMFD 2.0 的数据内容与此前宣传的 CMFD 1.7 基本一致,仅对 1983 年 7 月以后的向下短/长波辐射通量数据进行了更新,以修正其长期趋势存在的问题。2021 年至 2024 年的 CMFD 数据正在制作中,计划于 2025 年上半年发布,从而使 CMFD 2.0 延伸至 2024 年底。

国家青藏高原科学数据中心 收录

中国逐日降水数据集(1961-2022,0.1°/0.25°/0.5°)

CHM_PRE数据集基于中国境内及周边1961至今共2839个站点的日降水观测,在传统的“降水背景场 + 降水比值场”的数据集构建思路上,尝试应用月值降水约束和地形特征校正,并依据中国范围内约4万个高密度站点2015–2019年的日降水量插值后数据进行精度评价。经评估认为,CHM_PRE可以较好的表征降水的空间变异性,其日值时间序列与高密度站点日值降水观测结果之间的相关系数中位数为0.78,均方根误差中位数为8.8 mm/d,KGE值中位数为0.69,与目前常用的降水数据集(CGDPA、CN05.1、CMA V2.0)有很好的一致性。 数据集的时间范围为1961年至今,空间分辨率为0.1°、0.25°和0.5°,经纬度范围为18°N–54°N, 72°E–136°E。

国家青藏高原科学数据中心 收录

AISHELL/AISHELL-1

Aishell是一个开源的中文普通话语音语料库,由北京壳壳科技有限公司发布。数据集包含了来自中国不同口音地区的400人的录音,录音在安静的室内环境中使用高保真麦克风进行,并下采样至16kHz。通过专业的语音标注和严格的质量检查,手动转录的准确率超过95%。该数据集免费供学术使用,旨在为语音识别领域的新研究人员提供适量的数据。

hugging_face 收录