laion/OIG|自然语言处理数据集|机器学习数据集

收藏Open Instruction Generalist Dataset 概述

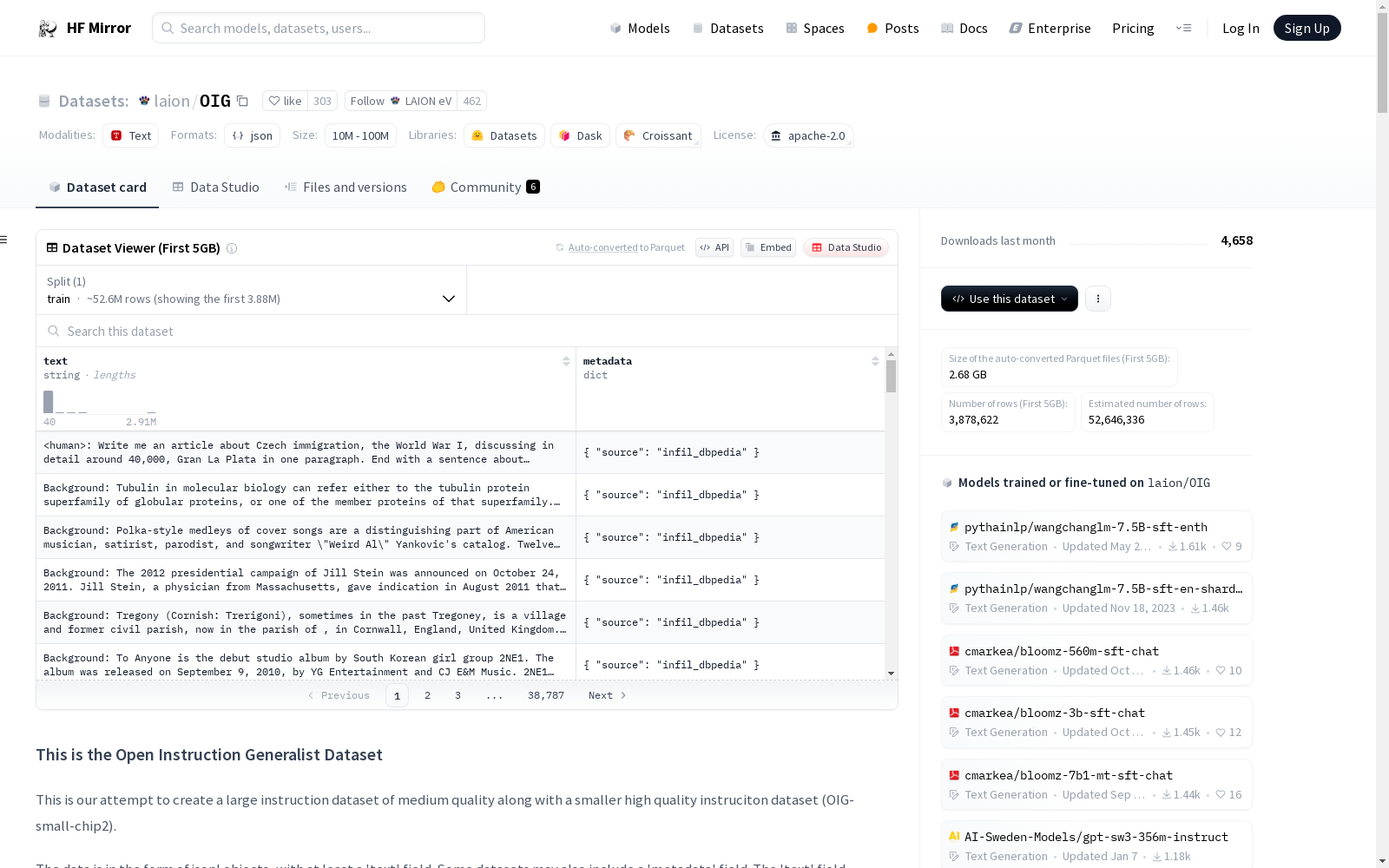

数据集描述

- 名称: Open Instruction Generalist Dataset

- 目的: 创建一个中等质量的大规模指令数据集,以及一个高质量的小型指令数据集(OIG-small-chip2)。

- 数据格式: JSONL 对象,包含至少一个 text 字段,部分数据集可能包含 metadata 字段。

- 数据内容示例:

- <human>: instruction <bot>: response

- <human>: instruction <bot>: response .. <human>: instruction <bot>: response

数据集组成部分

主要数据集

- unified_abstract_infill.jsonl: 约232000条记录,包含dbpedia和wikipedia片段及少量来自https://github.com/google-research/dialog-inpainting的数据。

- unified_basic.jsonl: 30条记录。

- unified_conv_finqa.jsonl: 约9000条记录,来自https://github.com/czyssrs/ConvFinQA。

- unified_cuad.jsonl: 约500条记录,来自https://www.atticusprojectai.org/cuad。

- unified_essays.jsonl: 约2000条记录,来自公开网络的论文。

- unified_grade_school_math_instructions.jsonl: 约9000条记录,来自https://github.com/openai/grade-school-math。

- unified_hc3_human.jsonl: 约58000条记录。

- unified_image_prompts_instructions.jsonl: 约15000条记录,来自LAION-400M的一个小部分。

- unified_joke_explanations.jsonl: 356条记录,从公开互联网爬取。

- unified_mathqa_flanv2_kojma_cot.jsonl: 约107000条记录,来自https://huggingface.co/datasets/math_qa。

- unified_merged_code_xp3.jsonl: 约67000条记录,来自https://huggingface.co/datasets/bigscience/xP3。

- unified_multi_news.jsonl: 约90000条记录,来自https://www.tensorflow.org/datasets/catalog/multi_news。

- unified_multi_sum.jsonl: 约1700000条记录。

- unified_nq.jsonl: 约307000条记录。

- unified_openai_summarize_tldr.jsonl: 约233000条记录,来自https://github.com/openai/summarize-from-feedback。

- unified_oscar_en_sample_dialog.jsonl: 约2670000条记录,来自https://oscar-project.org/和https://huggingface.co/datasets/TurkuNLP/register_oscar。

- unified_plot_screenplay_books_dialog.jsonl: 约8000条记录,来自https://github.com/markriedl/WikiPlots和https://huggingface.co/datasets/the_pile_books3。

- unified_sqlv1.jsonl: 约17000条记录,来自公共text2sql数据集。

- unified_sqlv2.jsonl: 约24000条记录,来自公共text2sql数据集。

- unified_squad_v2.jsonl: 约19000条记录,来自https://rajpurkar.github.io/SQuAD-explorer/。

- unified_squad_v2_more_neg.jsonl: 约19000条记录,来自https://rajpurkar.github.io/SQuAD-explorer/。

- unified_ul2_plus_oscar_en_sample_dialog.jsonl: 约2900000条记录,来自https://oscar-project.org/和https://huggingface.co/datasets/TurkuNLP/register_oscar。

- unified_unifiedskg_instructions.jsonl: 约223000条记录,来自https://github.com/HKUNLP/UnifiedSKG。

- unified_unnatural_instructions.jsonl: 约238000条记录,来自https://github.com/orhonovich/unnatural-instructions。

- unified_xp3_sample.jsonl: 约188000条记录,来自https://huggingface.co/datasets/bigscience/xP3。

- unified_canadian_parliament.jsonl: 约301000条记录,来自https://openparliament.ca/data-download/。

- unified_poetry_2_song.jsonl: 约12000条记录,来自https://huggingface.co/datasets/merve/poetry和https://huggingface.co/datasets/matthh/gutenberg-poetry-corpus。

- unified_flan.jsonl: 约2700000条记录,来自https://github.com/google-research/FLAN/tree/main/flan/v2。

- unified_ni.jsonl: 约256000条记录,来自https://github.com/allenai/natural-instructions。

- unified_p3.jsonl: 约31000000条记录,来自https://huggingface.co/datasets/bigscience/P3。

- unified_soda_dialog.jsonl: 约1200000条记录,来自https://huggingface.co/datasets/allenai/soda。

- unified_rallio_soda_upgraded_2048.jsonl: 约210000条记录,来自https://huggingface.co/datasets/allenai/soda,是unified_soda_dialog数据集的新版本。

- unified_rallio_safety_and_prosocial.jsonl: 约319000条记录,来自公开数据集和Wiki,包含https://huggingface.co/datasets/allenai/prosocial-dialog和https://huggingface.co/datasets/Anthropic/hh-rlhf。

OIG-small-chip2 数据集

- 目的: 用于将预训练的大型语言模型转换为遵循指令的模型,通过微调或软提示调整。

- 内容:

- Python Code Examples: 约6000条记录,包含用户请求代理生成Python函数的指令/响应对。

- Natural Instruction Examples: 约124000条记录,包含多样化的自然和事实问题及答案。

- Generic Harmless Instruction Examples: 约6500条记录,来自Anthropic redteam paper github。

- Instruction/Responses with Lists: 约14000条记录,包含响应中包含列表的指令/响应对。

- Follow-up questions: 约12500条记录,包含适当的响应是请求更多信息的指令和响应。

- Wikipedia Toxic Adversarial Questions: 约12000条记录,来自讨论潜在敏感话题的Wikipedia文章。

- Grade School Math GSM8K: 约9000条记录,来自https://github.com/openai/grade-school-math。

- Reasoning Instructions: 约4500条记录,来自Com2Sense和Strategy QA数据集。

- Character and Scene Descriptions: 约30000条记录,包含生成角色或场景描述的指令和响应。

数据集使用建议

- 建议直接下载所需的单个jsonl文件,而不是使用HF load_datasets。

许可证

- 数据集由LAION志愿者编写,根据Apache 2.0许可证发布。数据集还包括其他许可内容,如Wikipedia数据和网络爬虫数据。

Materials Project 在线材料数据库

Materials Project 是一个由伯克利加州大学和劳伦斯伯克利国家实验室于 2011 年共同发起的大型开放式在线材料数据库。这个项目的目标是利用高通量第一性原理计算,为超过百万种无机材料提供全面的性能数据、结构信息和计算模拟结果,以此加速新材料的发现和创新过程。数据库中的数据不仅包括晶体结构和能量特性,还涵盖了电子结构和热力学性质等详尽信息,为研究人员提供了丰富的材料数据资源。相关论文成果为「Commentary: The Materials Project: A materials genome approach to accelerating materials innovation」。

超神经 收录

Tropicos

Tropicos是一个全球植物名称数据库,包含超过130万种植物的名称、分类信息、分布数据、图像和参考文献。该数据库由密苏里植物园维护,旨在为植物学家、生态学家和相关领域的研究人员提供全面的植物信息。

www.tropicos.org 收录

Apple Stock Price Data

Historical stock price data for AAPL (apple)

kaggle 收录

专精特新“小巨人”合肥企业名单(第一批~第四批)

根据工信部的定义,专精特新“小巨人”企业是“专精特新”中小企业中的佼佼者,是专注于细分市场、创新能力强、市场占有率高、掌握关键核心技术、质量效益优的排头兵企业。 截止第四批,目前,全市“小巨人”企业总数达140户,占全国的1.6%,在全国城市及省会城市排名各进一位,位居全国城市第十四,省会城市第五。 2022 年 6 月,合肥市发布《专精特新中小企业倍增培育行动计划》,到2025年,合肥计划培育省级专精特新冠军企业和国家级专精特新“小巨人”企业300家,推动50家专精特新中小企业上市挂牌。接下来,合肥还将支持地方国有金融机构设立专精特新专项融资产品,力争每条产业链培育一批国家级专精特新“小巨人”企业。

合肥数据要素流通平台 收录

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录