stanfordnlp/SHP|机器学习数据集|数据集难度评估数据集

收藏数据集概述

数据集名称

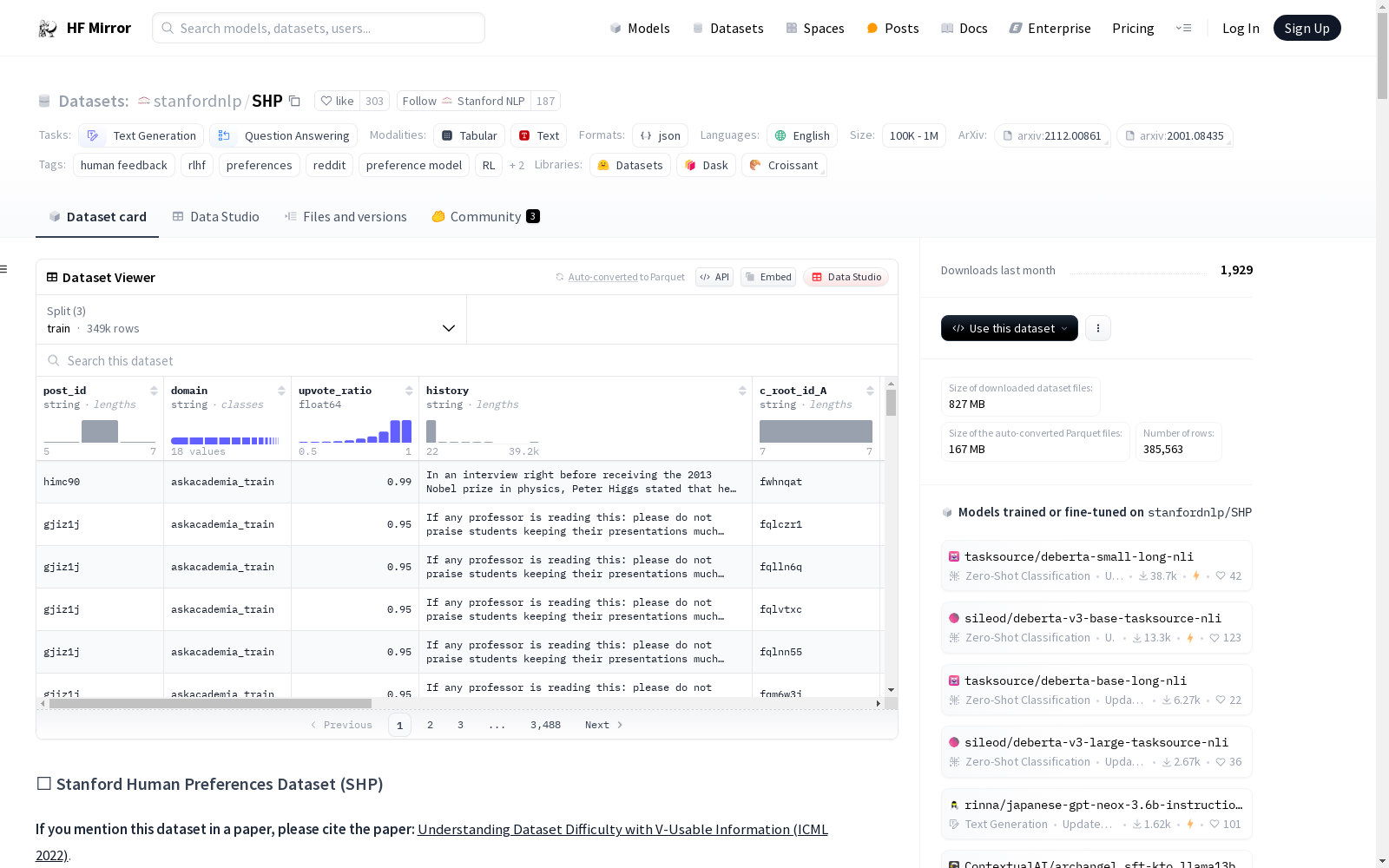

Stanford Human Preferences Dataset (SHP)

数据集大小

385K 条数据

数据集任务类别

- 文本生成

- 问答

数据集标签

- 人类反馈

- RLHF

- 偏好

- 偏好模型

- RL

- NLG

- 评估

数据集语言

英语

数据集内容

SHP 包含 385K 条人类对回答问题/指令的偏好数据,涵盖 18 个不同领域,如烹饪、法律咨询等。每个示例包含一个 Reddit 帖子,一个问题/指令以及该帖子的两个顶级评论,其中一个评论被 Reddit 用户集体更偏好。

数据集结构

数据集分为 18 个目录,每个目录代表一个子论坛,每个目录包含用于训练、验证和测试的 JSONL 文件。

数据集用途

用于训练 RLHF 奖励模型和 NLG 评估模型。

数据集与其他数据集的区别

- 与 Anthropics HH-RLHF 数据集相比,SHP 的数据均为自然发生和人类编写,而 HH-RLHF 的回答是机器编写。

- 与 ELI5 数据集相比,SHP 使用时间戳信息推断偏好,而 ELI5 仅提供评论和分数。

数据集预处理

预处理保持最小化,包括扩展子论坛特定缩写和移除超链接中的 URL。

构建偏好模型

建议使用大型模型进行微调,如 FLAN-T5-xl,以预测人类偏好,并建议根据 score_ratio 报告性能曲线。

数据集限制

- SHP 不用于伤害最小化,不包含学习毒性检测所需的毒性内容。

- 更偏好的响应不一定更事实准确。

数据集许可证

根据 Reddit API 使用条款进行数据抓取,用户内容所有权归用户所有,Reddit 授予非独占、不可转让、不可再授权和可撤销的许可。

数据集联系信息

联系邮箱:kawin@stanford.edu

数据集创建者

Kawin Ethayarajh, Heidi (Chenyu) Zhang, Yizhong Wang, Dan Jurafsky

flames-and-smoke-datasets

该仓库总结了多个公开的火焰和烟雾数据集,包括DFS、D-Fire dataset、FASDD、FLAME、BoWFire、VisiFire、fire-smoke-detect-yolov4、Forest Fire等数据集。每个数据集都有详细的描述,包括数据来源、图像数量、标注信息等。

github 收录

Paper III (Walker et al. 2024)

Data products used in 3-D CMZ Paper III, Walker et al. (2024). The full cloud catalogue is provided in tabular format, along with a full CMZ map showing the clouds and their assigned IDs. For each cloud ID in the published catalogue there are: - Individual cube cutouts from the MOPRA 3mm CMZ survey (HC3N, HCN, and HNCO). - Individual cube cutouts from the APEX 1mm CMZ survey (13CO, C18O, and H2CO). - Cloud-averaged spectra of the ATCA H2CO 4.83 GHz line. - PV slices of the ATCA H2CO 4.83 GHz line, taken across the major axis of the source. - Where applicable, there are mask files which correspond to the different velocity components of the cloud. In these cases, there are two mask files per velocity component, corresponding to the different masking approaches described in the paper.

DataCite Commons 收录

MeSH

MeSH(医学主题词表)是一个用于索引和检索生物医学文献的标准化词汇表。它包含了大量的医学术语和概念,用于描述医学文献中的主题和内容。MeSH数据集包括主题词、副主题词、树状结构、历史记录等信息,广泛应用于医学文献的分类和检索。

www.nlm.nih.gov 收录

AIS数据集

该研究使用了多个公开的AIS数据集,这些数据集经过过滤、清理和统计分析。数据集涵盖了多种类型的船舶,并提供了关于船舶位置、速度和航向的关键信息。数据集包括来自19,185艘船舶的AIS消息,总计约6.4亿条记录。

github 收录

ShapeNet

ShapeNet 是由斯坦福大学、普林斯顿大学和美国芝加哥丰田技术研究所的研究人员开发的大型 3D CAD 模型存储库。该存储库包含超过 3 亿个模型,其中 220,000 个模型被分类为使用 WordNet 上位词-下位词关系排列的 3,135 个类。 ShapeNet Parts 子集包含 31,693 个网格,分为 16 个常见对象类(即桌子、椅子、平面等)。每个形状基本事实包含 2-5 个部分(总共 50 个部分类)。

OpenDataLab 收录