LongBench|自然语言处理数据集|模型评估数据集

收藏

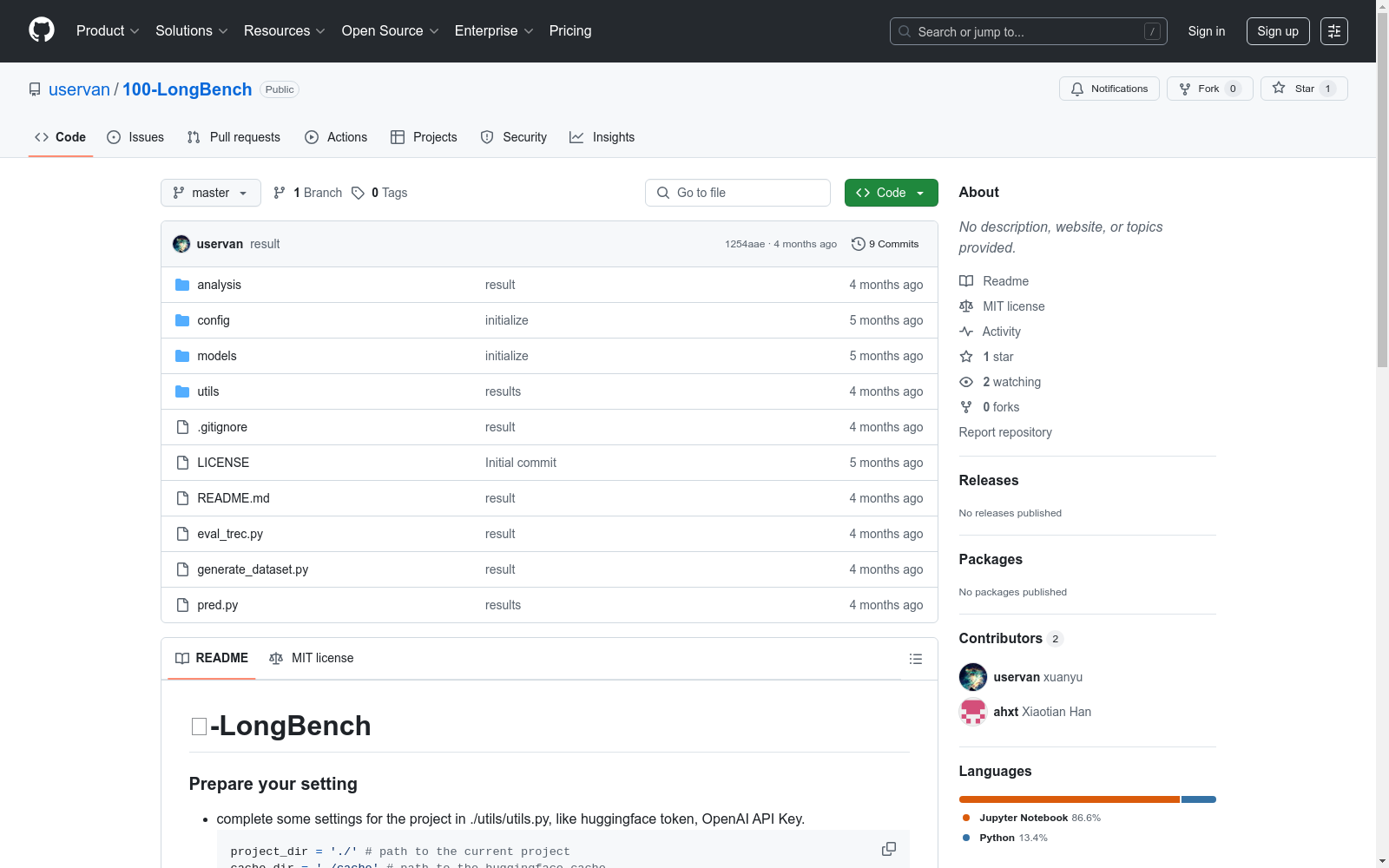

- 1100-LongBench: Are de facto Long-Context Benchmarks Literally Evaluating Long-Context Ability?Case Western Reserve University, Texas A&M University, Rice University, Meta · 2025年

中国行政区划数据

本项目为中国行政区划数据,包括省级、地级、县级、乡级和村级五级行政区划数据。数据来源于国家统计局,存储格式为sqlite3 db文件,支持直接使用数据库连接工具打开。

github 收录

alpacaGPT4_llama8b-v120-jb-seed2-alpaca_512_ngt0.7_tp0.9

该数据集包含了用户和助手之间的对话,具有用户和助手发言的文本特征,以及一个索引级别特征。数据集分为训练集,共有52001条对话记录。

huggingface 收录

OpenPose

OpenPose数据集包含人体姿态估计的相关数据,主要用于训练和评估人体姿态检测算法。数据集包括多视角的图像和视频,标注了人体关键点位置,适用于研究人体姿态识别和动作分析。

github.com 收录

ActivityNet Captions

The ActivityNet Captions dataset is built on ActivityNet v1.3 which includes 20k YouTube untrimmed videos with 100k caption annotations. The videos are 120 seconds long on average. Most of the videos contain over 3 annotated events with corresponding start/end time and human-written sentences, which contain 13.5 words on average. The number of videos in train/validation/test split is 10024/4926/5044, respectively.

Papers with Code 收录

OpenSonarDatasets

OpenSonarDatasets是一个致力于整合开放源代码声纳数据集的仓库,旨在为水下研究和开发提供便利。该仓库鼓励研究人员扩展当前的数据集集合,以增加开放源代码声纳数据集的可见性,并提供一个更容易查找和比较数据集的方式。

github 收录