ScanNet|三维视觉数据集|室内场景重建数据集

收藏TSP3D 数据集概述

数据集简介

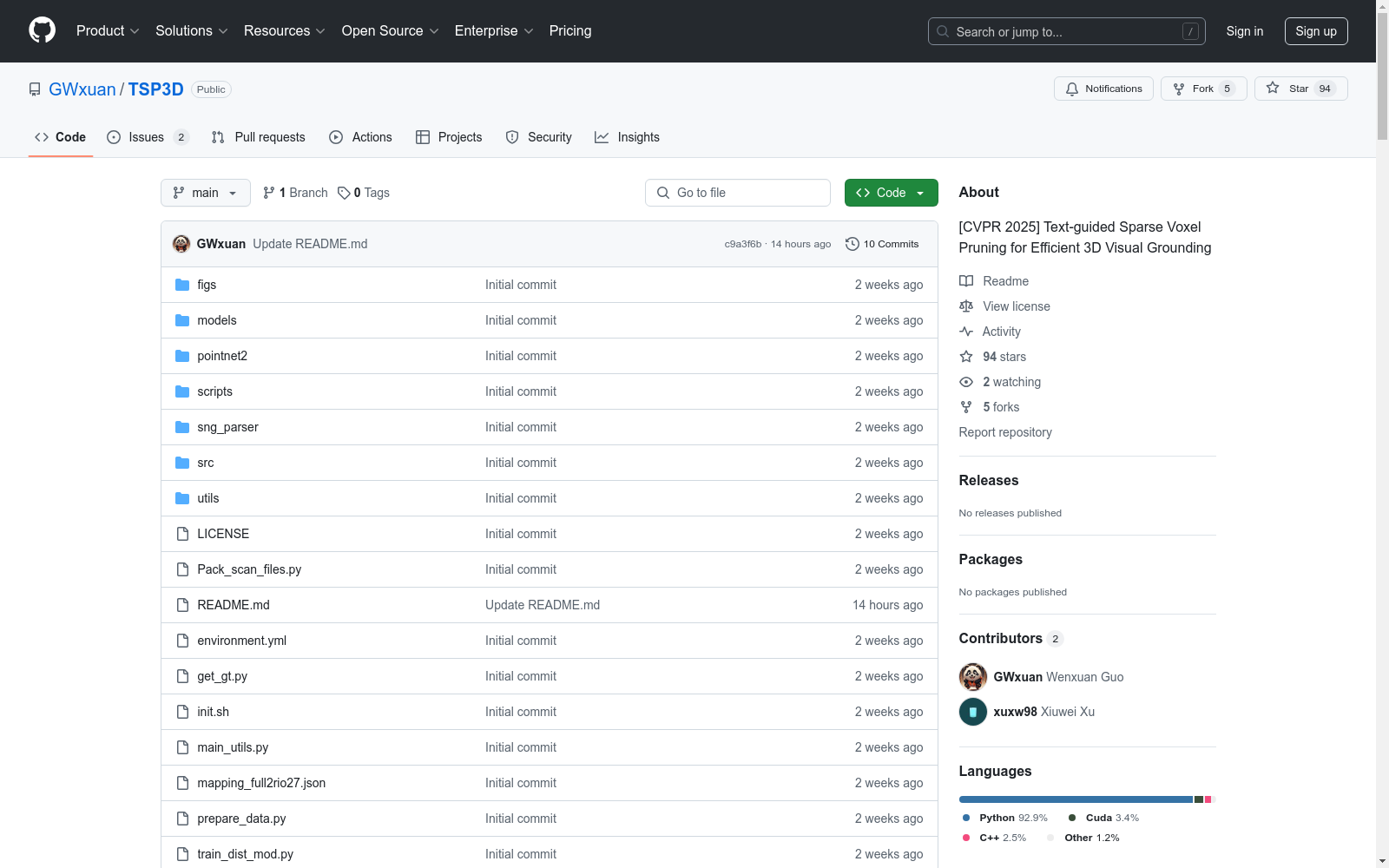

TSP3D(Text-guided Sparse Voxel Pruning for Efficient 3D Visual Grounding)是一个用于3D视觉定位的官方PyTorch实现,对应论文《Text-guided Sparse Voxel Pruning for Efficient 3D Visual Grounding》。

作者信息

- Wenxuan Guo

- Xiuwei Xu

- Ziwei Wang

- Jianjiang Feng

- Jie Zhou

- Jiwen Lu

方法简介

TSP3D提出了一种高效的分层卷积架构,用于3D视觉定位,相比之前的 approaches,在推理速度和准确性上都有显著提升。

数据准备

- ScanNet:需要下载并打包成

train_v3scans.pkl和val_v3scans.pkl。 - ScanRefer:需要下载并解压到指定目录。

- ReferIt3D:需要下载并解压到指定目录。

- roberta-base:下载预训练语言模型。

数据结构

├── [DATA_ROOT] │ ├── [1] train_v3scans.pkl │ ├── [2] val_v3scans.pkl │ ├── [3] ScanRefer/ │ │ ├── ScanRefer_filtered_train.json │ │ ├── ScanRefer_filtered_val.json │ │ └── ... │ ├── [4] ReferIt3D/ │ │ ├── nr3d.csv │ │ ├── sr3d.csv │ │ └── ... │ ├── [5] roberta-base/ │ └── [6] checkpoints/

主要结果

- ScanRefer数据集上的结果:

- 单阶段:Acc@0.25 = 56.45, Acc@0.5 = 46.71, 推理速度(FPS)= 12.43

- Nr3d和Sr3d数据集上的结果也提供了相应的指标。

引用

@article{guo2025tsp3d, title={Text-guided Sparse Voxel Pruning for Efficient 3D Visual Grounding}, author={Wenxuan Guo and Xiuwei Xu and Ziwei Wang and Jianjiang Feng and Jie Zhou and Jiwen Lu}, journal={arXiv preprint arXiv:2502.10392}, year={2025} }

stanford_cars

该数据集是一个包含多个汽车品牌和型号的图片数据集,每个图片样本都标记有相应的汽车品牌和型号信息。数据集适用于图像识别和分类任务,特别是汽车品牌和型号的识别。

huggingface 收录

中国近海地形数据集(渤海,黄海,东海,南海)

本数据集包含历年来通过收集和实测方法取得的中国近海水深点数据、地形图数据(ArcGIS格式),以及黄河口、莱州湾东部、辽东湾、山东南部沿海、南海部分海域的单波束、多波束水深测量数据,包括大尺度的低密度水深数据与局部高密度水深数据。

地球大数据科学工程 收录

OpenSonarDatasets

OpenSonarDatasets是一个致力于整合开放源代码声纳数据集的仓库,旨在为水下研究和开发提供便利。该仓库鼓励研究人员扩展当前的数据集集合,以增加开放源代码声纳数据集的可见性,并提供一个更容易查找和比较数据集的方式。

github 收录

CODrone

CODrone 是一个为无人机设计的全面定向目标检测数据集,它准确反映了真实世界条件。该数据集包含来自多个城市在不同光照条件下的广泛标注图像,增强了基准的逼真度。CODrone 包含超过 10,000 张高分辨率图像,捕获自五个城市的真实无人机飞行,涵盖了各种城市和工业环境,包括港口和码头。为了提高鲁棒性和泛化能力,它包括在正常光线、低光和夜间条件下相同场景的图像。我们采用了三种飞行高度和两种常用的相机角度,从而产生了六个不同的视角配置。所有图像都针对 12 个常见对象类别进行了定向边界框标注,总计超过 590,000 个标记实例。总体而言,这项工作构建了一个综合数据集和基准,用于城市无人机场景中的定向目标检测,旨在满足该领域的研究和实践应用需求。

arXiv 收录

M4-SAR

M4-SAR是一个多分辨率、多极化、多场景、多源数据集,用于光学与合成孔径雷达(SAR)融合的目标检测。该数据集由南京理工大学PCA实验室、安徽大学ICSP教育部重点实验室和南开大学计算机科学学院共同构建,包含112,184对精确对齐的图像和近一百万个标注实例。数据集覆盖六个关键类别,并使用公开的光学和SAR数据,包括Sentinel-1和Sentinel-2卫星提供的数据。为了克服SAR标注的挑战,该研究提出了一种半监督的光学辅助标注策略,利用光学图像的语义丰富性来显著提高标注质量。M4-SAR数据集旨在解决现有光学和SAR数据集的局限性,为多源融合目标检测任务提供大规模、高质量、标准化的数据集,并推动相关研究的发展。

arXiv 收录