LLM360/CrystalCoderDatasets|预训练数据集数据集|代码生成数据集

收藏数据集描述

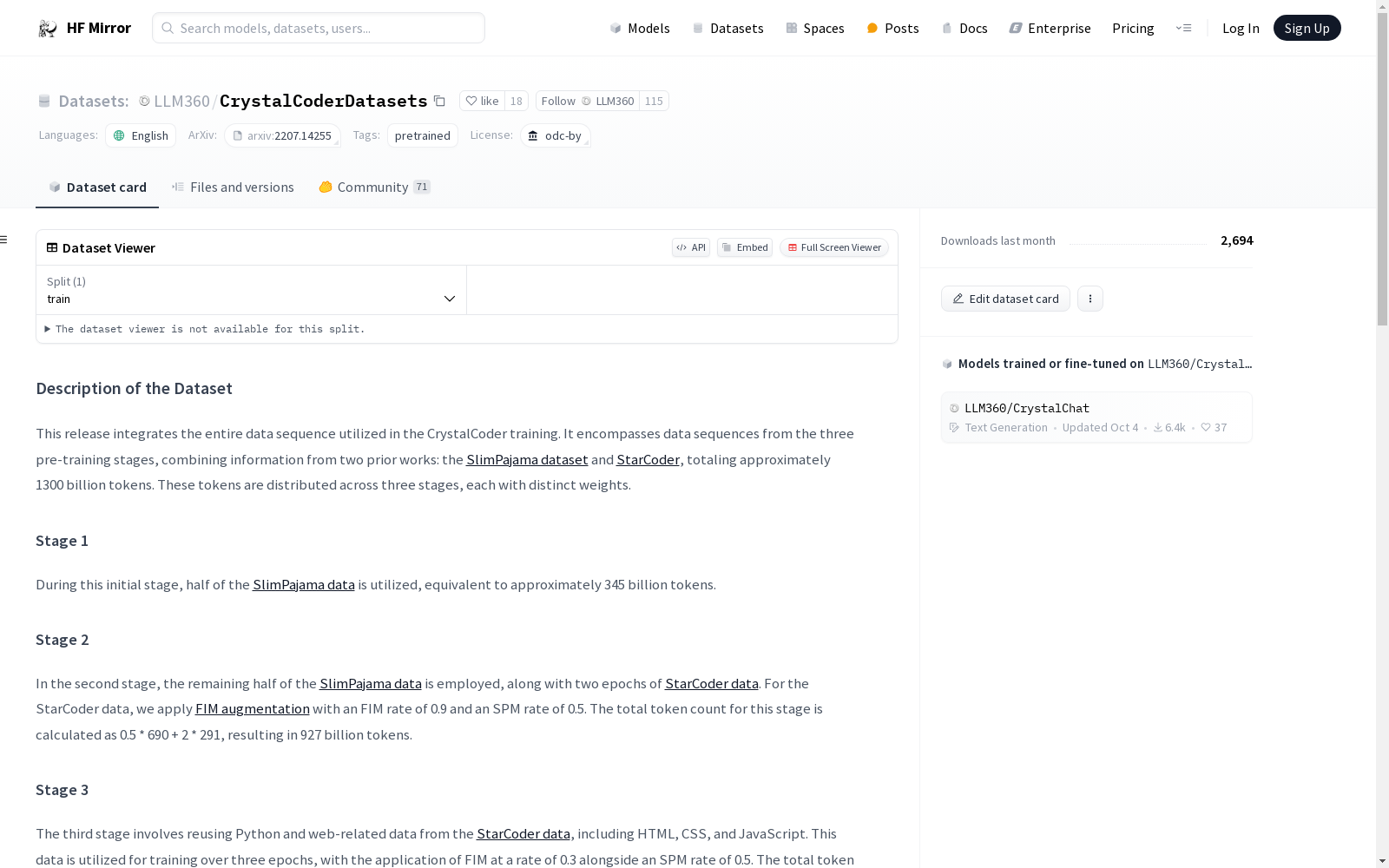

该数据集整合了用于CrystalCoder训练的完整数据序列,包括三个预训练阶段的数据,结合了来自两个先前工作的数据:SlimPajama数据集和StarCoder数据集,总计约13000亿个标记。这些标记分布在三个阶段,每个阶段具有不同的权重。

阶段1

在初始阶段,使用了SlimPajama数据集的一半数据,相当于约3450亿个标记。

阶段2

在第二阶段,使用了SlimPajama数据集的另一半数据,以及两个周期的StarCoder数据集。对于StarCoder数据,应用了FIM增强,FIM率为0.9,SPM率为0.5。该阶段的标记总数为9270亿个。

阶段3

第三阶段涉及重新使用StarCoder数据集中的Python和Web相关数据,包括HTML、CSS和JavaScript。这些数据用于三个周期的训练,FIM率为0.3,SPM率为0.5。该阶段的标记总数为1000亿个。此外,还重新使用了SlimPajama数据集的一小部分(不包括Github部分),贡献了约100亿个标记。

指令调优(阶段3a)

为了增强模型在实际聊天场景中的能力,使用了多种指令调优数据集,总计约10亿个标记。具体数据包括OASST1-guanaco、SlimOrca、ShareGPT_V4.3、Evol-ShareGPT、CodeAlpaca、Rosetta Code、Evol-CodeAlpaca 1、Evol-CodeAlpaca 2和一个通过Alpaca管道生成的关于网站创建的自生成数据集。

主要用途

该数据集作为训练CrystalCoder的基础,并支持进一步的复现。对于从头开始的训练,请参考我们的训练代码。对于从中途检查点开始的训练,请加载检查点中的数据加载器状态,并遵循此教程。

许可证

预训练数据主要来自具有各种许可证的数据源集合。任何使用此处全部或部分数据的行为都必须遵守原始许可证的条款,包括在相关情况下遵守署名条款。我们建议用户参考SlimPajama数据集和StarCoder数据集以获取详细的许可证归属信息。

我们根据ODC-BY发布我们的工作,因此授予对数据集的权利,但不授予数据集内容的个别权利。