LLaVA-NeXT-Data|多模态数据数据集|模型训练数据集

收藏数据集概述

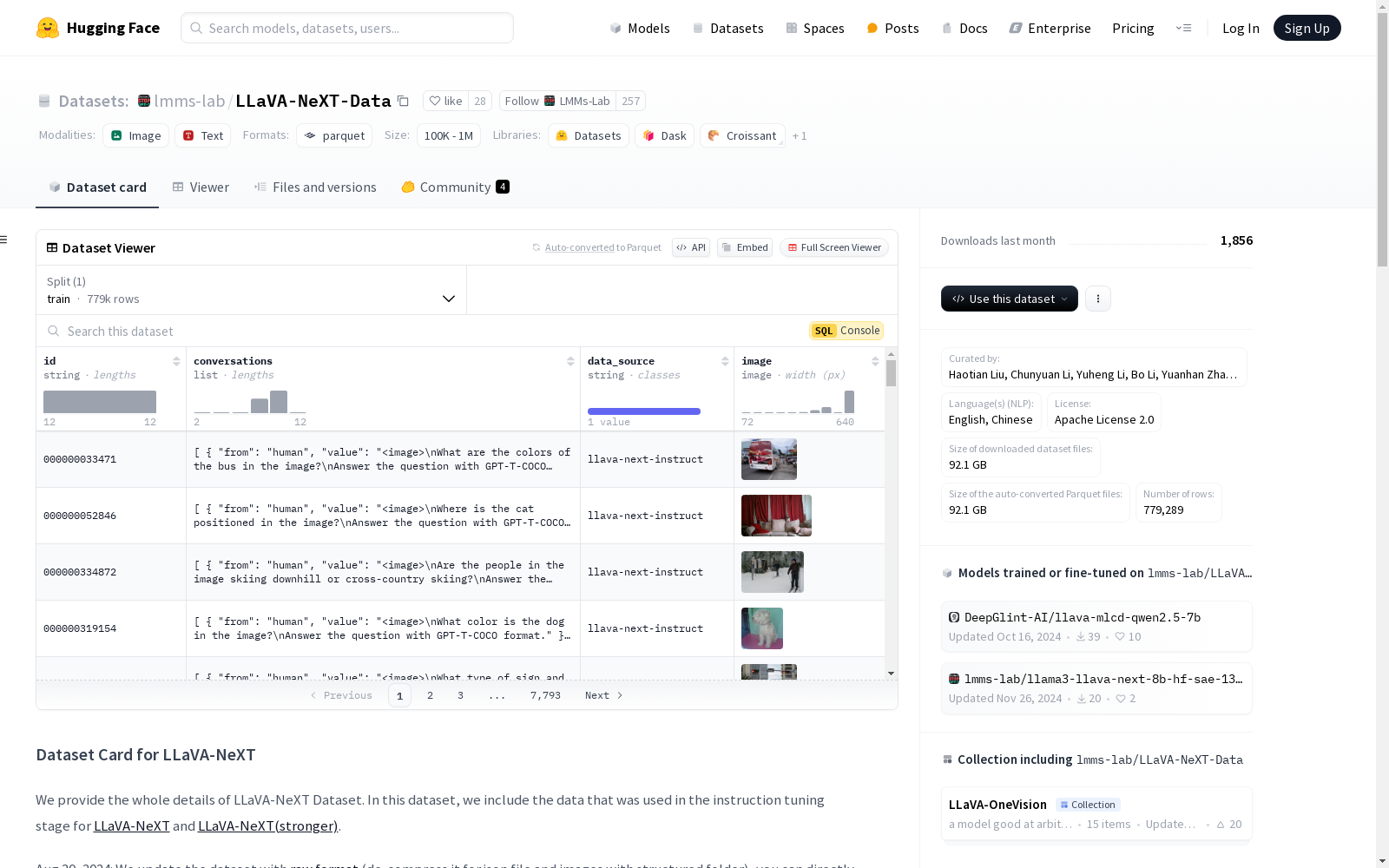

数据集信息

特征

- id: 字符串类型

- conversations: 列表类型

- from: 字符串类型

- value: 字符串类型

- data_source: 字符串类型

- image: 图像类型

分割

- train:

- 字节数: 124810423962.272

- 样本数: 779289

大小

- 下载大小: 92078304318

- 数据集大小: 124810423962.272

配置

- default:

- 数据文件:

- 分割: train

- 路径: data/train-*

- 数据文件:

数据集描述

- 语言: 英语, 中文

- 许可证: Apache License 2.0

- 来源:

- 高质量用户指令数据

- 多模态文档/图表数据

使用

该数据集用于LLaVA-NeXT模型的训练,仅允许用于学术研究和教育目的。

代码指导

提供了将数据集转换为LLaVA-NeXT格式并进行模型训练的代码示例。

引用

@misc{liu2024llavanext, title={LLaVA-NeXT: Improved reasoning, OCR, and world knowledge}, url={https://llava-vl.github.io/blog/2024-01-30-llava-next/}, author={Liu, Haotian and Li, Chunyuan and Li, Yuheng and Li, Bo and Zhang, Yuanhan and Shen, Sheng and Lee, Yong Jae}, month={January}, year={2024} }

数据集作者

- Haotian Liu

- Chunyuan Li

- Yuheng Li

- Bo Li

- Yuanhan Zhang

- Sheng Shen

- Yong Jae Lee

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

Wind Turbine Data

该数据集包含风力涡轮机的运行数据,包括风速、风向、发电量等参数。数据记录了多个风力涡轮机在不同时间点的运行状态,适用于风能研究和风力发电系统的优化分析。

www.kaggle.com 收录

中国交通事故深度调查(CIDAS)数据集

交通事故深度调查数据通过采用科学系统方法现场调查中国道路上实际发生交通事故相关的道路环境、道路交通行为、车辆损坏、人员损伤信息,以探究碰撞事故中车损和人伤机理。目前已积累深度调查事故10000余例,单个案例信息包含人、车 、路和环境多维信息组成的3000多个字段。该数据集可作为深入分析中国道路交通事故工况特征,探索事故预防和损伤防护措施的关键数据源,为制定汽车安全法规和标准、完善汽车测评试验规程、

北方大数据交易中心 收录

YOLO-dataset

该数据集用于训练YOLO模型,包括分类、检测和姿态识别模型。目前支持v8版本,未来计划支持更多版本。

github 收录

YOLO Drone Detection Dataset

为了促进无人机检测模型的开发和评估,我们引入了一个新颖且全面的数据集,专门为训练和测试无人机检测算法而设计。该数据集来源于Kaggle上的公开数据集,包含在各种环境和摄像机视角下捕获的多样化的带注释图像。数据集包括无人机实例以及其他常见对象,以实现强大的检测和分类。

github 收录