StainDoc|文档污渍去除数据集|文档数字化数据集

收藏arXiv2024-10-30 更新2024-11-01 收录

下载链接:

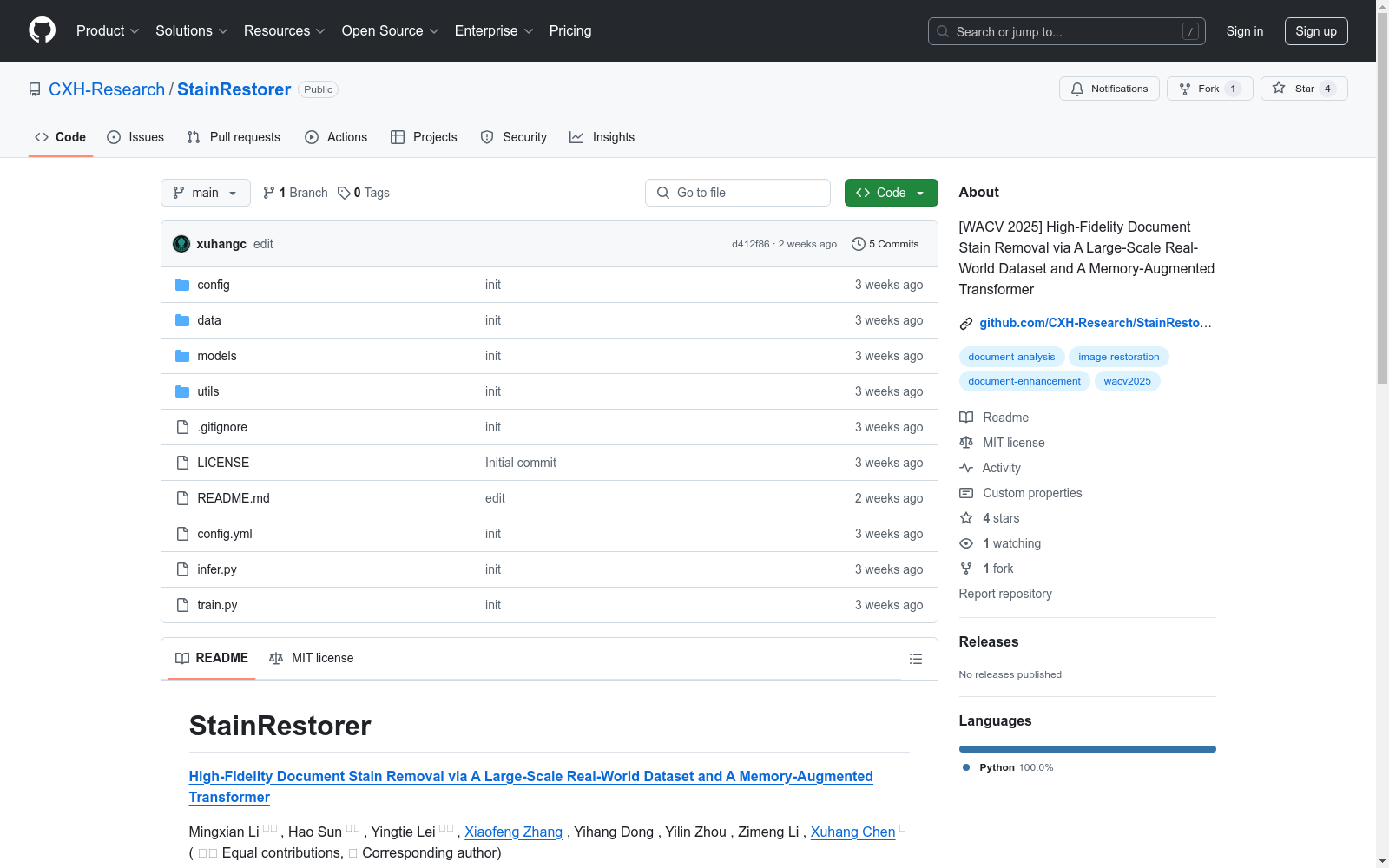

https://github.com/CXH-Research/StainRestorer

下载链接

链接失效反馈资源简介:

StainDoc是由惠州大学计算机科学与工程学院创建的首个大规模高分辨率文档污渍去除数据集,包含超过5000对污渍和清洁文档图像。该数据集涵盖多种污渍类型、严重程度和文档背景,旨在支持文档污渍去除算法的鲁棒训练和评估。数据集的创建过程包括模拟真实世界污渍、控制条件下拍摄和后期处理标准化。StainDoc主要应用于文档数字化和分析领域,旨在解决文档污渍对可读性和下游应用的影响问题。

提供机构:

惠州大学计算机科学与工程学院

创建时间:

2024-10-30

原始信息汇总

StainRestorer 数据集概述

数据集介绍

- 名称: StainDoc

- 描述: StainDoc 是首个大规模高分辨率数据集,专门用于文档污渍去除任务,包含真实世界的数据和对应的地面真值数据。

- 来源: 由 Kaggle 提供。

数据集类型

- 类型: 文档污渍去除

- 子集:

- StainDoc_mark

- StainDoc_seal

数据集生成

- 生成方法: 基于 DocDiff 的处理流程生成。

使用方法

训练

-

下载数据集。

-

在

config.yml文件的 TRAINING 部分指定 TRAIN_DIR、VAL_DIR 和 SAVE_DIR。 -

单 GPU 训练: bash python train.py

-

多 GPU 训练: bash accelerate config accelerate launch train.py

- 如遇

accelerate使用问题,请参考 Accelerate。

- 如遇

推理

- 在

config.yml文件的 TESTING 部分指定 TRAIN_DIR、VAL_DIR 和 SAVE_DIR。 - 运行推理脚本: bash python infer.py

引用

- 暂无引用信息。

AI搜集汇总

数据集介绍

构建方式

为了应对文档图像中常见污渍对可读性和后续应用的严重影响,研究团队构建了StainDoc数据集。该数据集包含超过5,000对污渍和清洁文档图像,分辨率为2145 × 2245,涵盖多种场景。构建过程中,首先收集了约300份多语言文本和图表的文档,模拟了茶、红墨水和蓝墨水等常见污渍,并在一致的照明条件下拍摄。随后,通过标准化的分类和预处理步骤,确保数据集的多样性和一致性。

特点

StainDoc数据集的显著特点在于其大规模、高分辨率和多样性。它不仅包含了多种污渍类型和严重程度,还涵盖了不同的文档背景,从而为训练和评估文档污渍去除算法提供了丰富的资源。此外,数据集的构建过程严格控制了拍摄条件和后期处理,确保了图像质量的一致性,为算法的高效训练和测试提供了坚实基础。

使用方法

StainDoc数据集主要用于训练和评估文档污渍去除算法。研究者可以使用该数据集来训练深度学习模型,如Transformer模型,以实现精确的污渍去除。数据集的多样性和高分辨率特性使其适用于各种文档处理任务,包括光学字符识别(OCR)和文档数字化。通过在StainDoc上的训练和测试,研究者可以开发出能够有效去除污渍并保留文档细节的先进算法。

背景与挑战

背景概述

文档图像常常因各种污渍而降质,显著影响其可读性并阻碍文档数字化和分析等下游应用。现有文档增强方法在去除污渍的同时保留细节方面效果有限,主要原因是缺乏全面的污渍文档数据集。为应对这一挑战,我们构建了StainDoc,这是首个专为文档污渍去除设计的大规模、高分辨率(2145 × 2245)数据集。StainDoc包含超过5,000对污渍和清洁文档图像,涵盖多种场景,包括多样化的污渍类型、严重程度和文档背景,为文档污渍去除算法的鲁棒训练和评估提供了基础。

当前挑战

StainDoc数据集面临的挑战包括:1) 解决文档污渍去除领域的复杂问题,如污渍的多样性和复杂性;2) 在构建过程中遇到的挑战,如高质量图像的获取和处理,以及确保数据集的多样性和代表性。此外,数据集需要处理污渍与文本或图像边缘重叠的情况,以及在去除污渍过程中保持文档细节的完整性。这些挑战要求开发新的算法和技术,以有效去除污渍并保留文档的原始内容。

常用场景

经典使用场景

在文档图像处理领域,StainDoc数据集因其大规模、高分辨率的特点,成为文档污渍去除研究的重要基石。该数据集包含超过5,000对污渍和清洁文档图像,涵盖多种污渍类型、严重程度和文档背景,为训练和评估文档污渍去除算法提供了丰富的资源。研究者利用StainDoc数据集,通过深度学习模型如StainRestorer,实现了对文档中各种污渍的高精度去除,同时保留了文档的细节和完整性。

实际应用

StainDoc数据集在实际应用中展现出广泛的前景,特别是在文档数字化和分析领域。通过使用StainDoc数据集训练的模型,可以有效去除文档中的污渍,提高文档的可读性和视觉质量,从而提升光学字符识别(OCR)的准确性。此外,该数据集在考古学、历史文献保护等领域也有重要应用,帮助恢复和保存珍贵的历史文档,确保其长期保存和研究价值。

衍生相关工作

基于StainDoc数据集,研究者们开发了多种文档污渍去除模型,如StainRestorer,这些模型在去除污渍的同时,保持了文档内容的完整性。此外,StainDoc数据集还激发了相关领域的研究,如文档图像增强、图像修复和视觉Transformer的应用。例如,DocMemory模块和Stain Removal Transformer(SRTransformer)的提出,不仅提升了文档污渍去除的效果,也为其他图像处理任务提供了新的思路和方法。

以上内容由AI搜集并总结生成