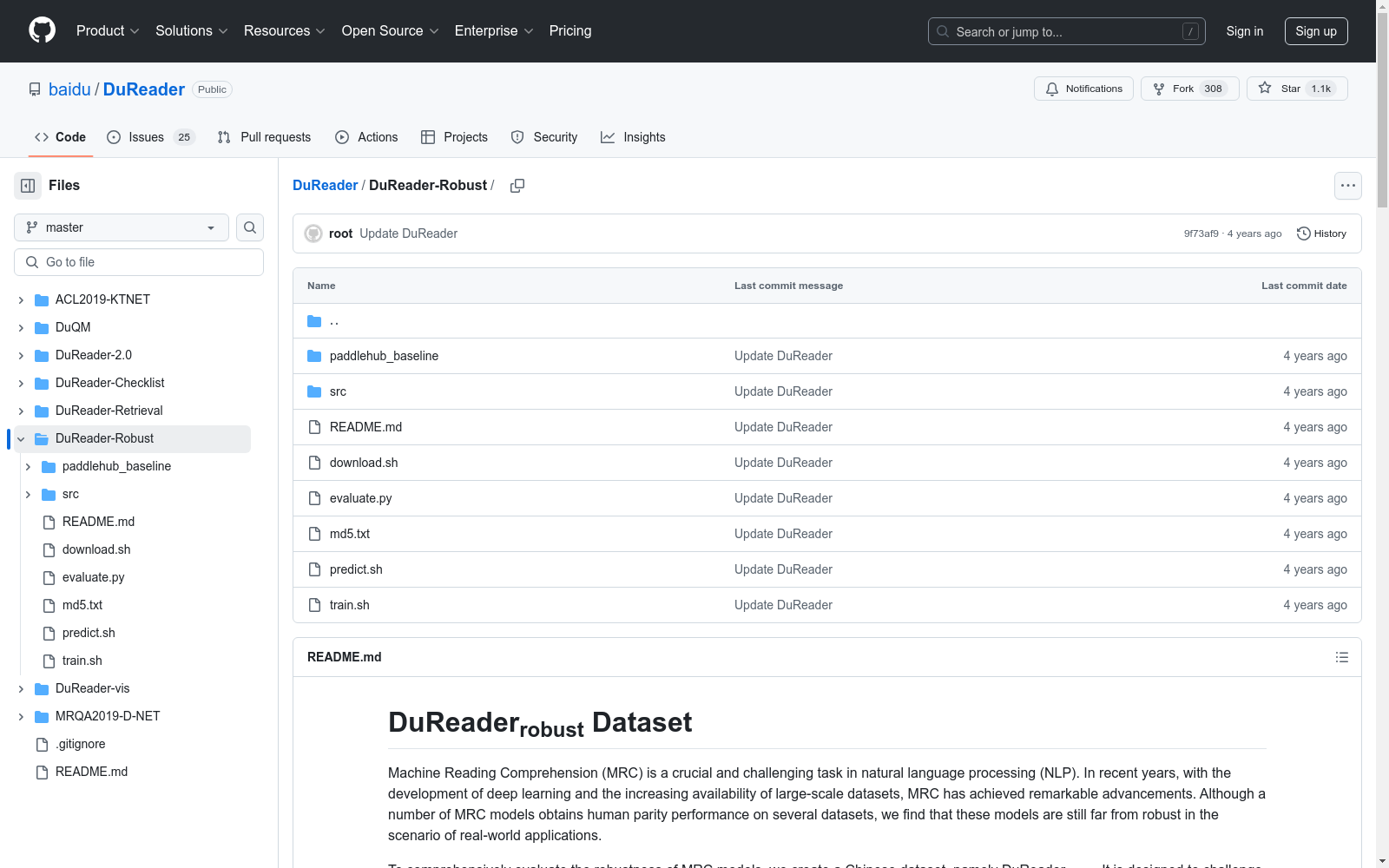

DuReader Robust|中文阅读理解数据集|鲁棒性评估数据集

收藏

Asteroids by the Minor Planet Center

包含所有已知小行星的轨道数据和观测数据。数据来源于Minor Planet Center,格式包括Fortran (.DAT)和JSON,数据集大小为81MB(压缩)和450MB(未压缩),记录数约750,000条,每日更新。

github 收录

Materials Project 在线材料数据库

Materials Project 是一个由伯克利加州大学和劳伦斯伯克利国家实验室于 2011 年共同发起的大型开放式在线材料数据库。这个项目的目标是利用高通量第一性原理计算,为超过百万种无机材料提供全面的性能数据、结构信息和计算模拟结果,以此加速新材料的发现和创新过程。数据库中的数据不仅包括晶体结构和能量特性,还涵盖了电子结构和热力学性质等详尽信息,为研究人员提供了丰富的材料数据资源。相关论文成果为「Commentary: The Materials Project: A materials genome approach to accelerating materials innovation」。

超神经 收录

Tropicos

Tropicos是一个全球植物名称数据库,包含超过130万种植物的名称、分类信息、分布数据、图像和参考文献。该数据库由密苏里植物园维护,旨在为植物学家、生态学家和相关领域的研究人员提供全面的植物信息。

www.tropicos.org 收录

jpft/danbooru2023

Danbooru2023是一个大规模的动漫图像数据集,包含超过500万张由爱好者社区贡献并详细标注的图像。图像标签涵盖角色、场景、版权、艺术家等方面,平均每张图像有30个标签。该数据集可用于训练图像分类、多标签标注、角色检测、生成模型等多种计算机视觉任务。数据集基于danbooru2021构建,扩展至包含ID #6,857,737的图像,增加了超过180万张新图像,总大小约为8TB。图像以原始格式提供,分为1000个子目录,使用图像ID的模1000进行分桶,以避免文件系统性能问题。

hugging_face 收录

UniMed

UniMed是一个大规模、开源的多模态医学数据集,包含超过530万张图像-文本对,涵盖六种不同的医学成像模态:X射线、CT、MRI、超声、病理学和眼底。该数据集通过利用大型语言模型(LLMs)将特定模态的分类数据集转换为图像-文本格式,并结合现有的医学领域的图像-文本数据,以促进可扩展的视觉语言模型(VLM)预训练。

github 收录