有没有相关的论文或文献参考?

这个数据集是基于什么背景创建的?

数据集的作者是谁?

能帮我联系到这个数据集的作者吗?

这个数据集如何下载?

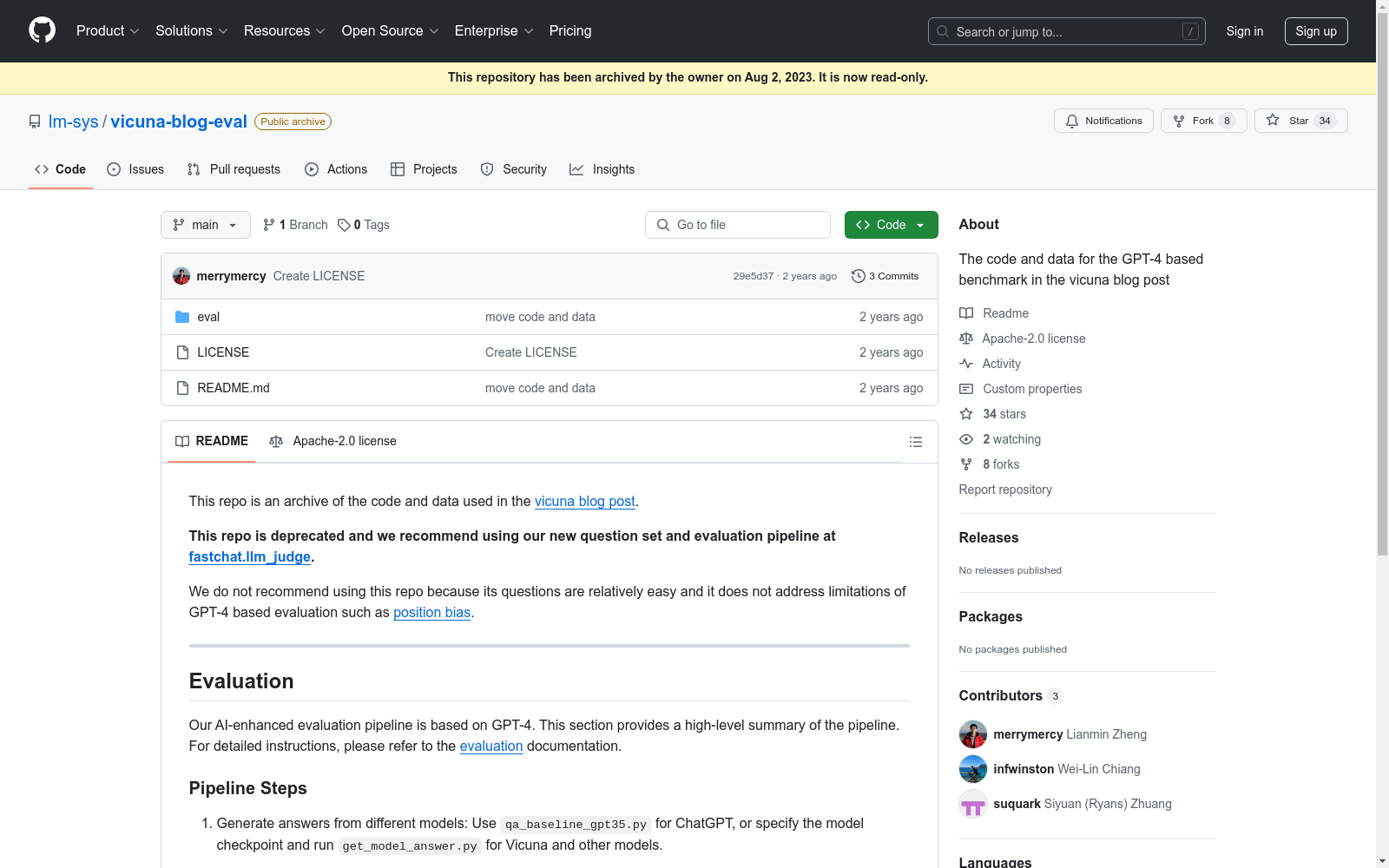

生成模型答案:

qa_baseline_gpt35.pyget_model_answer.py并指定模型检查点生成GPT-4评价:

生成可视化数据:

generate_webpage_data_from_table.py数据可视化:

webpage目录)python3 -m http.server

OpenPose

OpenPose数据集包含人体姿态估计的相关数据,主要用于训练和评估人体姿态检测算法。数据集包括多视角的图像和视频,标注了人体关键点位置,适用于研究人体姿态识别和动作分析。

github.com 收录

Tropicos

Tropicos是一个全球植物名称数据库,包含超过130万种植物的名称、分类信息、分布数据、图像和参考文献。该数据库由密苏里植物园维护,旨在为植物学家、生态学家和相关领域的研究人员提供全面的植物信息。

www.tropicos.org 收录

AIS数据集

该研究使用了多个公开的AIS数据集,这些数据集经过过滤、清理和统计分析。数据集涵盖了多种类型的船舶,并提供了关于船舶位置、速度和航向的关键信息。数据集包括来自19,185艘船舶的AIS消息,总计约6.4亿条记录。

github 收录

CMAB

CMAB数据集由清华大学创建,是中国首个全国范围的多属性建筑数据集,涵盖了3667个自然城市,总面积达213亿平方米。该数据集通过集成多源数据,如高分辨率Google Earth影像和街景图像,生成了建筑的屋顶、高度、功能、年龄和质量等属性。数据集的创建过程结合了地理人工智能框架和机器学习模型,确保了数据的高准确性。CMAB数据集主要应用于城市规划和可持续发展研究,旨在提供详细的城市3D物理和社会结构信息,支持城市化进程和政府决策。

arXiv 收录

URPC系列数据集, S-URPC2019, UDD

URPC系列数据集包括URPC2017至URPC2020DL,主要用于水下目标的检测和分类。S-URPC2019专注于水下环境的特定检测任务。UDD数据集信息未在README中详细描述。

github 收录