THUCNews|新闻分类数据集|文本数据数据集

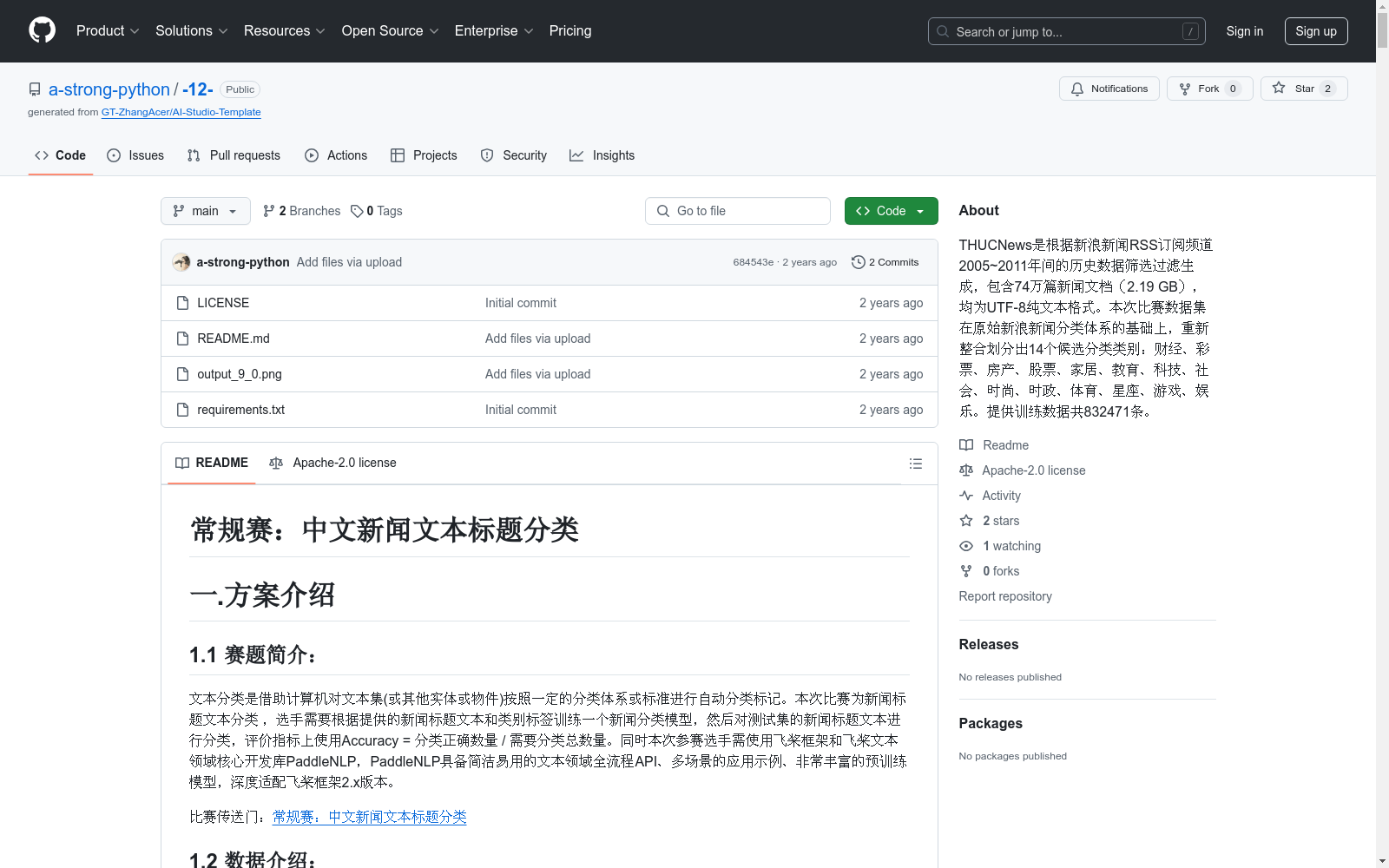

收藏常规赛:中文新闻文本标题分类

1.1 赛题简介

本次比赛为新闻标题文本分类,选手需使用飞桨框架和PaddleNLP训练一个新闻分类模型,对测试集的新闻标题文本进行分类。评价指标为Accuracy。

1.2 数据介绍

数据集THUCNews包含74万篇新闻文档,整合划分出14个分类类别。提供训练数据共832471条,格式为原文标题+ +标签。

1.3 模型思路

在PaddleNLP框架下,通过微调9种预训练模型来训练新闻标题14分类模型,并使用集成学习融合不同模型的处理结果。运行时需选择至尊版的GPU环境。

3.2 定义预训练模型

- roberta-wwm-ext-large

- nezha-large-wwm-chinese

- skep_ernie_1.0_large_ch

- bert-wwm-ext-chinese

- macbert-large-chinese

- huhuiwen/mengzi-bert-base

- junnyu/hfl-chinese-electra-180g-base-discriminator

3.3 数据读取和处理

定义数据集加载函数,处理数据为模型可接受的格式,设置批处理大小和文本序列最大长度。

3.4 设置Fine-Tune优化策略

采用Focal Loss计算损失函数,并使用WarmUp策略避免模型不稳定。

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio 收录

1963-2015年中国主要木本植物春季物候(展叶和开花始期)格网数据产品(V1)

中国物候观测网1963–2015年白蜡、垂柳、刺槐、合欢、桑树、榆树、杏树、紫荆、紫丁香和加拿大杨10种木本植物的展叶始期和开花始期格网数据,时间分辨率为逐年,空间分辨率为0.5°×0.5°。数据集组成包括:(1)数据头文件,内含物种物候期和分布范围格网的头文件信息;(2)物种物候期,内含每个物种展叶始期和开花始期1963–2015年的逐年文件;(3)物种分布范围,内含每个物种的实际分布范围格网。

地球大数据科学工程 收录

Figshare

Figshare是一个在线数据共享平台,允许研究人员上传和共享各种类型的研究成果,包括数据集、论文、图像、视频等。它旨在促进科学研究的开放性和可重复性。

figshare.com 收录

全国景区数据

中华人民共和国旅游景区质量等级共分为五级,从高到低依次为AAAAA、AAAA、AAA、AA、A级五级。5A级景区代表着中国的世界级精品旅游风景区等级。 CnOpenData汇总整理了全国31个省份及直辖市的景区信息,涵盖了景区名称、省份、景区级别、地址、经纬度、简介等字段,为相关研究助力!

CnOpenData 收录

MedDialog

MedDialog数据集(中文)包含了医生和患者之间的对话(中文)。它有110万个对话和400万个话语。数据还在不断增长,会有更多的对话加入。原始对话来自好大夫网。

github 收录