AVA Actions Dataset|动作识别数据集|计算机视觉数据集

收藏AVA Actions Dataset

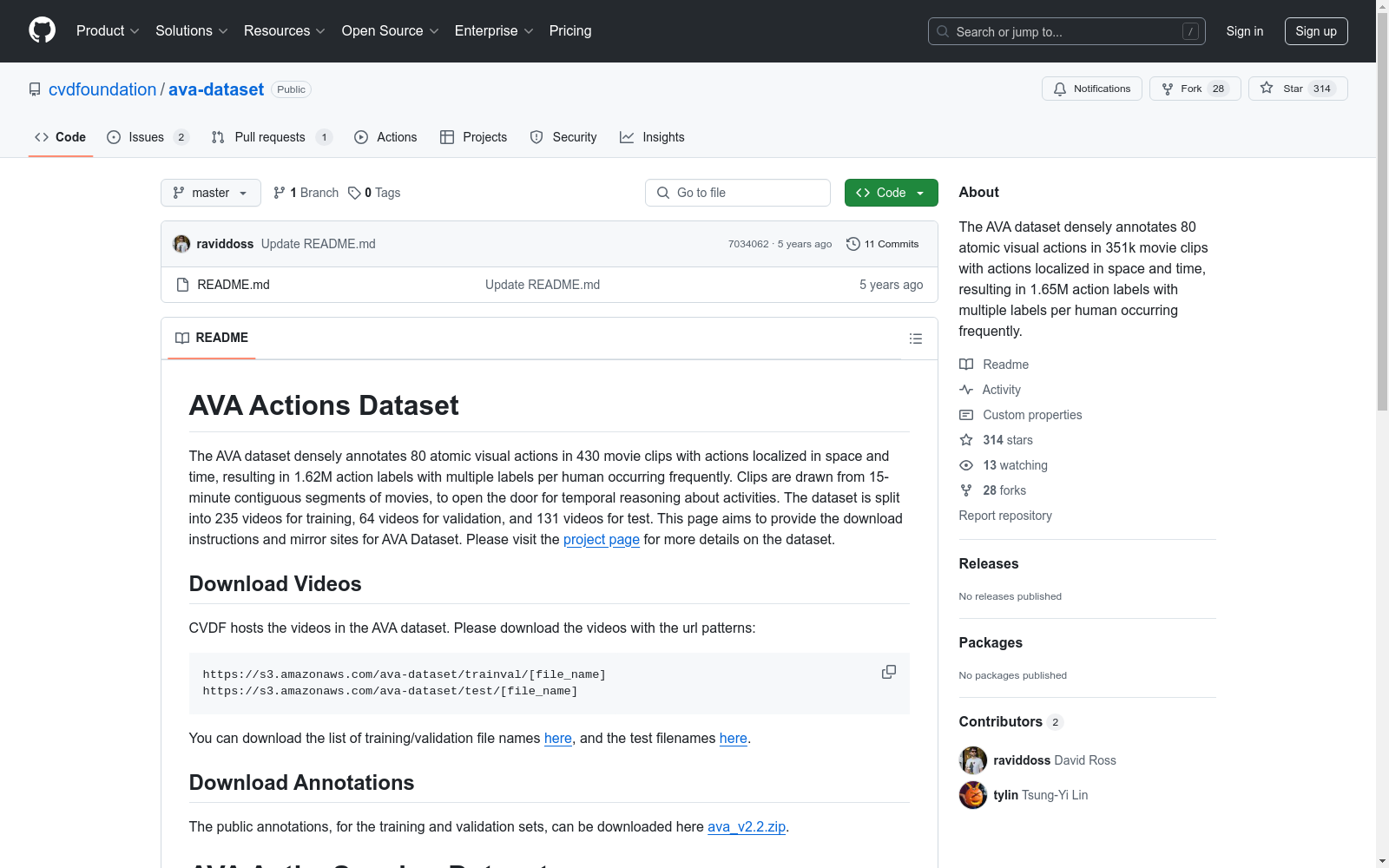

- Description: The AVA dataset annotates 80 atomic visual actions in 430 movie clips, resulting in 1.62M action labels.

- Data Splits: 235 videos for training, 64 videos for validation, and 131 videos for test.

- Video Download URLs:

- Train/Validation:

https://s3.amazonaws.com/ava-dataset/trainval/[file_name] - Test:

https://s3.amazonaws.com/ava-dataset/test/[file_name]

- Train/Validation:

- File Name Lists:

- Training/Validation: ava_file_names_trainval_v2.1.txt

- Test: ava_file_names_test_v2.1.txt

- Annotation Download: ava_v2.2.zip

AVA ActiveSpeaker Dataset

- Description: The dataset labels speaking activity with visible faces on AVA v1.0 videos, totaling 3.65 million frames.

- Video Download URL:

https://s3.amazonaws.com/ava-dataset/trainval/[file_name] - File Name List: ava_speech_file_names_v1.txt

- Annotation Downloads:

- Training: ava_activespeaker_train_v1.0.tar.bz2

- Validation: ava_activespeaker_val_v1.0.tar.bz2

AVA Speech Dataset

- Description: The AVA-Speech dataset annotates speech activity with 3 background noise conditions, totaling ~40K labeled segments.

- Video Download URL:

https://s3.amazonaws.com/ava-dataset/trainval/[file_name] - File Name List: ava_speech_file_names_v1.txt

- Annotation Download: ava_speech_labels_v1.csv

CliMedBench

CliMedBench是一个大规模的中文医疗大语言模型评估基准,由华东师范大学等机构创建。该数据集包含33,735个问题,涵盖14个核心临床场景,主要来源于顶级三级医院的真实电子健康记录和考试练习。数据集的创建过程包括专家指导的数据选择和多轮质量控制,确保数据的真实性和可靠性。CliMedBench旨在评估和提升医疗大语言模型在临床决策支持、诊断和治疗建议等方面的能力,解决医疗领域中模型性能评估的不足问题。

arXiv 收录

中国知识产权局专利数据库

该数据集包含了中国知识产权局发布的专利信息,涵盖了专利的申请、授权、转让等详细记录。数据内容包括专利号、申请人、发明人、申请日期、授权日期、专利摘要等。

www.cnipa.gov.cn 收录

中国空气质量数据集(2014-2020年)

数据集中的空气质量数据类型包括PM2.5, PM10, SO2, NO2, O3, CO, AQI,包含了2014-2020年全国360个城市的逐日空气质量监测数据。监测数据来自中国环境监测总站的全国城市空气质量实时发布平台,每日更新。数据集的原始文件为CSV的文本记录,通过空间化处理生产出Shape格式的空间数据。数据集包括CSV格式和Shape格式两数数据格式。

国家地球系统科学数据中心 收录

Interaction Dataset

Interaction Dataset是一个用于处理和可视化交通场景的数据集,支持轨迹预测挑战,包括三个不同的预测模型训练和测试轨道。

github 收录

LibriSpeech

LibriSpeech 是一个大约 1000 小时的 16kHz 英语朗读语音语料库,由 Vassil Panayotov 在 Daniel Povey 的协助下编写。数据来自 LibriVox 项目的已读有声读物,并经过仔细分割和对齐。

OpenDataLab 收录