mvarma/medwiki|医学信息处理数据集|自然语言处理数据集

收藏数据集概述

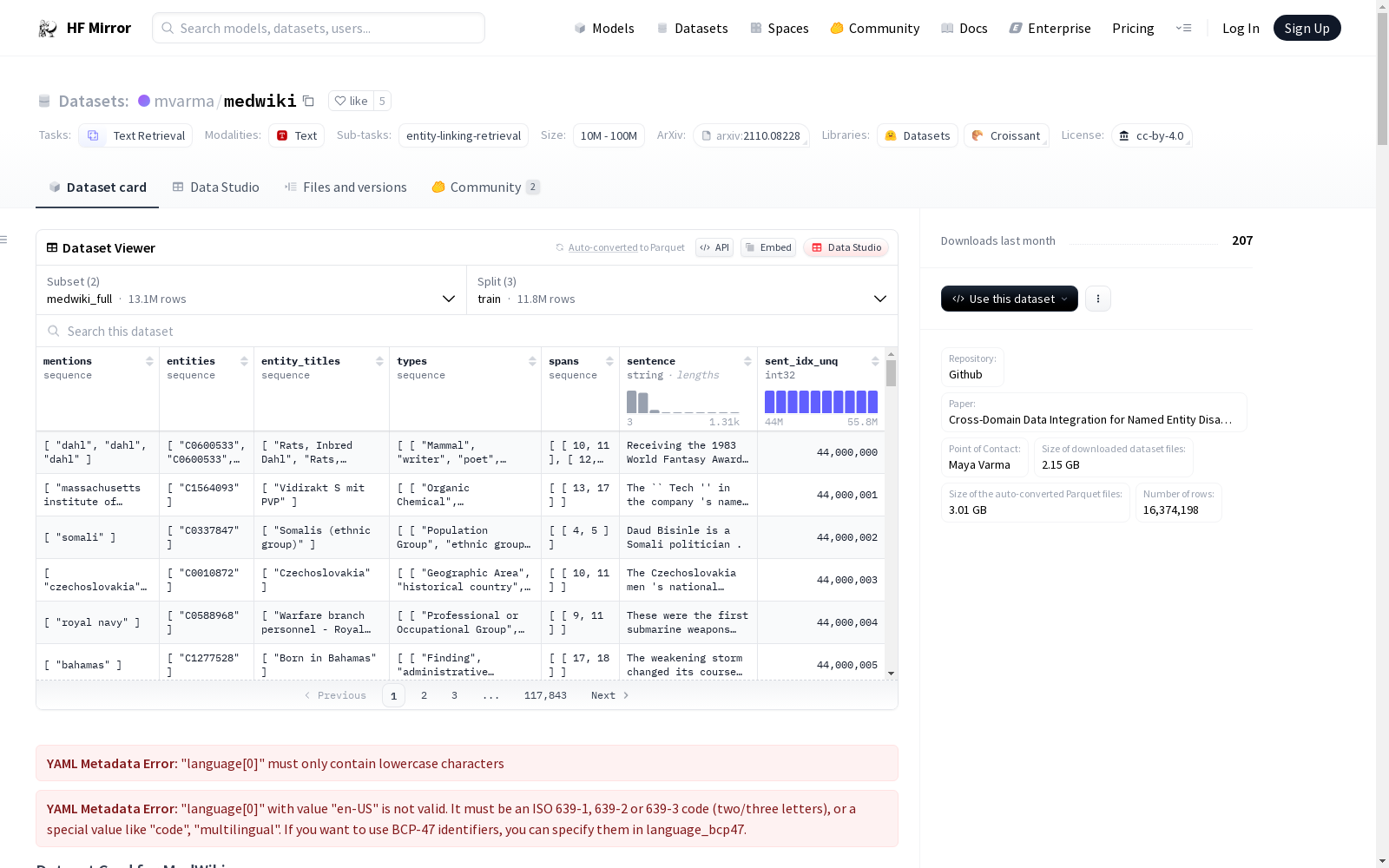

名称: MedWiki

语言: 英语 (en-US, en)

许可证: CC-BY-4.0

多语言性: 单语种

数据集大小: 未知

来源数据集: 扩展自Wikipedia

任务类别: 文本检索

任务ID: 实体链接检索

数据集描述

数据集总结: MedWiki是一个从医学相关的Wikipedia子集中收集的大规模句子数据集,注释了来自统一医学语言系统(UMLS)知识库的生物医学实体。数据集包含超过1300万句子及1700万实体注释,可作为语言模型的预训练资源,并能提升医学命名实体识别和消歧系统的性能,特别是对于罕见实体。

数据集结构:

- 数据实例: 每个数据点包含一个来自Wikipedia的句子,注释了UMLS医学实体及其相关的标题和类型。

- 数据字段: 包括

sent_idx_unq(唯一标识符)、sentence(句子文本)、mentions(医学提及)、entities(实体标识)、entity_titles(实体标题)、types(实体类型)和spans(提及的词范围)。 - 数据分割: 数据集分为

MedWiki-Full和MedWiki-HQ两种配置,每种配置的数据被分割为训练、开发和测试集。

数据集创建

来源数据:

- 初始数据收集和标准化: 数据来自2019年11月的英文Wikipedia转储,页面按80/10/10的比例分割为训练/开发/测试集,并进一步按句子级别分割。

- 源语言生产者: 英文Wikipedia的编辑。

注释:

- 注释过程: 使用弱标签技术创建

MedWiki-Full和MedWiki-HQ两种配置。MedWiki-Full通过内部页面链接和基于代词及替代实体名称的弱标签生成黄金实体标签。MedWiki-HQ则是MedWiki-Full的子集,具有更高质量的标签。

使用数据集的考虑

社会影响: 数据集旨在促进更好的生物医学文本命名实体识别系统的创建,特别是针对罕见或不常见实体。

偏见讨论: 数据来源于英文Wikipedia,可能存在由编辑者引起的偏见,尽管这种偏见在医学文章中可能较少。

其他已知限制:

由于使用弱标签技术,实体注释可能存在噪声。为解决此问题,提供了具有更高质量标签的MedWiki-HQ配置。

LFW

人脸数据集;LFW数据集共有13233张人脸图像,每张图像均给出对应的人名,共有5749人,且绝大部分人仅有一张图片。每张图片的尺寸为250X250,绝大部分为彩色图像,但也存在少许黑白人脸图片。 URL: http://vis-www.cs.umass.edu/lfw/index.html#download

AI_Studio 收录

VoxBox

VoxBox是一个大规模语音语料库,由多样化的开源数据集构建而成,用于训练文本到语音(TTS)系统。

github 收录

中国行政区划shp数据

中国行政区划数据是重要的基础地理信息数据,目前不同来源的全国行政区划数据非常多,但能够开放获取的高质量行政区域数据少之又少。基于此,锐多宝的地理空间制作一套2013-2023年可开放获取的高质量行政区划数据。该套数据以2022年国家基础地理信息数据中的县区划数据作为矢量基础,辅以高德行政区划数据、天地图行政区划数据,参考历年来民政部公布的行政区划为属性基础,具有时间跨度长、属性丰富、国界准确、更新持续等特性。 中国行政区划数据统计截止时间是2023年2月12日,包含省、市、县、国界、九段线等矢量shp数据。该数据基于2020年行政区划底图,按时间顺序依次制作了2013-2023年初的行政区划数据。截止2023年1月1日,我国共有34个省级单位,分别是4个直辖市、23个省、5个自治区和2个特别行政区。截止2023年1月1日,我国共有333个地级单位,分别是293个地级市、7个地区、30个自治州和3个盟,其中38个矢量要素未纳入统计(比如直辖市北京等、特别行政区澳门等、省直辖县定安县等)。截止2023年1月1日,我国共有2843个县级单位,分别是1301个县、394个县级市、977个市辖区、117个自治县、49个旗、3个自治旗、1个特区和1个林区,其中9个矢量要素未纳入县级类别统计范畴(比如特别行政区香港、无县级单位的地级市中山市东莞市等)。

CnOpenData 收录

jpft/danbooru2023

Danbooru2023是一个大规模的动漫图像数据集,包含超过500万张由爱好者社区贡献并详细标注的图像。图像标签涵盖角色、场景、版权、艺术家等方面,平均每张图像有30个标签。该数据集可用于训练图像分类、多标签标注、角色检测、生成模型等多种计算机视觉任务。数据集基于danbooru2021构建,扩展至包含ID #6,857,737的图像,增加了超过180万张新图像,总大小约为8TB。图像以原始格式提供,分为1000个子目录,使用图像ID的模1000进行分桶,以避免文件系统性能问题。

hugging_face 收录

威廉王岛—全球变化数据大百科辞条

威廉王岛(King William Island)位于北美洲,北极圈内,属于加拿大北极群岛。它位于维多利亚岛和布西亚半岛之间,距离维多利亚岛85 km;北面距离威尔士亲王岛155 km;南面隔斯托里斯海峡和辛普森海峡与北美洲大陆(阿德莱德半岛)相望,最近处只有3.3 km。威廉王岛于1830年被指挥官詹姆斯.罗斯(James Ross)发现,以当时在位的英国君主威廉四世的名字命名。行政区划上,威廉王岛隶属于加拿大努纳武特(Nunavut)地区。它的地理位置为:69°54′22″N - 68°27′12″N,99°32′48″W - 95°09′25″W。威廉王岛总面积13259.59 km²,海岸线总长1555.35 km。岛屿地势平坦,表面散布着无数的小湖。位于岛屿东南侧的约阿港(Gjoa Haven)是岛上最主要的居民点。在约阿港东北,有一机场。该数据集是基于Google Earth遥感影像全球多尺度海陆(岛)岸线数据集(2015),结合加拿大相关地图完成。数据集由24个数据文件组成,以.kmz和.shp数据格式存储,数据量2.98 MB(压缩成3个数据文件,数据量2.06 MB)。

国家对地观测科学数据中心 收录