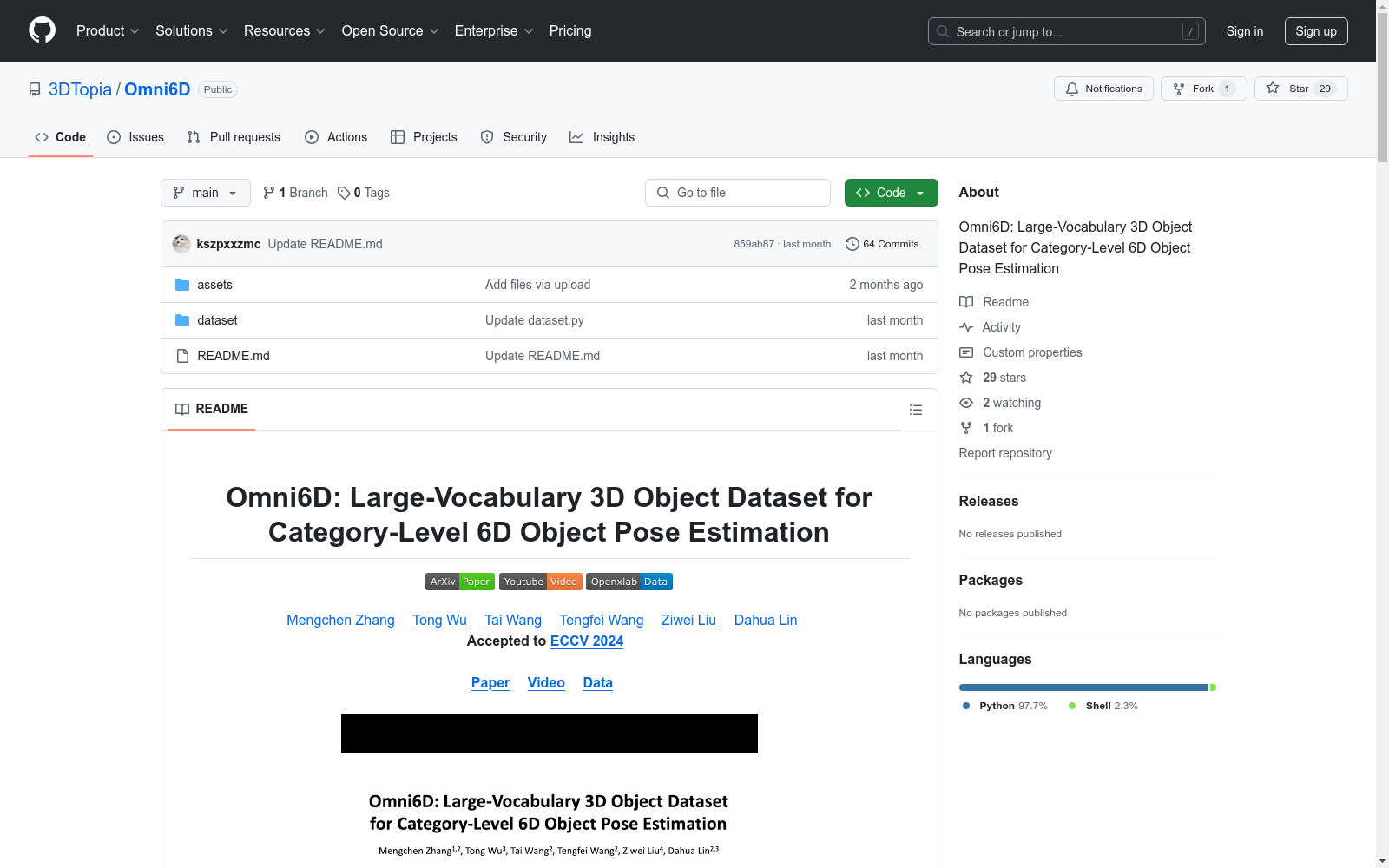

Omni6D|6D物体姿态估计数据集|计算机视觉数据集

收藏Omni6D: Large-Vocabulary 3D Object Dataset for Category-Level 6D Object Pose Estimation

数据集概述

Omni6D 是一个用于类别级6D物体姿态估计的大词汇量3D物体数据集。该数据集包含多个版本,包括 Omni6D、Omni6D-xl 和 Omni6D-Real。

更新记录

- 2024年7月:发布 Omni6D 数据集。

- 2024年9月:发布 Omni6D-xl 和 Omni6D-Real 数据集。

数据集下载

-

注册并登录 OpenDataLab。

-

安装 OpenDataLab 的 CLI 工具:

pip install openxlab。 -

使用以下命令下载数据集: bash openxlab login # 登录,输入 AK/SK openxlab dataset info --dataset-repo kszpxxzmcwww/Omni6D # 查看数据集信息 openxlab dataset ls --dataset-repo kszpxxzmcwww/Omni6D # 查看数据集文件列表 openxlab dataset get --dataset-repo kszpxxzmcwww/Omni6D # 下载整个数据集(压缩文件约需388.9GB存储空间)

-

如果遇到

401: {"msg":"login required"}错误,请使用以下 AK/SK:AK: bmyqk5wpbaxl6x1vkzq9 SK: nl7kq9palyr6j3pwxolden7ezq4dwjmbgdm81yeo

-

可以通过指定路径下载部分数据: bash openxlab dataset download --dataset-repo kszpxxzmcwww/Omni6D --source-path /raw/Omni6D_V1/CAMERA/test --target-path <your-target-path>

数据集格式

Omni6D(-xl) 数据集结构

Omni6D(-xl) ├── info │ ├── sym_info.csv │ ├── <train/val/test/test_unseen>list.txt ├── shape_data │ ├── camera<train/val/test/test_unseen>.pkl │ ├── ShapeNetCore_<2048/4096>.h5 │ ├── ShapeNetCore_unseen_<2048/4096>.h5 │ ├── mean_embedding.npy │ ├── mean_points_emb.npy ├── CAMERA │ ├── <train/val/test/test_unseen> │ │ ├── <scene_id> │ │ │ ├── <render_id>_color.png │ │ │ ├── <render_id>_depth.png │ │ │ ├── <render_id>_coord.png │ │ │ ├── <render_id>_mask.png │ │ │ ├── <render_id>_meta.txt │ │ │ ├── <render_id>_label.pkl

Omni6D_Real 数据集结构

Omni6D_Real │ ├── <scene_id> │ │ ├── <capture_id>_color.png │ │ ├── <capture_id>_depth.png │ │ ├── <capture_id>_mask.png │ │ ├── <capture_id>_mask.png │ │ ├── <capture_id>_label.pkl

基准测试

Omni6D 数据集上的类别级性能

| 方法 | 网络类型 | $IoU_{50}$ | $IoU_{75}$ | $5^circ2cm$ | $5^circ5cm$ | $10^circ2cm$ | $10^circ5cm$ | $5^circ$ | $10^circ$ | $2cm$ | $5cm$ |

|---|---|---|---|---|---|---|---|---|---|---|---|

| SPD | implicit | 44.56 | 20.37 | 7.55 | 9.56 | 14.76 | 19.23 | 10.68 | 21.02 | 37.49 | 70.09 |

| SGPA | implicit | 36.34 | 14.44 | 4.78 | 6.84 | 10.13 | 15.03 | 8.49 | 17.73 | 25.57 | 59.18 |

| DualPoseNet | hybrid | 58.84 | 25.49 | 8.28 | 9.30 | 17.26 | 19.05 | 9.38 | 19.18 | 73.82 | 96.37 |

| RBP-Pose | hybrid | 35.92 | 4.66 | 0.37 | 0.60 | 0.53 | 0.80 | 0.75 | 0.96 | 39.73 | 83.55 |

| GPV-Pose | explicit | 15.28 | 0.26 | 0.10 | 0.70 | 0.14 | 0.96 | 2.25 | 2.96 | 5.31 | 33.70 |

| HS-Pose | explicit | 62.65 | 23.02 | 4.26 | 4.85 | 10.49 | 11.61 | 4.96 | 11.75 | 80.93 | 97.78 |

Omni6D-xl 数据集上的类别级性能

| 方法 | 网络类型 | $IoU_{50}$ | $IoU_{75}$ | $5^circ2cm$ | $5^circ5cm$ | $10^circ2cm$ | $10^circ5cm$ | $5^circ$ | $10^circ$ | $2cm$ | $5cm$ |

|---|---|---|---|---|---|---|---|---|---|---|---|

| SPD | implicit | 42.28 | 16.73 | 3.42 | 6.47 | 6.45 | 12.16 | 10.62 | 17.71 | 21.05 | 54.14 |

| SGPA | implicit | 37.62 | 12.48 | 2.45 | 5.56 | 5.12 | 10.98 | 10.25 | 17.88 | 16.21 | 47.31 |

| DualPoseNet | hybrid | 59.15 | 24.26 | 5.92 | 7.24 | 10.74 | 13.00 | 7.70 | 13.72 | 65.05 | 87.44 |

| RBP-Pose | hybrid | 41.21 | 6.55 | 0.52 | 1.63 | 0.59 | 1.74 | 3.02 | 3.20 | 23.20 | 57.27 |

| GPV-Pose | explicit | 17.01 | 1.42 | 0.51 | 1.90 | 0.55 | 2.07 | 5.08 | 5.72 | 5.19 | 26.32 |

| HS-Pose | explicit | 62.92 | 26.50 | 4.98 | 6.26 | 8.81 | 10.73 | 6.65 | 11.39 | 71.68 | 89.38 |

许可证

OmniObject3D 数据集采用 CC BY 4.0 许可证。

引用

@misc{zhang2024omni6dlargevocabulary3dobject, title={Omni6D: Large-Vocabulary 3D Object Dataset for Category-Level 6D Object Pose Estimation}, author={Mengchen Zhang and Tong Wu and Tai Wang and Tengfei Wang and Ziwei Liu and Dahua Lin}, year={2024}, eprint={2409.18261}, archivePrefix={arXiv}, primaryClass={cs.CV}, url={https://arxiv.org/abs/2409.18261}, }

中国食物成分数据库

食物成分数据比较准确而详细地描述农作物、水产类、畜禽肉类等人类赖以生存的基本食物的品质和营养成分含量。它是一个重要的我国公共卫生数据和营养信息资源,是提供人类基本需求和基本社会保障的先决条件;也是一个国家制定相关法规标准、实施有关营养政策、开展食品贸易和进行营养健康教育的基础,兼具学术、经济、社会等多种价值。 本数据集收录了基于2002年食物成分表的1506条食物的31项营养成分(含胆固醇)数据,657条食物的18种氨基酸数据、441条食物的32种脂肪酸数据、130条食物的碘数据、114条食物的大豆异黄酮数据。

国家人口健康科学数据中心 收录

AgiBot World

为了进一步推动通用具身智能领域研究进展,让高质量机器人数据触手可及,作为上海模塑申城语料普惠计划中的一份子,智元机器人携手上海人工智能实验室、国家地方共建人形机器人创新中心以及上海库帕思,重磅发布全球首个基于全域真实场景、全能硬件平台、全程质量把控的百万真机数据集开源项目 AgiBot World。这一里程碑式的开源项目,旨在构建国际领先的开源技术底座,标志着具身智能领域 「ImageNet 时刻」已到来。AgiBot World 是全球首个基于全域真实场景、全能硬件平台、全程质量把控的大规模机器人数据集。相比于 Google 开源的 Open X-Embodiment 数据集,AgiBot World 的长程数据规模高出 10 倍,场景范围覆盖面扩大 100 倍,数据质量从实验室级上升到工业级标准。AgiBot World 数据集收录了八十余种日常生活中的多样化技能,从抓取、放置、推、拉等基础操作,到搅拌、折叠、熨烫等精细长程、双臂协同复杂交互,几乎涵盖了日常生活所需的绝大多数动作需求。

github 收录

VQA

我们提出了自由形式和开放式视觉问答 (VQA) 的任务。给定图像和关于图像的自然语言问题,任务是提供准确的自然语言答案。反映许多现实世界的场景,例如帮助视障人士,问题和答案都是开放式的。视觉问题有选择地针对图像的不同区域,包括背景细节和底层上下文。因此,与生成通用图像说明的系统相比,在 VQA 上取得成功的系统通常需要对图像和复杂推理有更详细的理解。此外,VQA 适合自动评估,因为许多开放式答案仅包含几个单词或一组封闭的答案,可以以多项选择的形式提供。我们提供了一个数据集包含 100,000 的图像和问题并讨论它提供的信息。提供了许多 VQA 基线,并与人类表现进行了比较。

OpenDataLab 收录

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

MultiTalk

MultiTalk数据集是由韩国科学技术院创建,包含超过420小时的2D视频,涵盖20种不同语言,旨在解决多语言环境下3D说话头生成的问题。该数据集通过自动化管道从YouTube收集,每段视频都配有语言标签和伪转录,部分视频还包含伪3D网格顶点。数据集的创建过程包括视频收集、主动说话者验证和正面人脸验证,确保数据质量。MultiTalk数据集的应用领域主要集中在提升多语言3D说话头生成的准确性和表现力,通过引入语言特定风格嵌入,使模型能够捕捉每种语言独特的嘴部运动。

arXiv 收录