TUT Acoustic Scenes 2016|声学场景分类数据集|音频数据数据集

收藏

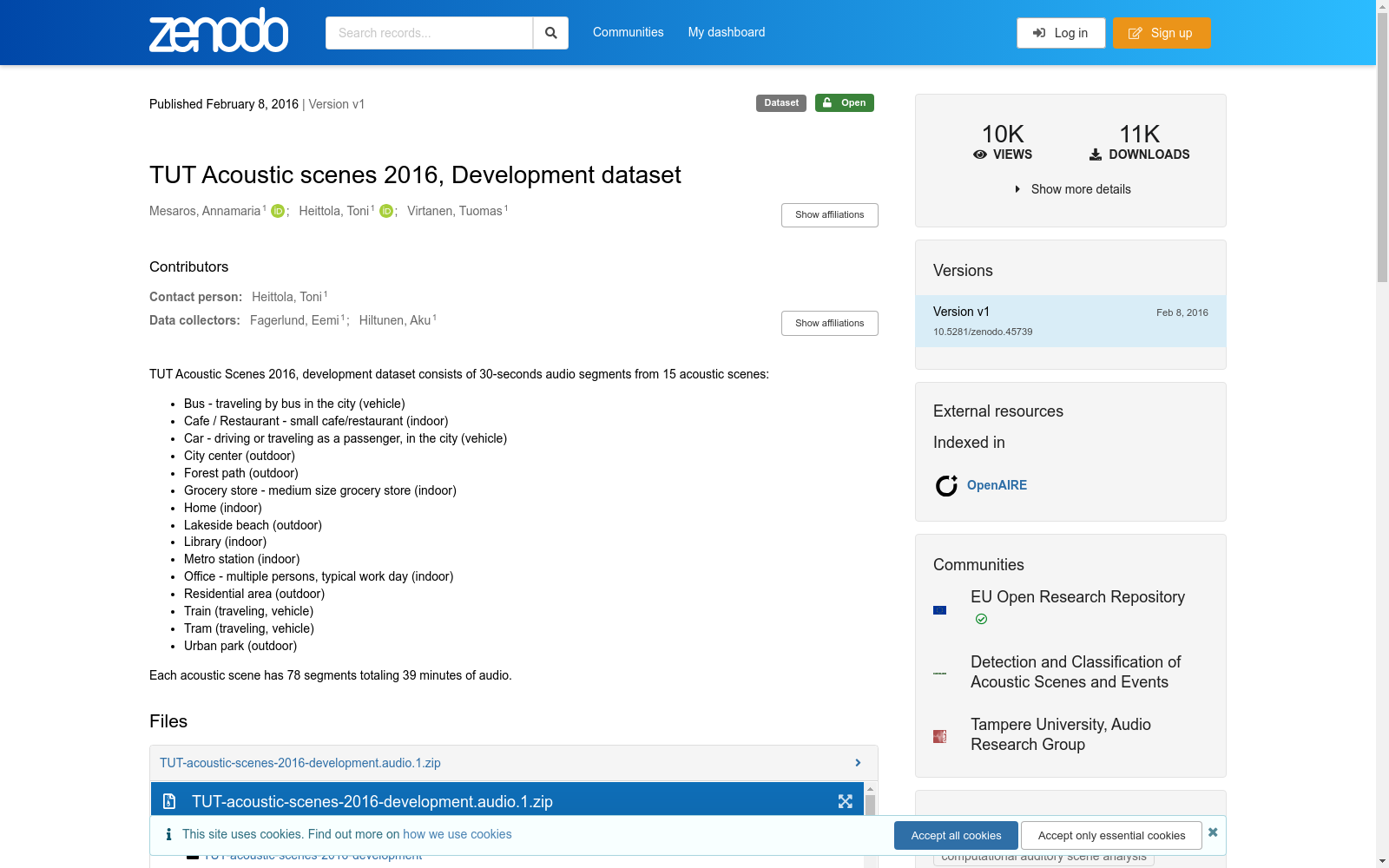

- TUT Acoustic Scenes 2016数据集首次发布,作为DCASE 2016挑战赛的一部分,旨在促进环境声音分类的研究。

- TUT Acoustic Scenes 2016数据集在多个研究论文中被引用和应用,展示了其在环境声音分类任务中的有效性。

- 该数据集继续被广泛用于各种声学场景分类算法的研究和开发,成为该领域的一个基准数据集。

NEPSE Open Data

首个尼泊尔证券交易所(NEPSE)的开源金融数据集,旨在提高尼泊尔资本市场的透明度、学习和创新。

github 收录

MAV-VID, Drone-vs-Bird, Anti-UAV

本研究涉及三个数据集:MAV-VID、Drone-vs-Bird和Anti-UAV,总计包含241个视频,共计331,486张图像。这些数据集由杜伦大学创建,用于无人机视觉检测和跟踪的研究。数据集内容丰富,包括从地面和无人机搭载的摄像头捕获的图像,涵盖了多种环境和条件。创建过程中,数据集经过精心标注和处理,以确保数据质量。这些数据集主要用于评估和改进无人机检测和跟踪技术,特别是在复杂环境和动态场景中的应用。

arXiv 收录

CE-CSL

CE-CSL数据集是由哈尔滨工程大学智能科学与工程学院创建的中文连续手语数据集,旨在解决现有数据集在复杂环境下的局限性。该数据集包含5,988个从日常生活场景中收集的连续手语视频片段,涵盖超过70种不同的复杂背景,确保了数据集的代表性和泛化能力。数据集的创建过程严格遵循实际应用导向,通过收集大量真实场景下的手语视频材料,覆盖了广泛的情境变化和环境复杂性。CE-CSL数据集主要应用于连续手语识别领域,旨在提高手语识别技术在复杂环境中的准确性和效率,促进聋人与听人社区之间的无障碍沟通。

arXiv 收录

学生课堂行为数据集 (SCB-dataset3)

学生课堂行为数据集(SCB-dataset3)由成都东软学院创建,包含5686张图像和45578个标签,重点关注六种行为:举手、阅读、写作、使用手机、低头和趴桌。数据集覆盖从幼儿园到大学的不同场景,通过YOLOv5、YOLOv7和YOLOv8算法评估,平均精度达到80.3%。该数据集旨在为学生行为检测研究提供坚实基础,解决教育领域中学生行为数据集的缺乏问题。

arXiv 收录

DeepMIMO dataset

DeepMIMO数据集是一个公开的数据集生成框架,用于模拟多种无线通信环境。该数据集特别适用于大规模MIMO和毫米波应用,通过精确的射线追踪数据构建信道模型。数据集包含多个场景,每个场景都有详细的参数设置,如频率、带宽、基站天线配置等。这些参数可以根据研究需求进行调整,以生成符合特定研究目的的数据集。DeepMIMO数据集广泛用于无线通信系统的定位和性能评估研究,特别是在5G及未来通信技术中。

arXiv 收录