ScanNet|计算机视觉数据集|3D语义分割数据集

收藏

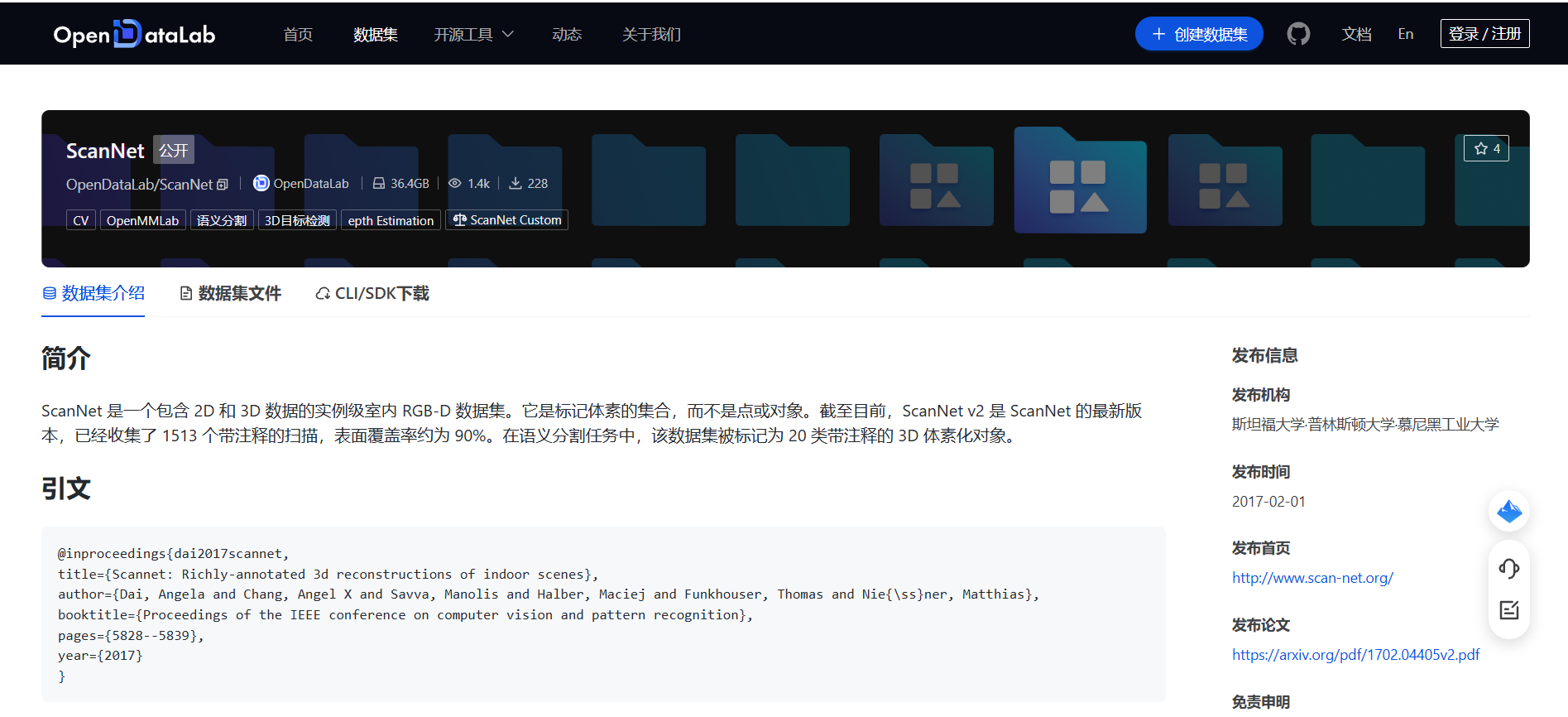

- ScanNet数据集首次发表,由Angela Dai等人在CVPR会议上提出,旨在为室内场景提供高质量的三维重建数据。

- ScanNet数据集首次应用于三维语义分割任务,显著提升了相关算法在室内场景中的表现。

- ScanNet数据集被广泛用于多个计算机视觉研究项目,包括物体检测、场景理解等,成为室内场景研究的重要基准。

- ScanNet数据集的扩展版本发布,增加了更多的场景和物体类别,进一步丰富了数据集的内容和多样性。

- ScanNet数据集在多个国际竞赛中被用作基准数据集,推动了三维计算机视觉领域的技术进步。

hoskinson-center/proof-pile

`proof-pile`是一个13GB的数学文本预训练数据集,包含83亿个标记(使用`gpt-neox`分词器)。该数据集由多种非正式和正式数学文本来源组成,包括ArXiv.math(10GB)、开源数学教科书(50MB)、形式数学库(500MB)、Math Overflow和Math Stack Exchange(2.5GB)、Wiki风格来源(50MB)以及MATH数据集(6MB)。数据集构建过程可复现,并提供了详细的预处理步骤和过滤条件。

hugging_face 收录

ct-scans-of-brain

这是一个包含超过70,000个研究案例的脑部CT扫描数据集,旨在帮助研究人员在医学成像领域进行研究,特别是针对大脑病损的检测和分析,包括脑肿瘤、脑出血和脑癌等五种病损类型。数据集包含有协议和无协议的研究案例,适用于计算机视觉任务。

huggingface 收录

Global Flood Database (GFD)

全球洪水数据库(GFD)是一个包含全球范围内洪水事件记录的数据集。该数据集提供了详细的洪水事件信息,包括洪水发生的时间、地点、影响范围、受灾人口和财产损失等。数据集的目的是为了支持洪水风险评估、灾害管理和气候变化研究。

global-flood-database.cloudtostreet.info 收录

HotpotQA

HotpotQA 是收集在英语维基百科上的问答数据集,包含大约 113K 众包问题,这些问题的构建需要两篇维基百科文章的介绍段落才能回答。数据集中的每个问题都带有两个黄金段落,以及这些段落中的句子列表,众包工作人员认为这些句子是回答问题所必需的支持事实。 HotpotQA 提供了多种推理策略,包括涉及问题中缺失实体的问题、交叉问题(什么满足属性 A 和属性 B?)和比较问题,其中两个实体通过一个共同属性进行比较等。在少文档干扰设置中,QA 模型有 10 个段落,保证能找到黄金段落;在开放域全维基设置中,模型只给出问题和整个维基百科。模型根据其答案准确性和可解释性进行评估,其中前者被测量为具有完全匹配 (EM) 和 unigram F1 的预测答案和黄金答案之间的重叠,后者关注预测的支持事实句子与人类注释的匹配程度(Supporting Fact EM/F1)。该数据集还报告了一个联合指标,它鼓励系统同时在两项任务上表现良好。 来源:通过迭代查询生成回答复杂的开放域问题

OpenDataLab 收录

Traditional-Chinese-Medicine-Dataset-SFT

该数据集是一个高质量的中医数据集,主要由非网络来源的内部数据构成,包含约1GB的中医各个领域临床案例、名家典籍、医学百科、名词解释等优质内容。数据集99%为简体中文内容,质量优异,信息密度可观。数据集适用于预训练或继续预训练用途,未来将继续发布针对SFT/IFT的多轮对话和问答数据集。数据集可以独立使用,但建议先使用配套的预训练数据集对模型进行继续预训练后,再使用该数据集进行进一步的指令微调。数据集还包含一定比例的中文常识、中文多轮对话数据以及古文/文言文<->现代文翻译数据,以避免灾难性遗忘并加强模型表现。

huggingface 收录