Open-X Embodiment (OXE) 数据集|机器人技术数据集|深度学习数据集

收藏🦊 Robo-DM 数据集概述

基本信息

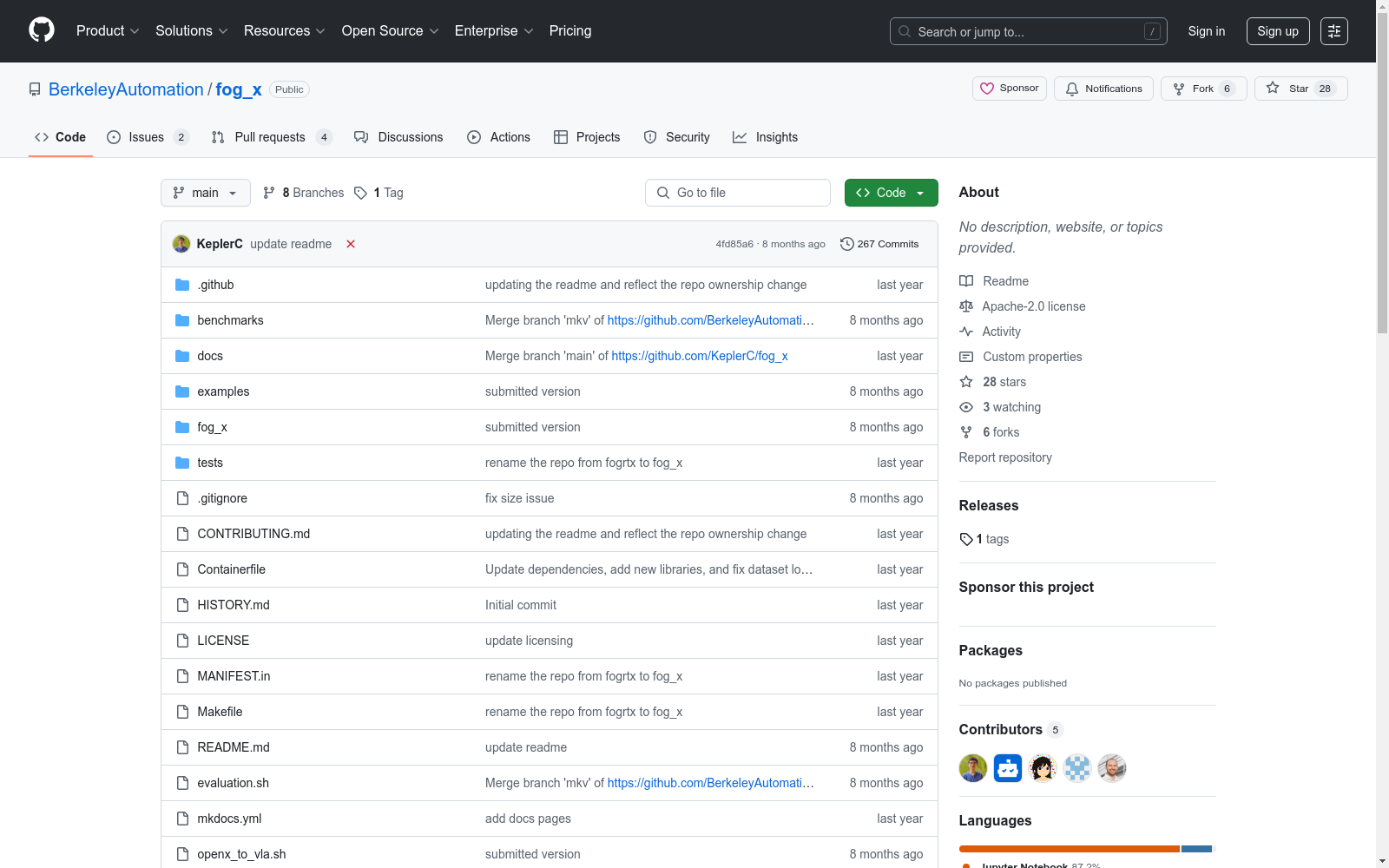

- 名称: Robo-DM (原名称: fog_x)

- 类型: 机器人学习数据收集与管理框架

- 支持平台:

- Open-X-Embodiment (https://robotics-transformer-x.github.io/)

- HuggingFace (https://huggingface.co/)

核心特性

- 高效性: 兼顾速度与内存效率,支持主动元数据和延迟加载轨迹数据

- 灵活性: 支持分布式数据集分区

- 云存储: 提供原生云存储支持

- 可视化: 提供数据集可视化工具 (https://keplerc.github.io/openxvisualizer/)

技术文档

- 设计文档: https://docs.google.com/document/d/1woLQVLWsySGjFuz8aCsaLoc74dXQgIccnWRemjlNDws/edit#heading=h.irrfcedesnvr

安装方法

bash git clone https://github.com/BerkeleyAutomation/fog_x.git cd fog_x pip install -e .

使用示例

python import fog_x

数据收集

path = "/tmp/output.vla" traj = fog_x.Trajectory(path=path) traj.add(feature="arm_view", value="image1.jpg") traj.close()

数据加载

fog_x.Trajectory(path=path)

示例代码

- 数据收集与加载: ./examples/data_collection_and_load.py

- 从Open_X转换: ./examples/openx_loader.py

- 从H5转换: ./examples/h5_loader.py

- 运行基准测试: ./benchmarks/openx.py

开发指南

- 贡献指南: CONTRIBUTING.md

- 1Robo-DM: Data Management For Large Robot Datasets加利福尼亚大学伯克利分校, 谷歌DeepMind · 2025年

中国陆域及周边逐日1km全天候地表温度数据集(TRIMS LST;2000-2024)

地表温度(Land surface temperature, LST)是地球表面与大气之间界面的重要参量之一。它既是地表与大气能量交互作用的直接体现,又对于地气过程具有复杂的反馈作用。因此,地表温度不仅是气候变化的敏感指示因子和掌握气候变化规律的重要前提,还是众多模型的直接输入参数,在许多领域有广泛的应用,如气象气候、环境生态、水文等。伴随地学及相关领域研究的深入和精细化,学术界对卫星遥感的全天候地表温度(All-weather LST)具有迫切的需求。 本数据集的制备方法是增强型的卫星热红外遥感-再分析数据集成方法。方法的主要输入数据为Terra/Aqua MODIS LST产品和GLDAS等数据,辅助数据包括卫星遥感提供的植被指数、地表反照率等。方法充分利用了卫星热红外遥感和再分析数据提供的地表温度高频分量、低频分量以及地表温度的空间相关性,最终重建得到较高质量的全天候地表温度数据集。 评价结果表明,本数据集具有良好的图像质量和精度,不仅在空间上无缝,还与当前学术界广泛采用的逐日1 km Terra/Aqua MODIS LST产品在幅值和空间分布上具有较高的一致性。当以MODIS LST为参考时,该数据集在白天和夜间的平均偏差(MBE)为0.09K和-0.03K,偏差标准差(STD)为1.45K和1.17K。基于19个站点实测数据的检验结果表明,其MBE为-2.26K至1.73K,RMSE为0.80K至3.68K,且在晴空与非晴空条件下无显著区别。 本数据集的时间分辨率为逐日4次,空间分辨率为1km,时间跨度为2000年-2024年;空间范围包括我国陆域的主要区域(包含港澳台地区,暂不包含我国南海诸岛)及周边区域(72°E-135°E,19°N-55°N)。本数据集的缩写名为TRIMS LST(Thermal and Reanalysis Integrating Moderate-resolution Spatial-seamless LST),以便用户使用。需要说明的是,TRIMS LST的空间子集TRIMS LST-TP(中国西部逐日1 km全天候地表温度数据集(TRIMS LST-TP;2000-2024)V2)同步在国家青藏高原科学数据中心发布,以减少相关用户数据下载和处理的工作量。

国家青藏高原科学数据中心 收录

VisDrone 2021

VisDrone2021 数据集由天津大学机器学习与数据挖掘实验室 AISKYEYE 团队收集。基准数据集由 400 个视频片段组成,由 265,228 帧和 10,209 张静态图像组成,由各种无人机摄像头拍摄,涵盖了广泛的方面,包括位置(取自中国相隔数千公里的 14 个不同城市)、环境(城市和乡村)、物体(行人、车辆、自行车等)和密度(稀疏和拥挤的场景)。请注意,数据集是使用各种无人机平台(即具有不同型号的无人机)、在不同场景以及各种天气和照明条件下收集的。这些框架使用超过 260 万个边界框或经常感兴趣的目标点进行手动注释,例如行人、汽车、自行车和三轮车。为了更好地利用数据,还提供了一些重要的属性,包括场景可见性、对象类别和遮挡。

OpenDataLab 收录

中国行政区划数据

本项目为中国行政区划数据,包括省级、地级、县级、乡级和村级五级行政区划数据。数据来源于国家统计局,存储格式为sqlite3 db文件,支持直接使用数据库连接工具打开。

github 收录

VisDrone2019

VisDrone2019数据集由AISKYEYE团队在天津大学机器学习和数据挖掘实验室收集,包含288个视频片段共261,908帧和10,209张静态图像。数据集覆盖了中国14个不同城市的城市和乡村环境,包括行人、车辆、自行车等多种目标,以及稀疏和拥挤场景。数据集使用不同型号的无人机在各种天气和光照条件下收集,手动标注了超过260万个目标边界框,并提供了场景可见性、对象类别和遮挡等重要属性。

github 收录

CWD30

CWD30包含超过219,770张20种杂草和10种作物的高分辨率图像,涵盖了不同的生长阶段、多个观察角度和环境条件。这些图像是从不同地理位置和季节的多样化农业领域收集的,确保了数据集的代表性。

github 收录