ViSTa|视觉语言模型数据集|强化学习数据集

收藏arXiv2024-11-22 更新2024-11-22 收录

下载链接:

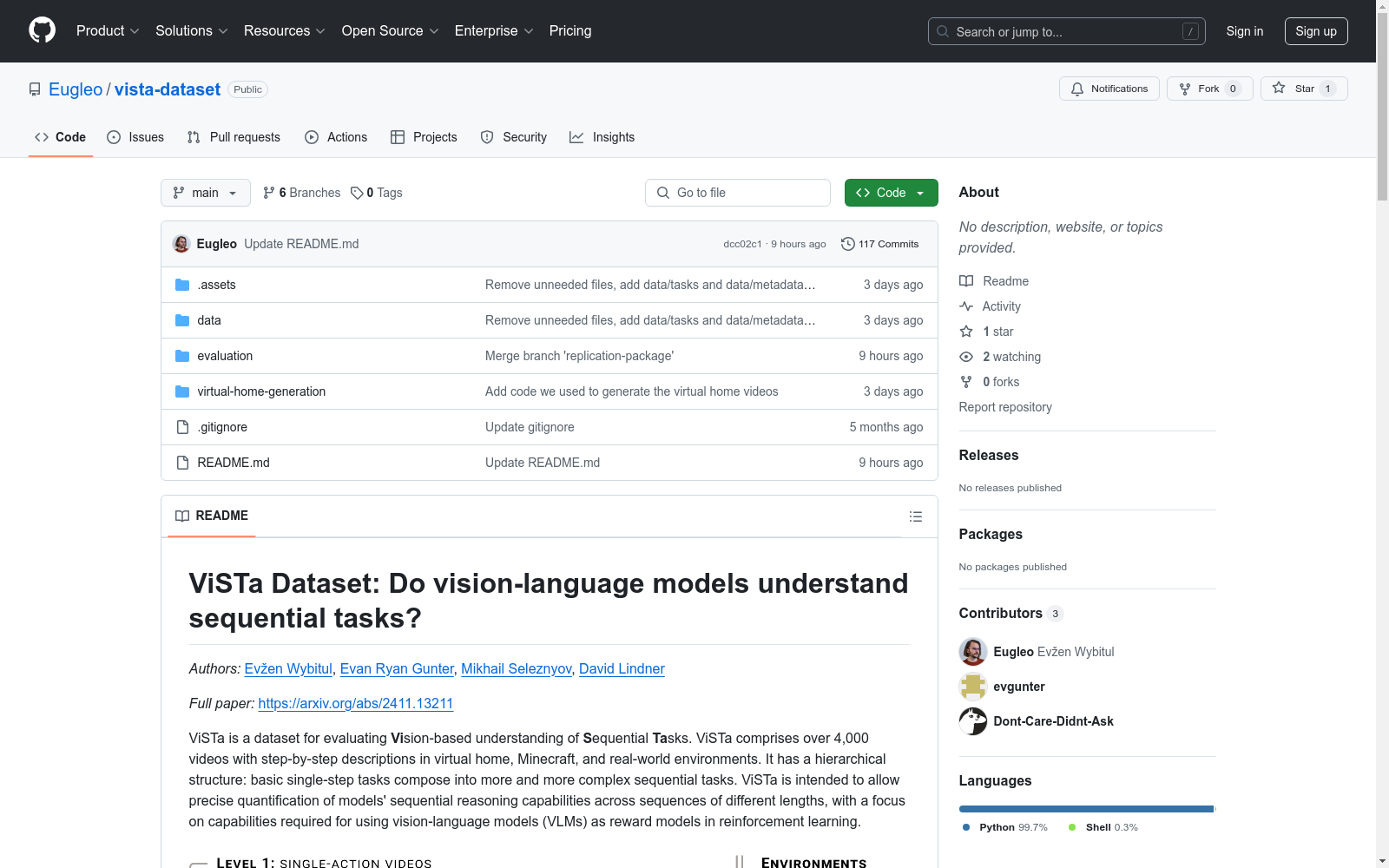

https://github.com/Eugleo/vista-dataset

下载链接

链接失效反馈资源简介:

ViSTa数据集由Google DeepMind创建,旨在评估视觉语言模型(VLM)对顺序任务的理解能力。该数据集包含超过4000个视频,涵盖虚拟家庭、Minecraft和现实世界三种环境,视频配有逐步描述。数据集采用分层结构,从基本的单步任务逐渐组合成更复杂的顺序任务,以细粒度地测试VLM在不同复杂度任务中的表现。创建过程中,数据集结合了现有数据集的视频,并通过手动拍摄和编辑增加了新的视频。ViSTa主要应用于强化学习中,旨在解决VLM作为奖励模型在顺序任务中的应用问题。

提供机构:

Google DeepMind

创建时间:

2024-11-20

原始信息汇总

ViSTa 数据集概述

数据集简介

ViSTa 是一个用于评估视觉-语言模型对顺序任务理解的基准数据集。该数据集包含超过 4,000 个视频,涵盖虚拟家庭、Minecraft 和真实世界环境中的逐步描述。数据集具有层次结构,从基本的单步任务逐渐组合成更复杂的顺序任务。

数据集结构

- 视频数量: 超过 4,000 个视频

- 环境: 虚拟家庭、Minecraft、真实世界

- 层次结构: 从单步任务到多步任务,级别从 1 到 8

数据集内容

视频级别

- Level 1: 单步任务视频,测试基本动作识别

- Level 2 至 Level 8: 多步任务视频,测试动作顺序理解

问题集

- Objects: 测试对象识别

- Object properties: 测试对象属性检测

- Actions: 测试特定动作理解

- General problems: 测试一般顺序任务理解

- Permutation problems: 测试动作顺序理解

数据集下载

- 视频: 可从 Google Cloud Storage 下载

- 元数据表和问题集: 位于

data/目录下

数据集使用

- 元数据表字段:

video: 视频文件路径description: 视频描述level: 视频级别environment: 录制环境problem_set_type: 问题集类型problem_set_id: 问题集标识符

环境

- Virtual home: 包含超过 3,000 个视频,主要来自 ALFRED 数据集

- Real world: 包含超过 1,100 个视频,部分来自 Kinetics-700 数据集

- Minecraft: 包含 53 个视频,部分来自 BASALT 基准

当前视觉-语言模型评估结果

- 评估模型: CLIP、ViCLIP、GPT-4o

- 结果: GPT-4o 表现优于开源模型,所有模型在对象识别上表现良好,但在对象属性和动作识别上表现较差,无法很好地理解任务序列。

AI搜集汇总

数据集介绍

构建方式

ViSTa数据集的构建旨在评估视觉语言模型(VLMs)在理解序列任务方面的能力。该数据集包含超过4,000个视频,涵盖虚拟家庭、Minecraft和真实世界三种环境,每个视频都配有详细的步骤描述。ViSTa采用了一种层次结构,从基本的单步任务逐渐组合成更复杂的序列任务,这种结构使得能够细致地评估VLMs在不同复杂度任务中的表现。数据集的构建过程中,部分视频来源于现有的ALFRED数据集,并通过重新混合和编辑生成新的视频,以确保测试特定能力的视频集的多样性和复杂性。

使用方法

ViSTa数据集适用于评估和训练视觉语言模型在序列任务中的表现。使用该数据集时,研究人员可以将视频和描述对输入模型,通过模型对视频内容的理解和描述匹配程度来评估其性能。具体方法包括使用模型生成视频的描述,然后与数据集中的描述进行对比,计算匹配度。此外,数据集的分层结构和问题集设计使得可以针对模型的特定能力进行有针对性的训练和评估,从而优化模型在复杂任务中的表现。

背景与挑战

背景概述

ViSTa数据集由Evžen Wybitul、Evan Ryan Gunter、Mikhail Seleznyov和David Lindner等研究人员于2024年创建,旨在评估视觉语言模型(VLMs)在理解顺序任务方面的能力。该数据集包含超过4,000个视频,涵盖虚拟家庭、Minecraft和真实世界环境中的步骤描述。ViSTa的独特层次结构由基本的单步任务组成,逐渐组合成更复杂的顺序任务,从而能够细致地理解VLMs在处理不同复杂度任务时的表现。该数据集的引入对强化学习领域具有重要意义,特别是在使用VLMs作为奖励模型以降低成本和提高安全性方面。

当前挑战

ViSTa数据集面临的挑战主要集中在两个方面。首先,构建过程中遇到的挑战包括在不同环境中生成和编辑视频,确保视频的逻辑连贯性和视觉一致性。其次,该数据集旨在解决的领域问题是评估VLMs在顺序任务中的表现,特别是它们是否能够理解任务的顺序和复杂性。当前的研究表明,尽管VLMs在物体识别方面表现出色,但在理解顺序任务方面仍存在显著不足,这限制了它们在复杂任务监督中的应用潜力。

常用场景

经典使用场景

ViSTa数据集的经典使用场景在于评估视觉语言模型(VLMs)在理解序列任务中的能力。通过提供超过4,000个视频及其逐步描述,ViSTa允许研究人员细致地测试VLMs在虚拟家庭、Minecraft和现实世界环境中的表现。其独特的层次结构——从基本的单步任务到越来越复杂的序列任务——使得能够精确评估VLMs在不同复杂度任务中的表现。

解决学术问题

ViSTa数据集解决了学术界在评估视觉语言模型(VLMs)理解序列任务能力方面的常见问题。传统上,VLMs主要用于目标导向任务,而ViSTa通过提供详细的序列任务描述,填补了这一空白。这不仅有助于理解VLMs在复杂任务中的表现,还为开发更可靠和高效的强化学习奖励模型提供了基础。

实际应用

ViSTa数据集在实际应用中具有广泛潜力,特别是在需要复杂序列决策的领域,如机器人学和游戏设计。通过使用ViSTa训练和评估模型,开发者可以创建能够理解和执行多步骤任务的智能系统,从而提高自动化和智能化的水平。此外,ViSTa还可以用于开发更安全和成本效益更高的强化学习系统。

数据集最近研究

最新研究方向

在视觉语言模型(VLMs)的最新研究中,ViSTa数据集的引入为评估模型在序列任务中的理解能力提供了新的视角。该数据集通过在虚拟家庭、Minecraft和现实世界环境中收集的超过4,000个视频,以及详细的步骤描述,构建了一个层次化的任务结构。研究者们利用ViSTa数据集对包括CLIP、ViCLIP和GPT-4o在内的前沿VLMs进行了评估,发现尽管这些模型在物体识别方面表现出色,但在理解复杂序列任务时仍存在显著挑战。特别是,GPT-4o在处理非基本任务时表现出了一定的能力,而其他模型则几乎无法胜任。这一发现强调了当前VLMs在监督复杂任务方面的不足,并为未来的研究指明了改进方向,特别是在提高模型对动作顺序和任务序列理解能力方面。

相关研究论文

- 1ViSTa Dataset: Do vision-language models understand sequential tasks?Google DeepMind · 2024年

以上内容由AI搜集并总结生成